02.04

【World MR News】マイクロソフトが考える『HoloLens 2』とMR技術で実現する新たな世界――「XR Kaigi 2019」レポートその①

2019年12月3日と4日の2日間、東京・秋葉原で国内最大級のVR/AR/MRのカンファレンス「XR Kaigi 2019」が開催された。本イベントでは40以上のセッションが実施され、XRに感心のあるすべての開発者やクリエイター向けの内容となっていた。本稿ではその中から、12月4日に行われた日本マイクロソフトMixed Reality Marketing プロダクトマネージャー上田欣典氏によるセッションの模様をお届けする。

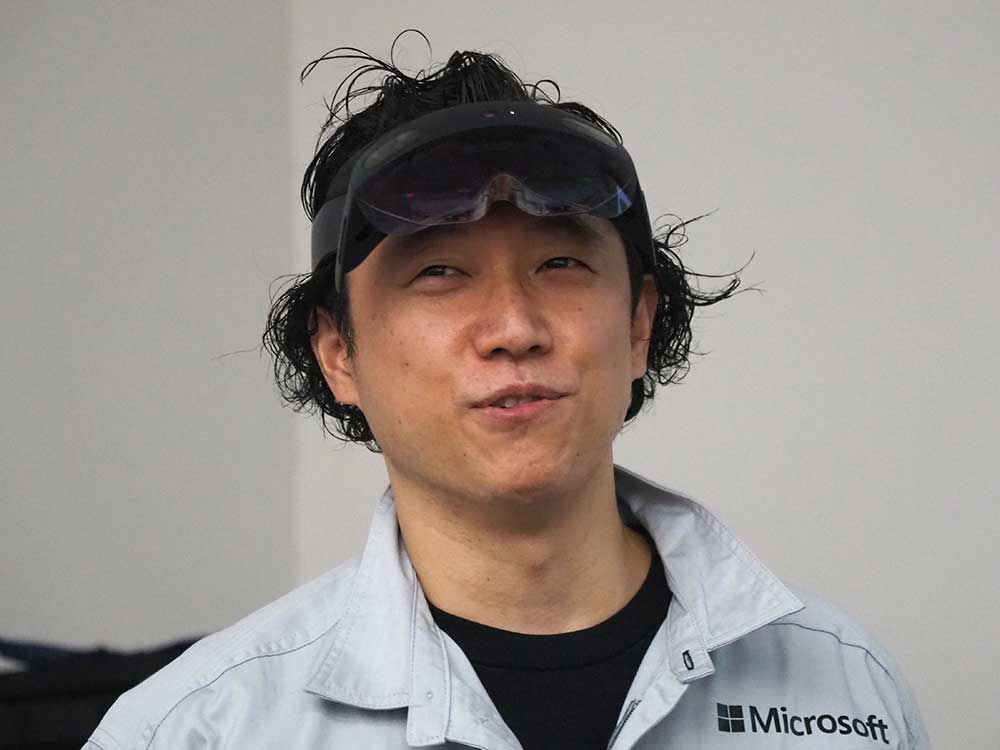

▲上田欣典氏。

初代『HoloLens』は、2017年1月に日本で発売が開始され約3年が経った。この会場では約9割が『HoloLens』を体験したことがあり、そのうち半分は所有もしているという人ばかりだったが、エンタープライズからエンターテイメントなど、様々な領域で活用されている。

2019年の2月に発表された最新バージョンの『HoloLens 2』も、11月より日本で出荷が開始された。そこで、こちらのセッションでは『HoloLens 2』とMRテクノロジーを一挙紹介するという主旨で行われた。ちなみにマイクロソフトのセッションというと、スライドや動画で紹介されるものが多いという印象だが、今回は日本マイクロソフト マイクロソフトテクイノロジーセンター テクノロジーアーキテクトの鈴木あつし氏がサポートしながら、限られた時間の中で5つのデモも実施された。

▲鈴木あつし氏。

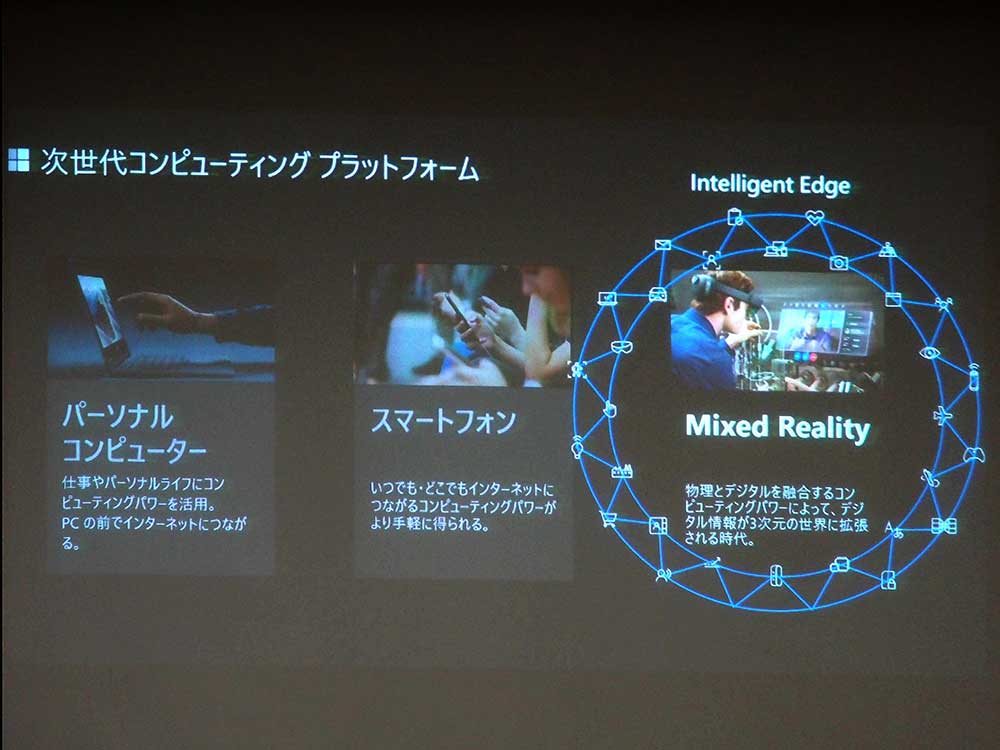

そもそもMixed Realityとは、物理世界とデジタル世界を融合してユーザーが物理世界にいながら物理とデジタル両方のオブジェクトとやりとりができる世界を実現する技術だ。1970年代にPCが出てきて生活が便利になった。ここ10年はスマートフォンが普及し、いつでもどこでもネットに繋がりコンピューターの恩恵が受けられるようになった。その次のプラットフォームになるのが、このMixed Realityである。

現在のスマートフォンとMixed Realityの間には、越えられない壁がある。それが、「2D画面の制約」であると上田氏はいう。これは逆にいうと、Mixed Realityでは3Dで物事が見られるようになるということだ。2Dという狭い世界から飛び出し、現実世界がキャンパスとなるのである。

しかし、Mixed Reality自体はスマートフォンに置き換わるというものではない。それはスマートフォンが出てきたからといってPCがなくなったわけではないことと同じで、用途やシーンに応じて使い分けがされてきたからだ。

『HoloLens』の特徴は、現実世界の中であたかもそこに存在するかのように3Dでデジタル情報が表示できるところである。デバイス自体にコンピューターが内蔵されており、PCやスマートフォンにケーブルやワイヤレスで接続するといったことも不要で、単体で利用できる。

さらにセンサーも搭載しており、リアルタイムに現実空間をスキャンして物理的なオブジェクトの認識もできる。そのため、台の上にバーチャルなものを置いたり壁に貼り付けたりといったことも可能となっている。

活用事例としては、遠隔支援やトレーニング、視覚化や共同作業、コンテキスト データ アクセスなど、現場の最前線にいるファーストラインワーカー向けのものが、今後も加速していくと考えられている。

ベルシステム24のコールセンター・バーチャライゼーションという事例では、MRを活用してコールセンターの時間や場所を越えた働き方を実現している。コールセンターには、製品の使い方などの質問がくる。そのため、実際の商品が置かれていることがあるのだが、どうしても場所を取りがちだ。それをデジタル化していつでもどこでも見られるようにすることで、たとえば自宅にいながら空いた時間でサポート業務が行えるようになるのである。

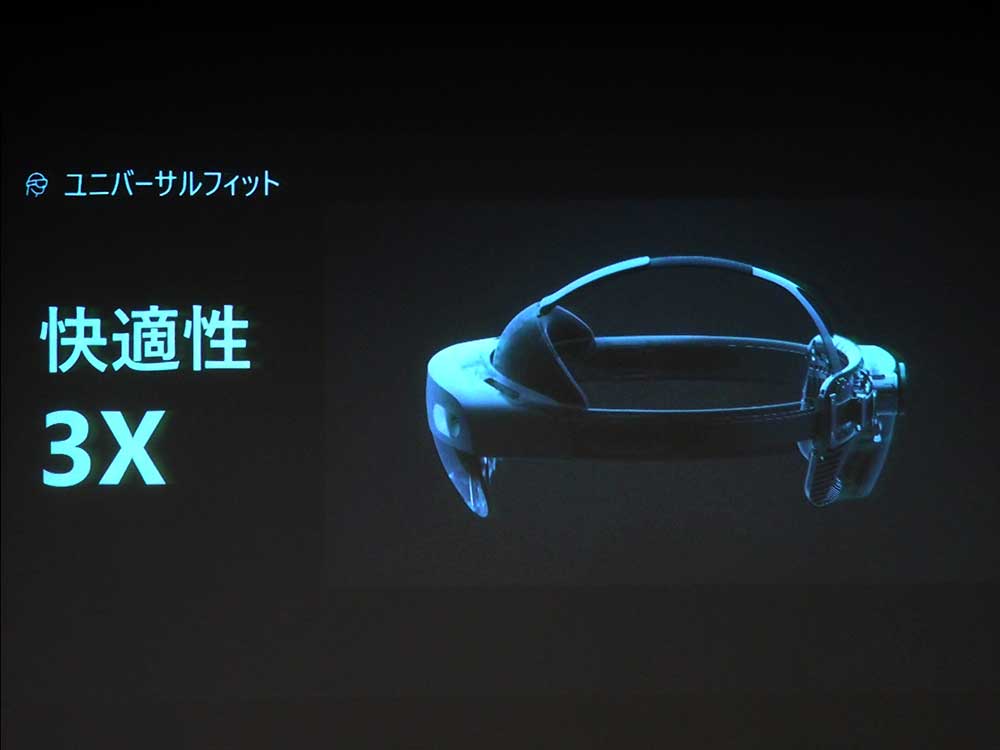

新たに発売された『HoloLens 2』で進化したポイントは、「快適性」だ。『HoloLens』では、主要なパーツが前面に集まっていたためずれ落ちてくるなどの問題があった。しかし、『HoloLens 2』では後ろにバッテリーを移動したことで、重量のバランスが取れ長時間装着しても不快にならない。

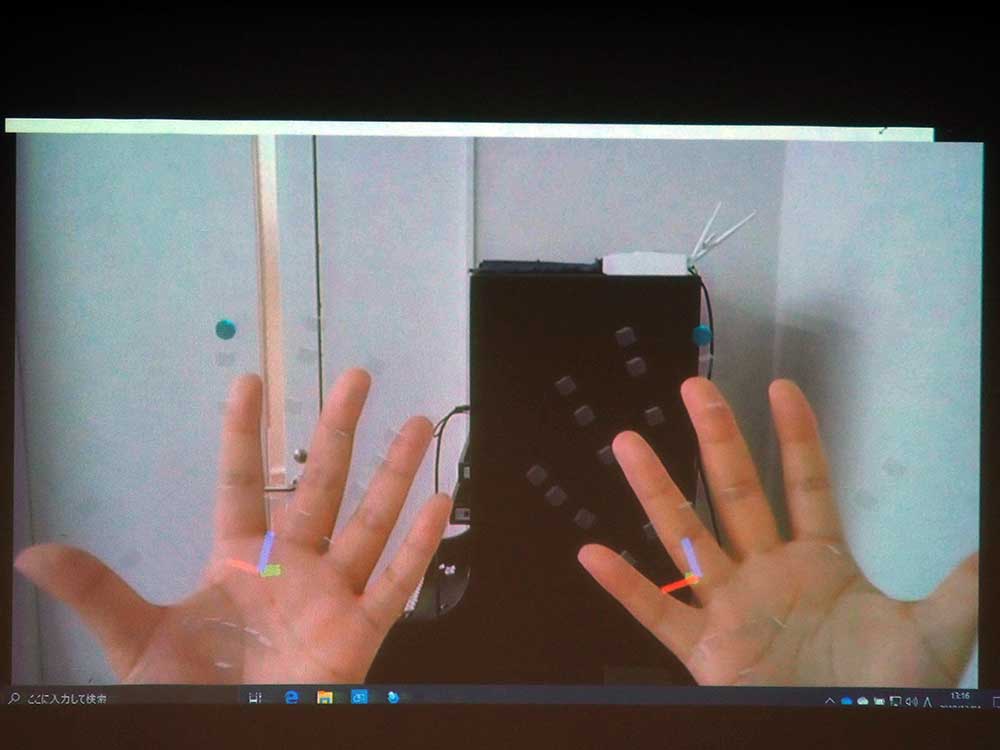

ふたつ目のポイントは、「視野角」だ。『HoloLens』と比較して、対角線上に視野角が2倍に広がっている。3つ目のポイントは「ハンドトラッキング」である。『HoloLens 2』では、両手10本指の認識ができるようになった。これにより、エアタップという不自然な動作が不要になっている。

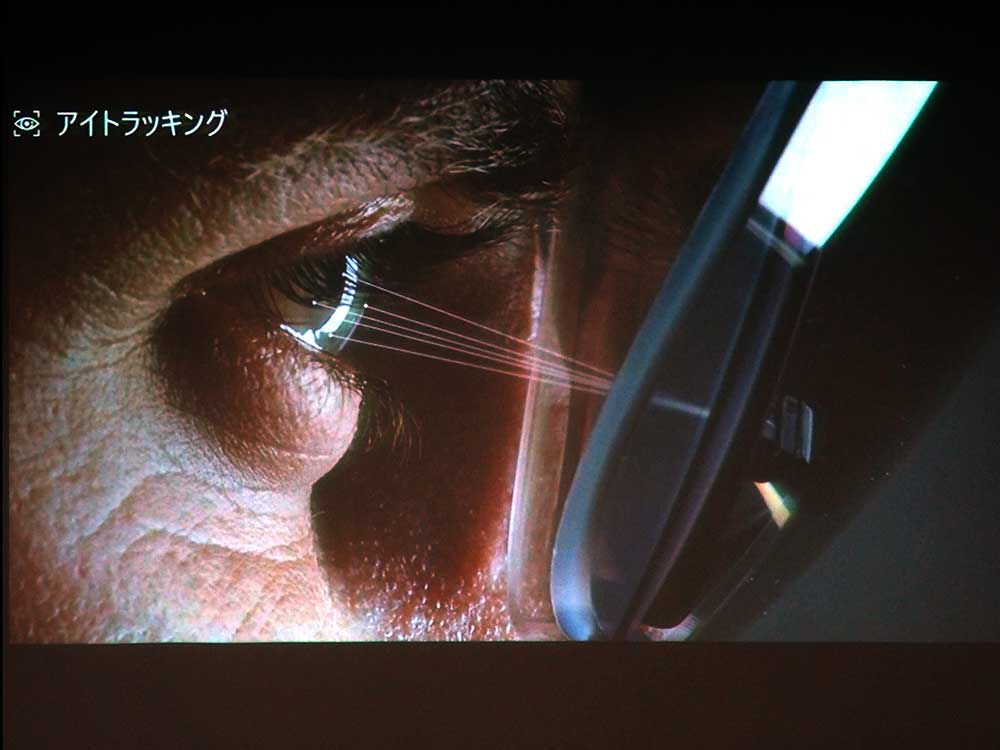

4つ目のポイントは「アイトラッキング」だ。内向きのカメラを搭載したことで、眼球の動きが追えるようになった。『HoloLens』ではヘッドトラッキングしかなかったため、頭を動かす必要があったが、「アイトラッキング」のおかげで眼の動きだけでもある程度制御が可能になった。

さらに、虹彩認証で『HoloLens 2』に搭載されたウィンドウズにログインが可能になった。デバイスがひとり1台ある場合は関係ないかもしれないが、複数人で利用するときに、装着してすぐに認証が行われログインできるようになっている。

『HoloLens 2』を使った実機デモ

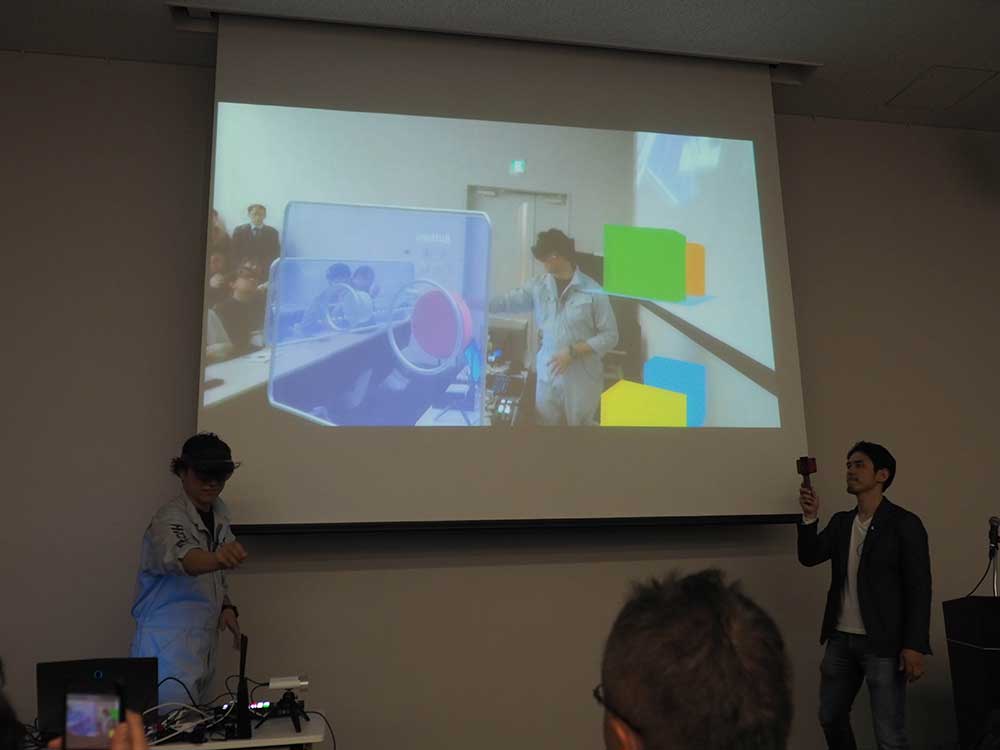

ここから鈴木あつし氏によるデモがスタート。『HoloLens 2』の開発キットには、サンプルアプリケーションが収録されている。今回のデモでは、そちらがインストールされており、様々な体験が行えるようになっている。

鈴木氏が出した手の位置に、点が表示されており、真ん中にX軸Y軸Z軸の座標が見られるようになっている。これは『HoloLens 2』が鈴木氏の手の座標を認識しているという証拠だ。

人差し指の先端には、水色の球体が表示されている。ここが「フィンガーチップ」と呼ばれるもので、ボタンを押すなど『HoloLens 2』の操作を受け付けている箇所になる。「フィンガーチップ」自体はすべての指に付けることも可能だが、指の感覚が狭いため誤操作しやすくなってしまう。そのため、人差し指に付けることが推奨されている。

ちなみに、デモの映像では指と点の位置がずれて見えるが、これはあくまでも表示上の問題だ。カメラの位置とセンサーの位置がずれているためで、表示上はずれて見える。しかし、実際に『HoloLens 2』をかけているときはぴったりと合っているように見える。

たとえばバーチャル空間上に置いたピアノも、指がしっかりと認識されているので両方の指で弾くことが可能だ。近くにあるオブジェクトは、実際に触るように操作が行えるが、遠くに置いてある地球儀などオブジェクトの場合は両手の指からレーザーのようなものが伸びて表示され、VRのコントローラーのように掴んで動かすこともできる。

3次元の操作だけではなく、表をタブレットの操作のようにスクロールしたり拡大・縮小したりすることも可能だ。指先が操作ポイントになっており、キーボードを表示して入力することもできる。

進化したのは『HoloLens 2』のデバイスだけではない。マイクロソフトでは、様々なソリューションも提供している。前モデルの『HoloLens』が発売されたとき、「買ったはいいけど、使えるアプリがない」という声やアプリを開発するのに時間やお金が掛かるという意見がユーザーから上がっていた。

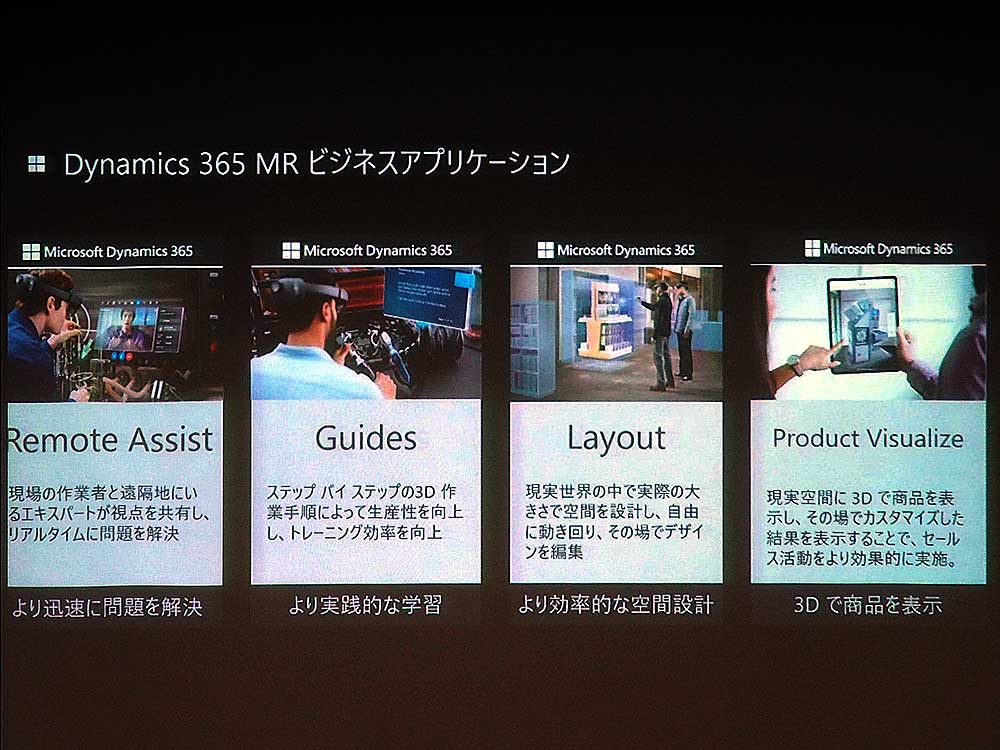

そこで、すぐに業務で使えるアプリを同社では提供している。『Dynamics 365 Mixed Reality』というビジネスアプリケーションでは、『Remote Assist』『Guides』『Layout』『Product Visualize』という4つのビジネスアプリを提供している。

『Remote Assist』は遠隔支援で使うアプリだ。『Microsoft Teams』と『HoloLens』を使ってビデオ通話することができる。『HoloLens』から見た視点の映像をPCに送ることもできるので、具体的に作業を行っている人の手元を見ながら遠隔地から指示が行えるのである。

『Guides』はトレーニングのシナリオに使われるようなアプリだ。ステップ・バイ・ステップで、作業手順を3Dで表示することができる。『Layout』は名前の通り、現実世界にものの配置をシミュレーションできるものだ。

『Product Visualize』はタブレット用のアプリである。3Dの商品カタログのようなもので、営業先にタブレットやスマートフォンで3D表示することができる。

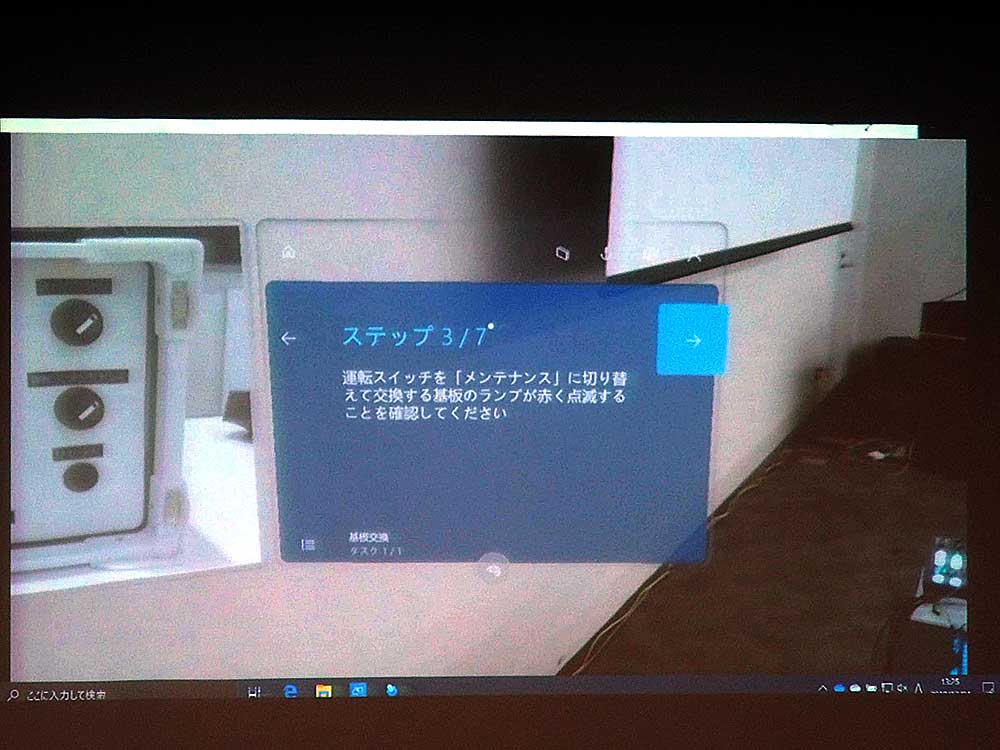

ここで、機器の基板を交換するという作業手順を『Guides』を使ってデモが行われた。作業では、実機に重ねる形でウインドウが表示され、ひとつひとつのステップをゲームのチュートリアルのように表示してくれる。

たとえばロックを外す場所や回す方向、引っ張り出す方向などもわかりやすく表示することができる。また、文章だけでは分かりにくいところは、動画がある場合はそちらを参照しながら確認も行うことが可能だ。

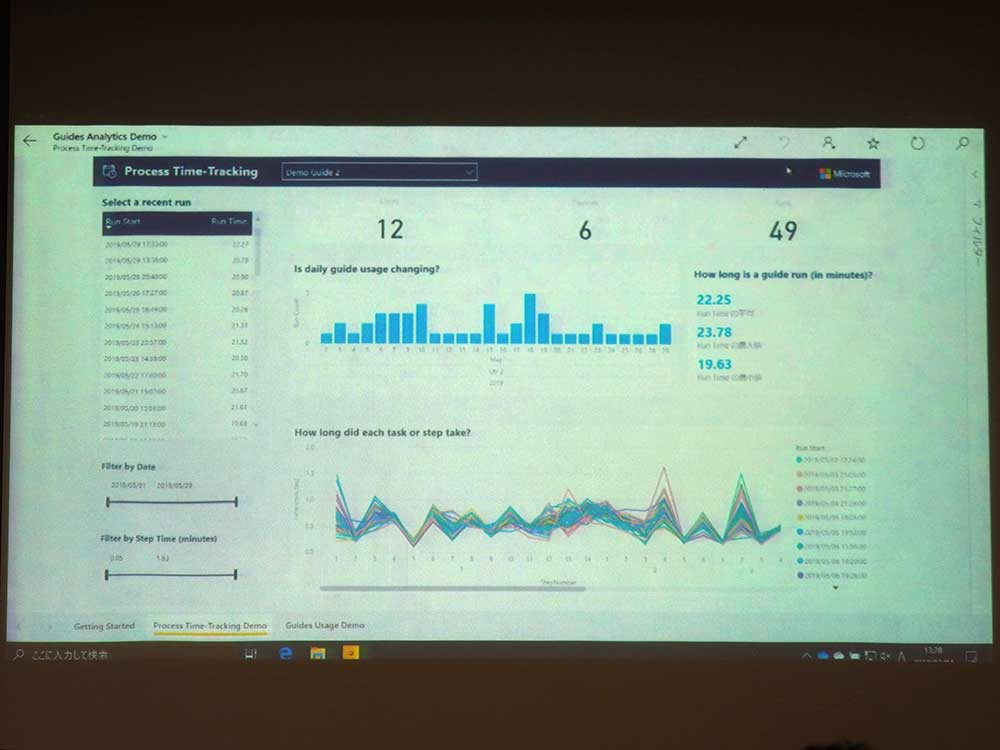

『Guides』では、『HoloLens』を使って行った作業がデータとして記録される。たとえば、ひとつひとつのステップに倒して、作業の時間が記録されている。これにより、全体の中で自分が苦手な作業なども数値化して把握することができる。

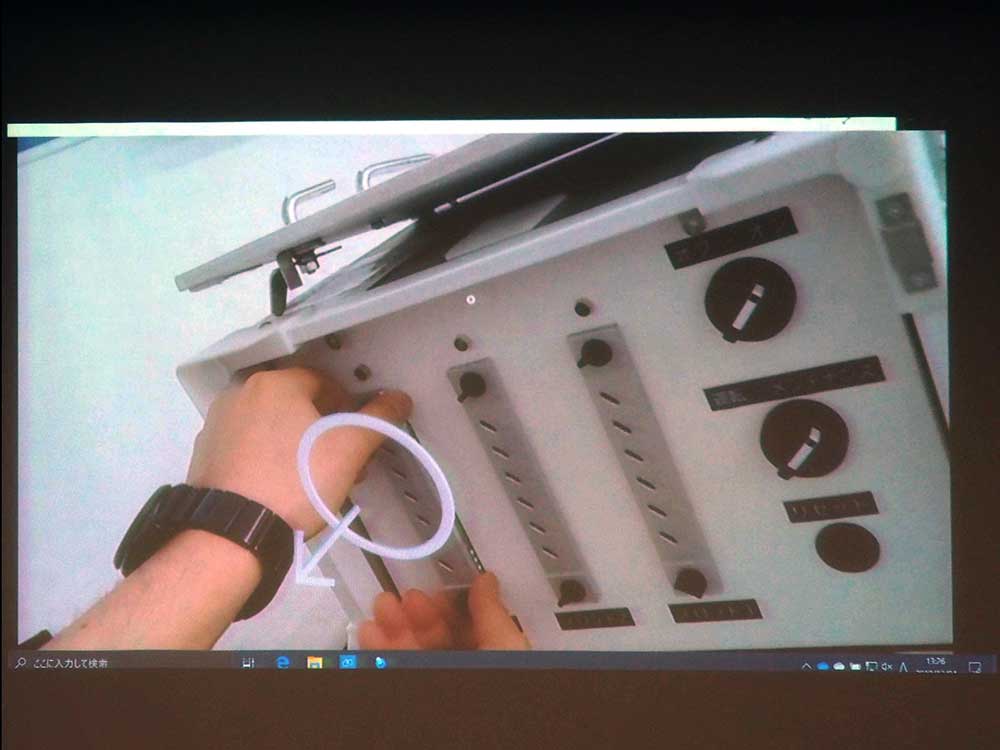

続いて『Remote Assist』を使ったデモを実施。こちらは遠隔から作業者に向けて支援が行えるものだが、たとえば不慣れな作業では『Guides』などのアプリを使っても、不具合の解消方法がわからないことがある。それについて、遠隔地から支援してもらうときに活用することができる。たとえば作業手順をPDFで送り、状況に応じた作業手順を教える事ということも可能だ。

マイクロソフトでは、クラウドのAzureに対応したサービスも提供している。ひとつは『Azure Spatial Anchors』で、もうひとつは『Azure Remote Rendering』だ。『Azure Spatial Anchors』は、空間の位置情報をクラウド上で共有するものである。これは『HoloLens』だけではなく、スマートフォンやタブレットなどと共有することもできる。

『Azure Remote Rendering』は、CADデータなど非常に重たいデータを、クラウドに上にあるGPUリソースを使ってレンダリングし、それをストリーミングで見られるようにするというものである。

▲『Azure Spatial Anchors』で、iPhoneと『HoloLens』でオブジェクトの位置を共有することができる。

2020年3月に、Azure Kinect DKが日本でも発売開始になるが、そちらのデモも行われた。こちらもMR技術のひとつで、『HoloLens 2』と同じ深度センサーが採用されている。

▲鈴木氏が手に持っているのがAzure Kinect DKだ。

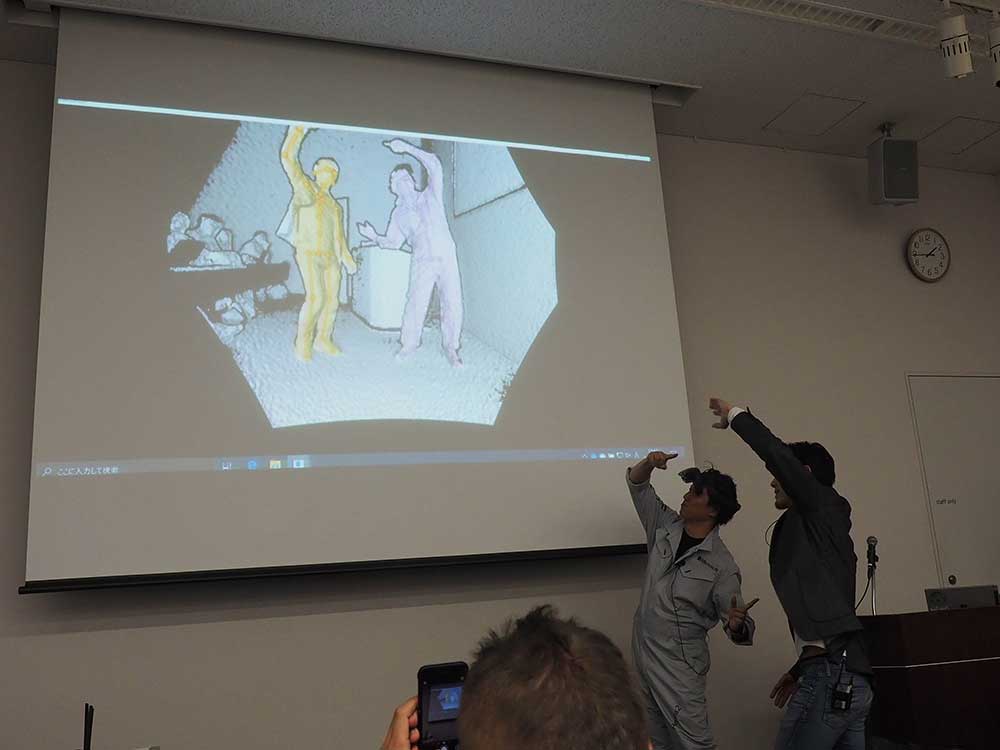

Azure Kinect DKでは、ボディトラッキングで24箇所の関節の情報を取得することができる。そのため、Azure Kinect DKでの前にいる人の身体の動きを取ることが可能だ。Azure Kinect DKは赤外線の波長を変えることで、3台までシンクロさせることができる。これにより、360度空間を認識させることも可能となっている。

▲Azure Kinect DKなら、ふたりで『ドラゴンボール』のフュージョンを再現することもできる。

従来までは、ボディトラッキングができる人数に制限があった。しかしAzure Kinect DKではマシン性能に依存するが、何人でも取得することができるようになった。

Azure Kinect DKの「DK」はDevelopment Kitの略で、従来のようにXBOXのコントローラーではなく、製品やソリューションに組み込んで使えるようになっている。開発キットもオープンソースとして公開されており、アイデア次第で様々な活用方法が考えられる。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。