07.10

【World MR News】『RE:BEL ROBOTICA レベルロボチカ』×HoloLens2がコラボ! MR で変わるライフスタイルとワークスタイル――「de:code2020」をレポートその③

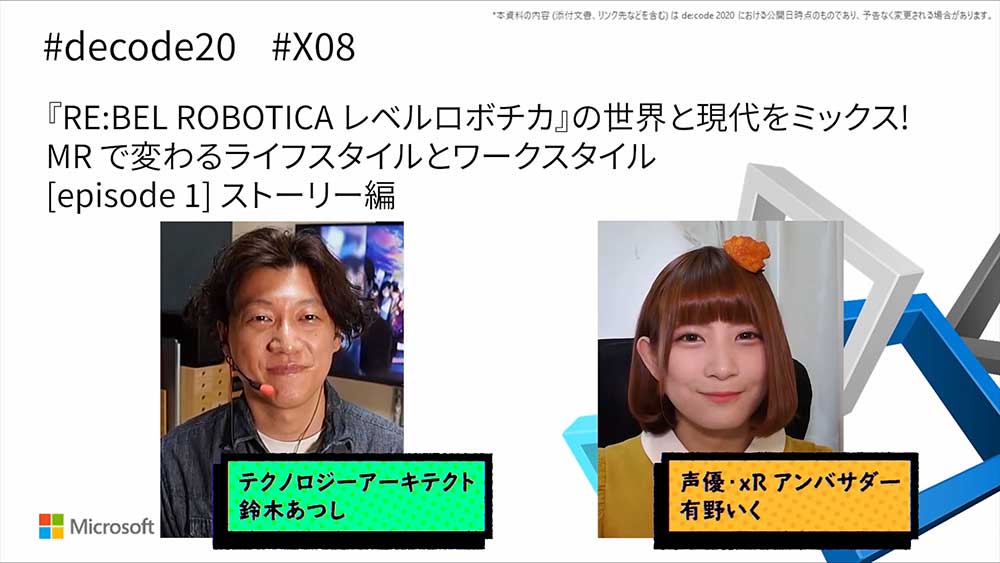

6月17日から6月30日までの2週間、オンライン上で開催されたマイクロソフトのテクニカルカンファレンス「de:code2020」。本稿では、『RE:BEL ROBOTICA レベルロボチカ』とHoloLens2のコラボレーションセッション「『RE:BEL ROBOTICA レベルロボチカ』の世界と現代をミックス! MR で変わるライフスタイルとワークスタイル」から、ストーリー編と技術解説編をピックアップしてお届けする。

近未来の東京が舞台の『RE:BEL ROBOTICA レベルロボチカ』

[episode 1] ストーリー編で登壇したのは、日本マイクロソフトのテクノロジーアーキテクト 鈴木あつし氏と声優・xRアンバサダーの有野いくさん、チーム〈レベルロボチカ〉のリリィだ。

このセッションでコラボすることになった『RE:BEL ROBOTICA レベルロボチカ』は、VTuberなどのキャラクターデザインやファッションデザイン、ライブアートディレクションなどを手がけているイラストレーターMika Pikazoさんが原案の、XRの未来のテクノロジーの可能性を描いた作品だ。

2017年より個人活動でスタートし、2019年12月にSF作家・吉上亮さんが参加して正式にプロジェクト化が発表された。今回のイベントでは、コンテンツサポーターとして参加している。

『RE:BEL ROBOTICA レベルロボチカ』の舞台は、2050年の未来の東京だ。この世界では、VR、AR、MR、SRといった仮想空間や空間拡張技術の延長で、フィジカルとバーチャルが融合一体化した超越現実のMeta Reality(通称MR)が、インフラとして普及している。

バーチャルを視覚だけではなく、触覚、聴覚、味覚、嗅覚の五感で認識でき、街中にデジタルデータがあふれている。この作品では、そんな世界で暮らす思春期の少年少女たちの姿が描かれている。

主人公のタイキは、先天性のMRバグを抱えてくれる高校1年生の男の子だ。彼が偶然出会ったのは、MRを自在に操り都市のバグを秘密裏に処理するスーパーAIエージェント・ロボチカのひとりであるリリィだった。

リリィはバグ持ちのタイキと繋がることで、本来の力を失ってしまう。そこで、元に戻る方法を探し始める。タイキはリリィのバグ処理の仕事に巻き込まれるようになるが、そのバグ処理はMRの暴走で生じるモンスター退治だった。

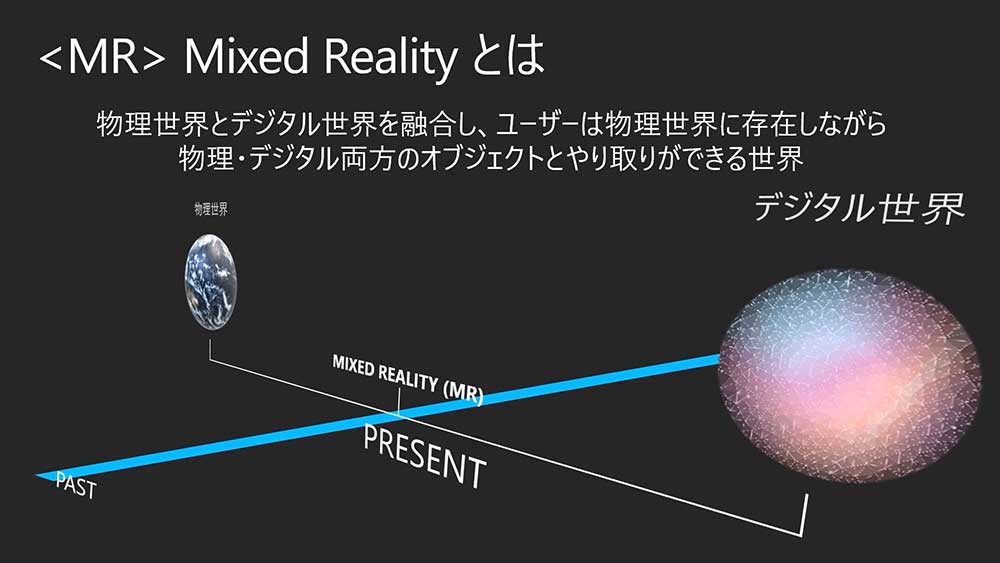

Mixed Realityは次世代のコンピューティングプラットフォームだ

現実世界のMR(Mixed Reality)は、未来の話しではなく現在の技術で活用できるものだ。仕事や勉強など、生活の様々な場面でPCやスマートデバイスを活用している人は多い。それらのインターフェイスは、キーボードやマウス、タッチペンへと変わっていったが、変わっていない部分もある。その中のひとつが、ディスプレイという平面を通してデジタルの世界を扱っていることだ。

だが、MRデバイスを使うことで自分たちがいる世界の中に、あたかもそこに存在しているかのように、デジタル世界の映像やデータを配置して操作することができる。では、近い将来にPCやスマートフォンが無くなるかというと、それは考えにくい。MRデバイスは、PCやスマートフォンなどと相互に活用していくことになる。

MRは、VRやARとも密接に関係しているテクノロジーだ。VRのような没入感と、ARのような現実世界の拡張の、両方の特徴を備えている。MRでは、物理世界にある様々なものはデータ化され、デジタル世界に記録することができる。

空間の形や空間内の移動、手の動き、目線、声、カメラで撮影した画像、そしてその画像をAIで解析すれば目の前にあるものの種類や個数、正常な状態か異常な状態かといったことも記録が可能になる。

デジタル世界に蓄積されたデータは、物理世界であたかもそこに存在するかのように見て操作することができる。また、物理世界と同じように時間の概念を持つことができる。物理世界と異なる点は、この時間はデータさえあれば過去に遡ったり未来に進んだりできるというところである。

現在発生しているデータをリアルタイムに表示することもでき、別の場所にいる人とリアルタイムにコラボレーションすることもできる。また将来のために、職人やエキスパートの動きをデータ化して、記録しておくといったことも可能だ。MRを理解する上では、空間と時間の概念は重要なポイントとなるのである。

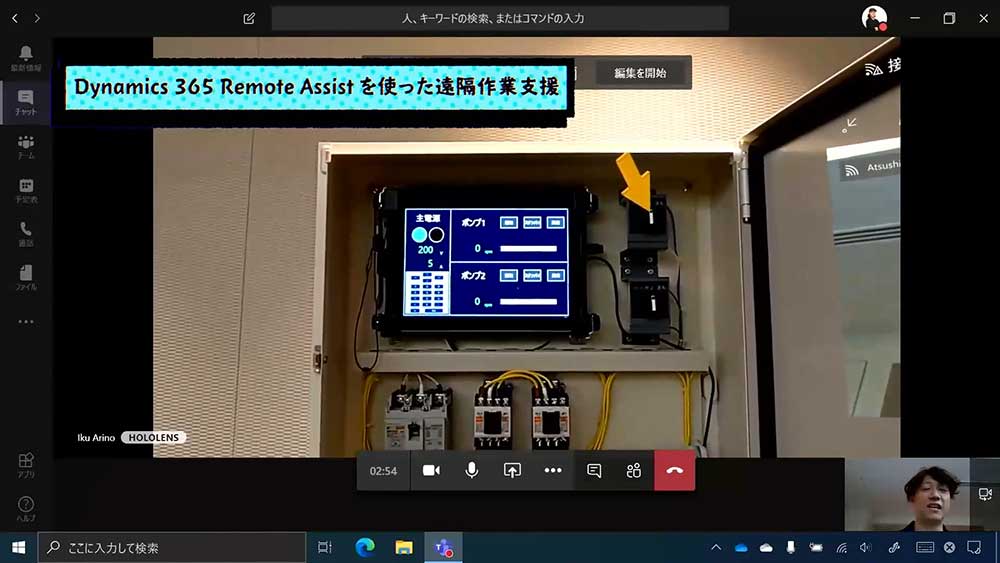

デモでは、有野さんがリリィに古いカメラを見せて相談するといったシーンが紹介された。ここで使われていたのが、『Dynamics 365 Remote Assist』を使ったリモート撮影だ。

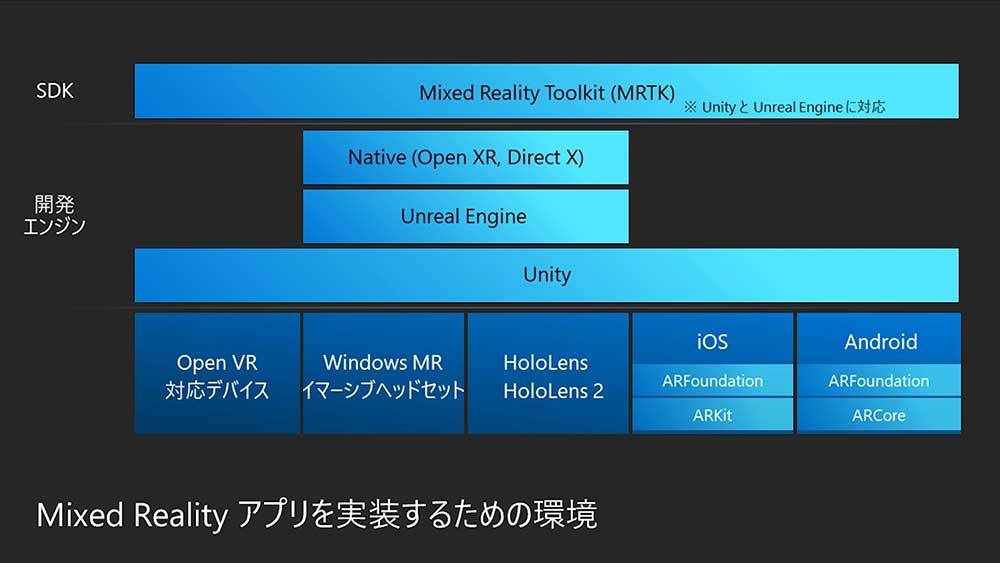

MRアプリを実装するための環境

後編の [episode 2] 技術解説編では、有野さんとリリィのデモ作成で使われた技術についての紹介が行われた。MRアプリを実装するために、ネイティブに対応したデバイスはHoloLens1とHoloLens2がある。

スマートデバイスでは、ARKit、ARCore、ARFoundationの機能を使用して、MRアプリを動かすことができる。VRのヘッドセットでは、Windows MRイマーシブヘッドセットとOpen VRプラットフォームに対応したデバイスで動かすことができる。

開発エンジンは、UnityやUnreal Engineといったゲーム開発用のエンジンが使用可能だ。ネイティブのエンジンとしては、OpenXRやDirect Xに対応している。これから開発を始める人には、マイクロソフトが用意したサンプルやチュートリアルが豊富なUnityがオススメだ。

SDKには、オープンソースのMixed Reality Toolkit(通称MRTK)がGitHubで公開されている。こちらは、HoloLens1とHoloLens2、Windows MRイマーシブヘッドセット、iOS、Androidに対応している。

MRは、クラウド連携することで活用の幅が広がる。クラウドと連携するアプリケーションとして、マイクロソフトから提供されているものと、アプリケーション開発を行うためのサービスとして提供されているものがある。

『Dynamics 365 Remote Assist』は、HoloLensとiOS、Androidで動かすことができる。こちらは、Teamsのビデオ会議機能を利用して遠隔地からの作業指示や、トラブルシューティングを行うことができる。

ただのビデオ会議ではなく、資料の共有、空間の中にアノテーションと呼ばれる矢印や手書きの書き込みを残すこともできる。そのため、離れた場所にいても一緒に挙動作業が行えるのが特徴だ。

▲デモ撮影の一部は、愛知県のRobot@homeで行われたが、鈴木氏はいけなかったため遠隔で作業が行われた。

『Dynamics 365 Guides』は、HoloLensで動くアプリケーションだ。実際の機械に映像を重ねたり、CGで作成した機械を表示したりすることで、作業指示やトレーニングに活用することができるというものである。作業の所要時間が自動的に記録され、レポートして参照することができる。

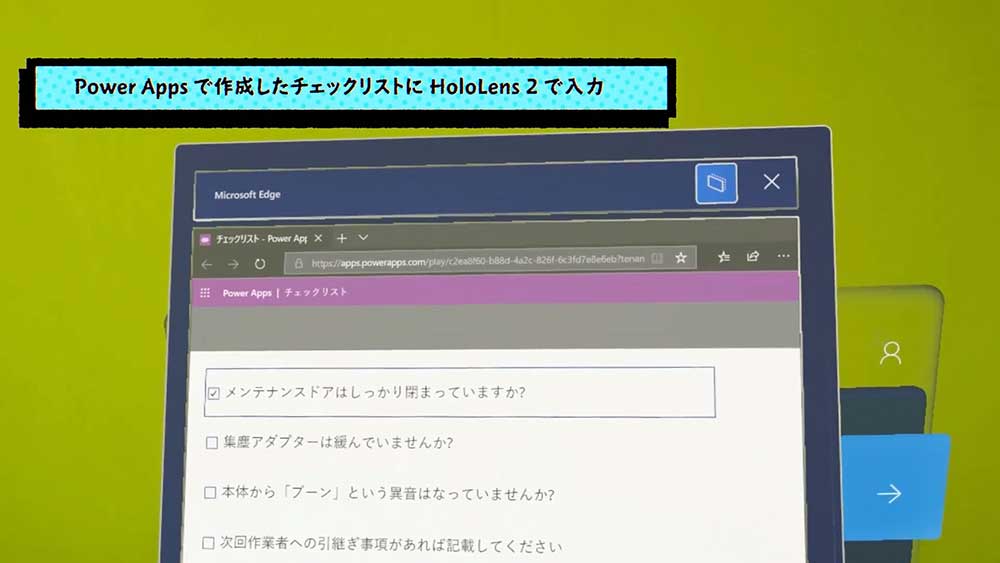

Power Appsで作成したアプリを表示して、入力することもできる。HoloLens2では、ハンズフリーでジェスチャーと視線と声で入力が可能だ。そのため、作業のチェックリストや報告書の作成にも向いている。

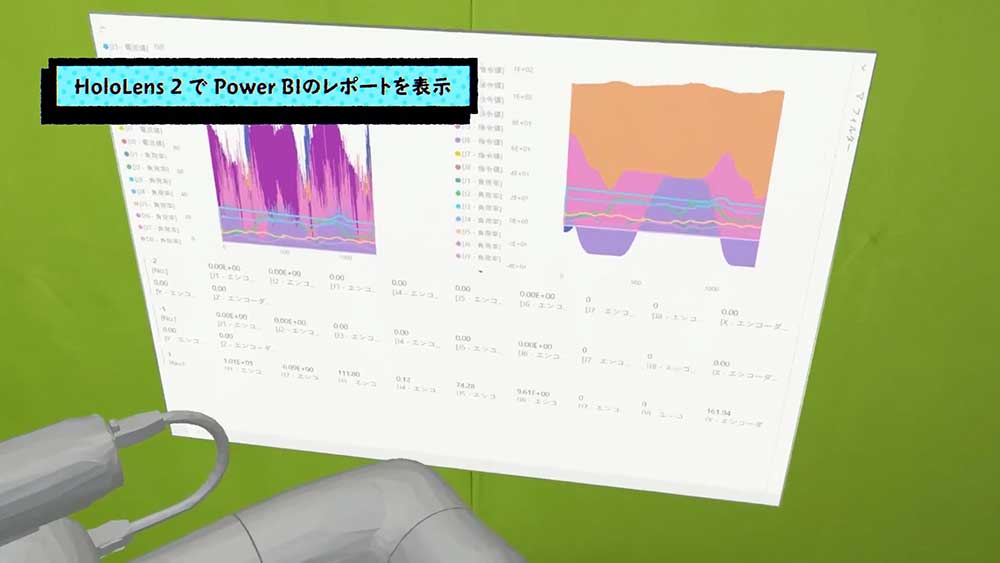

Power BIでレポートを表示して、データを確認することも可能だ。実機に重ねて表示することで、リアルタイムで確認することもできる。また、遠隔地にある機械や工場のデータを、CGに合わせて表示することで、過去から現在までのデータを可視化することもできる。

HoloLensでは、Power AppsやPower BIはエッジを使用して表示を行う。エッジのウインドウは、空間に固定したり動きに追従させたりすることもできる。これらは、いつでも自由に切り替えが可能だ。

そしてMixed Realotyパートナーからは、特徴的なアプリが次々とリリースされている。MRカスタムアプリの開発には、こうしたMixed Realotyパートナーに相談するのが最適だ。

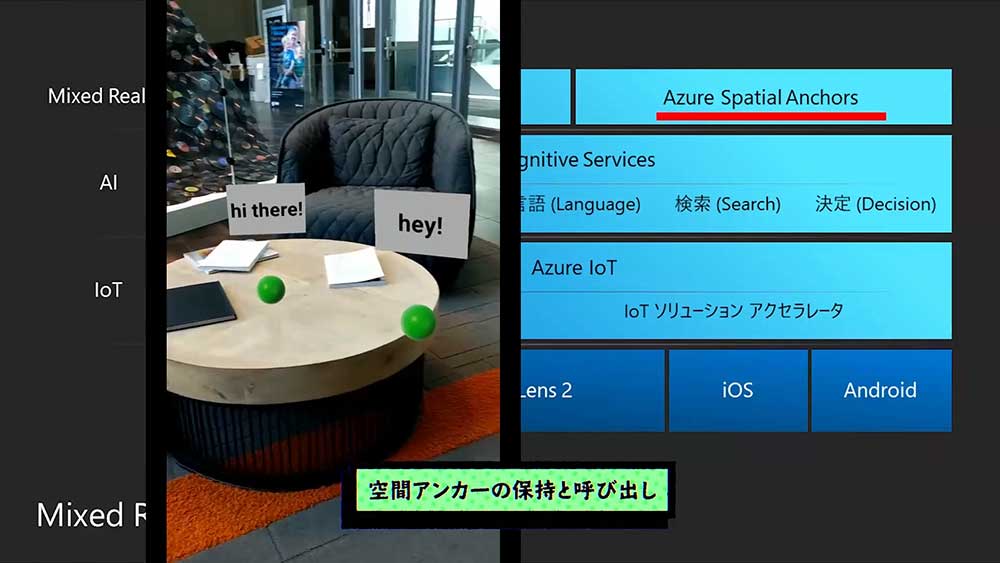

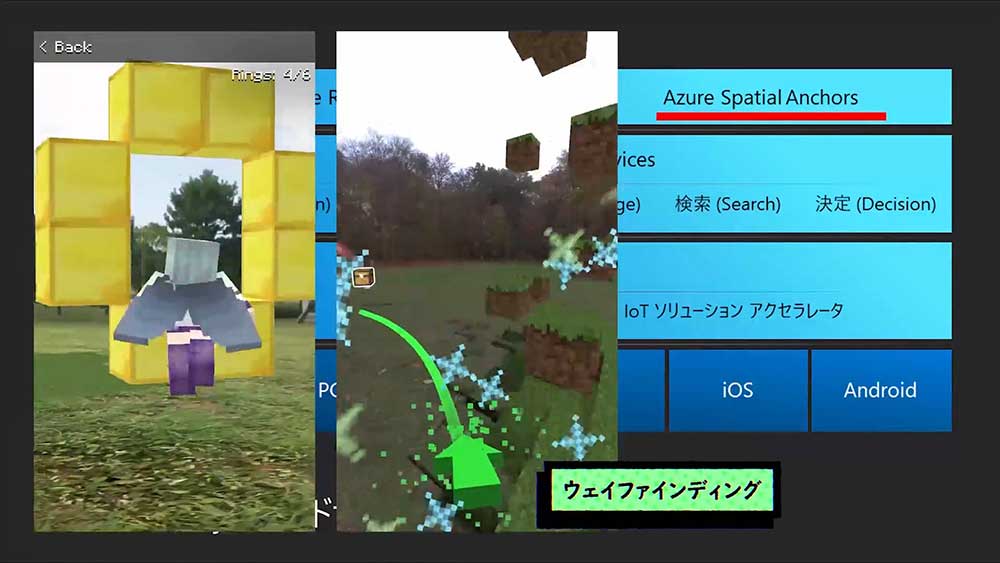

MRアプリ開発を行うために、マイクロソフトが提供しているMixed Realityクラウドサービスは2種類ある。ひとつは、「Azure Spatial Anchors」だ。こちらは、物理世界とデジタル世界の空間座標の基準点となる、アンカーの情報をクラウド側に保存することで永続的にアンカー情報が保持できるというものだ。

「Azure Spatial Anchors」は、HoloLens以外にもiOSやAndoroidにも対応している。たとえば、観光地で物理的な看板を立てなくとも見える看板を作ったり、ゲームやエンターテイメントなどで幅広く活用したりといった使い方ができる。

「Azure Spatial Anchors」を利用して、HoloLens2で見ている映像を別のデバイスと共有し、第3者視点で見る「Spector View」という仕組みを構築することもできる。これにより、撮影に使用したり作業の様子を他の視点から記録したりといったことも可能だ。

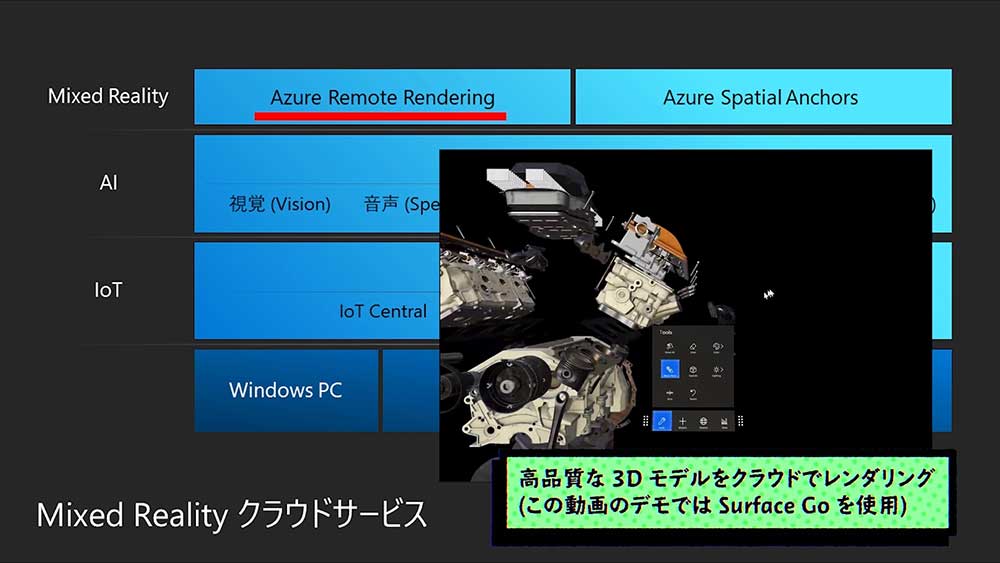

「Azure Remote Rendering」は、GPUに不可が掛かるレンダリング処理をAzure上にある仮想マシンで行いデバイスにストリーミングするサービスだ。特にHoloLensやスマートデバイスでは、本体のサイズからデスクトップPCのように高性能なGPUを搭載することができない。そのため、これまでは高品質な3Dモデルを表示する場合は弟子メーションという処理を行い、ポリゴン数を減らす必要があった。

しかし「Azure Remote Rendering」ではコンテンツをクラウド上でレンダリングして、リアルタイムにデバイスにストリーミングするため、高品質の対話型3Dモデルを表示することができる。

Azureには、連携することで高い効果が得られるものがある。「Cognitive Service」は、様々な学習済のAIが利用できるサービスだ。汎用的な学習済モデルをすぐに使えるほか、自分が持っているデータを使ってカスタムで学習させるほか、コンテナーを使用してエッジにデプロイすることも可能だ。

▲「Cognitive Service」を活用して、カメラの型番を読み取らせるといったこともできる。

「IoT Central」は、IoTの実装に必要なデバイス管理、データの可視化、アラートの通知などを豊富なテンプレートを使って構築することができる。

「IoTソリューション アクセラレータ」は、リモート監視、コネクテッド ファクトリ、予測メンテナンス、デバイス シミュレーションの4種類のシナリオに合わせて、必要なAzureサービスとソースコードを素早くデプロイすることができるIoTソリューションだ。

HoloLens2は、実際の機械にデータを重ねて表示することができるので、「IoT Central」や「IoTソリューション アクセラレータ」と連携して、メンテナンスが必要な箇所を表示したり予測した未来を可視化したりといった使い方ができる。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。