07.10

【World MR News】クラウドレンダリングを活用することで通常スペックのPCでも3Dがヌルヌル動く『Azure Remote Rendering』――「de:code2020」をレポートその②

6月17日から6月30日までの2週間、オンライン上で開催されたマイクロソフトのテクニカルカンファレンス「de:code2020」。本稿では、数あるセッションの中から『Azure Remote Rendering』と『AIりんな』に関するものをピックアップしてレポートする。

普通のマシンで高品質な3Dデータがヌルヌル動く『Azure Remote Rendering』

日本マイクロソフトの鈴木あつし氏と声優・xRアンバサダーの有野いくさんという組み合わせで行われたのが、2020年4月よりパブリックプレビューが開始された『Azure Remote Rendering』のセッション「ついに来た!! 普通のマシンで高品質な3Dデータがヌルヌル動く Azure Remote Rendering」だ。

従来までは、複雑な3Dモデルをレンダリングする場合にハイエンドなGPUを搭載した高性能なワークステーションが必要だった。当然のことながら、コストも掛かる上に気軽に持ち運べるものでもない。

また、通常スペックのPCで3Dモデルを扱うには、デシメーションと呼ばれる圧縮を行い、ポリゴンを削減する必要があった。だが、この方法では3Dモデルの品質低下につながり、視覚的な忠実性を求められるケースでは許容できない場合もあった。

だが、この『Azure Remote Rendering』を使うことで、高品質でインタラクティブな3Dモデルをクラウド側でレンダリングし、HoloLens2やWindows PCなどのデバイスにリアルタイムでストリーミングが行える。これにより、高品質な3Dモデルが扱えるようになるのだ。

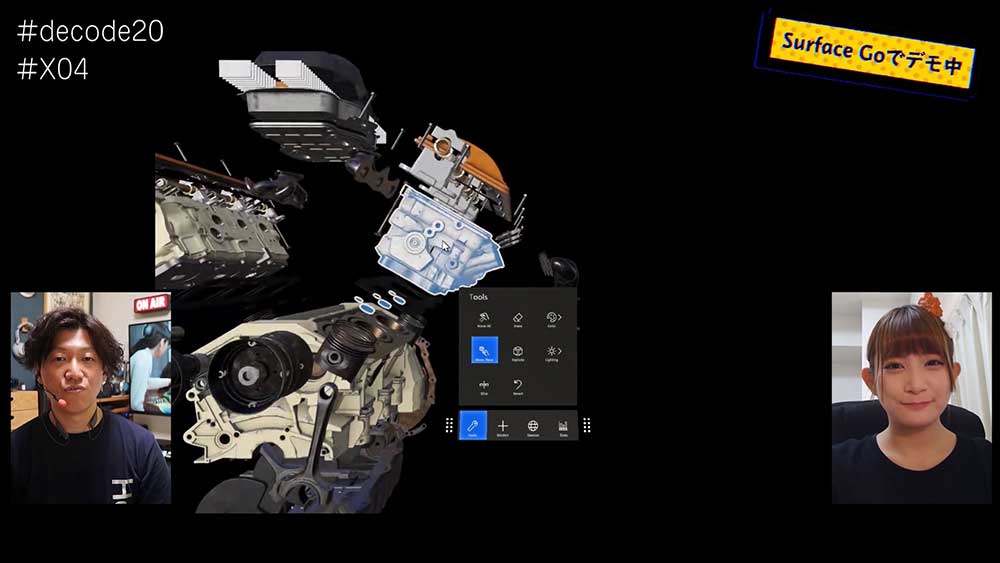

デモでは、有野いくさんが私用で使っている『Surface Go』を使って行われた。表示されていたのは高精細な3Dで作られたエンジンで、各パーツも分解できるというかなり細かなものであった。それでもほとんどストレスなく使うことができ、あらためて『Azure Remote Rendering』の実力がわかるものとなっていた。

『Azure Remote Rendering』の特徴のひとつに、インタラクティブな3Dモデルが扱えるというところがある。これはただ動かせるというだけではなく、表示しているオブジェクトを加工したり変更したりといったこともできるという意味だ。

『Azure Remote Rendering』では、最大8つの断面を同時に可視化することができる。マウスでドラッグすることで、3Dモデルを簡単に切断することができるのである。

また、『Azure Remote Rendering』では3つの光源が利用できる。「ポイントライト」は、単一の点または小さい球体やチューブから発光されるものだ。「スポットライト」は、円錐形に発光する。「指向性ライト」は、自然界のもののように無限に離れた場所にある光源をシミュレートしている。

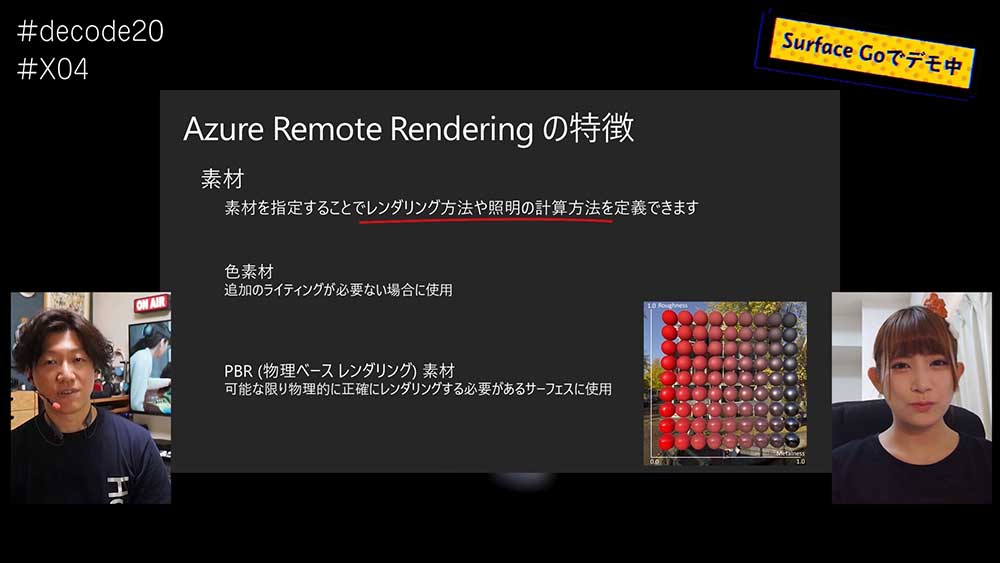

こうした光源は、照明によってイメージが変わるものなどに適用することで、より効果がますのだ。また素材を指定することでも、レンダリング方法や照明の計算方法を定義することができる。

たとえば金属のような光沢のあるものから、プラスチックのようなものまで様々な素材を指定することができるのだ。これにより、反射や写り込みを再現することも可能だ。

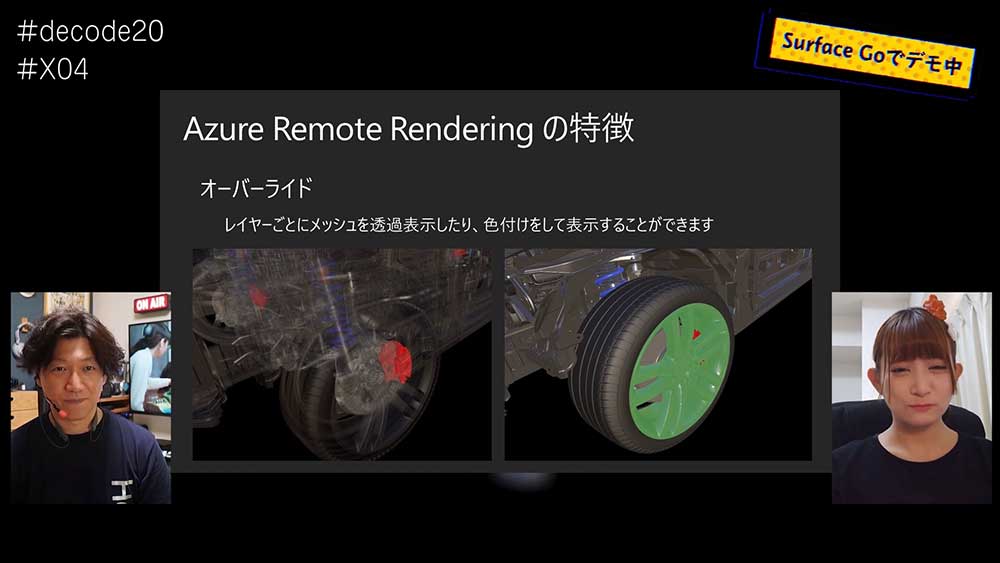

『Azure Remote Rendering』のもうひとつの特徴が、「オーバーライド」だ。こちらは、レイヤーごとにメッシュを透過したり色を付けたりすることで、内部構造を表示したり強調表示したりできるというものである。

もっと強調したい場合は、「アウトライン レンダリング」を追加することで、部品の外側に色を付けることができる。

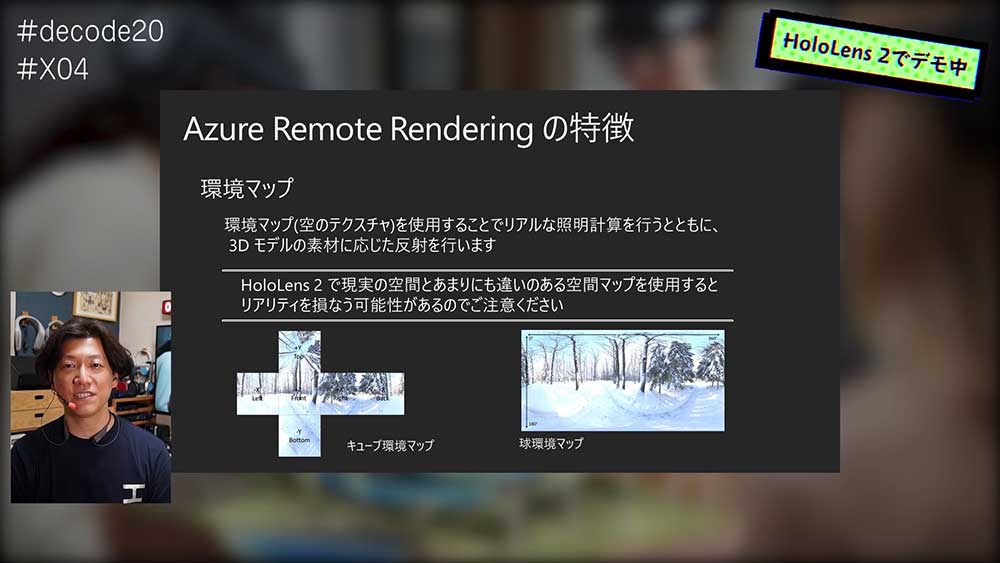

環境マップはあらかじめ用意されているもの以外にも、独自のものを用意して読み込ませることもできる。光源だけではなくテクスチャーも読み込んで、空の反射を再現することも可能だ。ちなみにHoloLens2で使用する場合は、現実世界が見えているため見ている世界に近いテクスチャーを用意した方が、リアリティが増す。

たとえば、光源や環境マップを上手く使った環境マップを用意することで、現実空間の照明の位置に合わせておいて、反射などもシミュレーションすることができるのである。

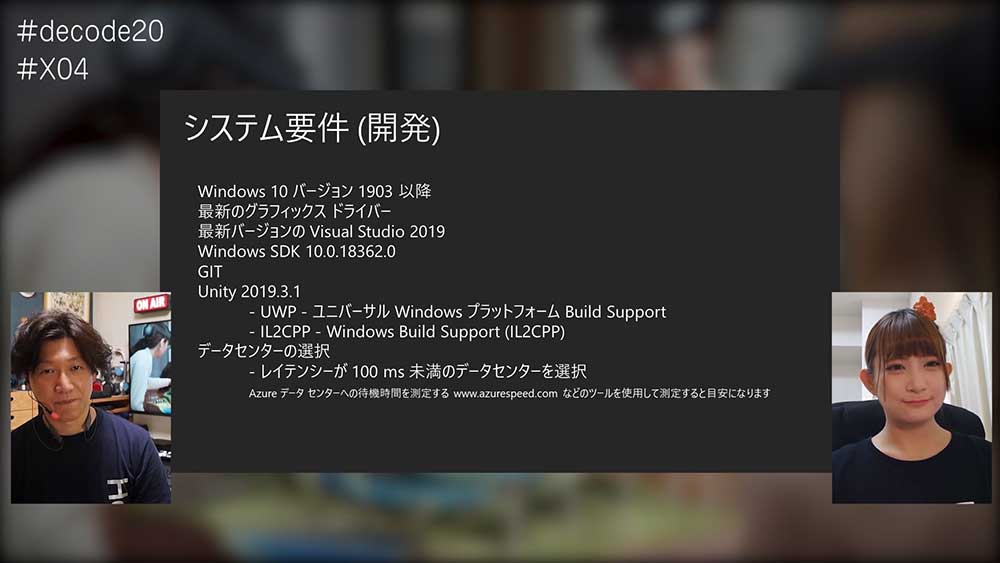

『Azure Remote Rendering』の開発を行うときに注意する点は、データセンターの選択だ。データセンターへのレイテンシーは、そのままアプリを動かすときの動作の遅れに繋がるからである。そのため、アプリを使用する場所に近いデータセンターを選択することがベストだ。

ただし、現状はパブリックプレビュー中であるため、選択できるデータセンターは限られている。そのため選べるモノの中から、できるだけレイテンシーが小さいものを選ぶようにするといいだろう。

アプリを動かす側も、鍵となるのはネットワークだ。目安は、50Mbps以上のダウンストリームと10Mbps以上のアップストリームが目安となる。

AIりんなの成長記録 2015~2020

マイクロソフト ディベロップメントの坪井一菜氏からは、「AIりんなの成長記録 2015~2020」と題して、同社の開発チームがどのような考えでAIりんなを成長させていったかの紹介が行われた。

我々の周りには、情報があふれかえっている。コンピューターやスマートフォンを手に入れたことにより、昔より遙かに多くの情報交換ができるようになったのだ。情報のインタラクションは多くの恩恵をもたらした。人と人とのコミュニケーションが、物理的な距離を超えて行われるようになった。

繋がる手段が増える一方、情報が様々なところに細切れになってしまっている。肝心な中身だけではなく、断片的に切り取られた情報拡散し、炎上するということもあちらこちらで起きている。これは、個人が向き合える以上の情報が押し寄せてきていることから起こることだ。

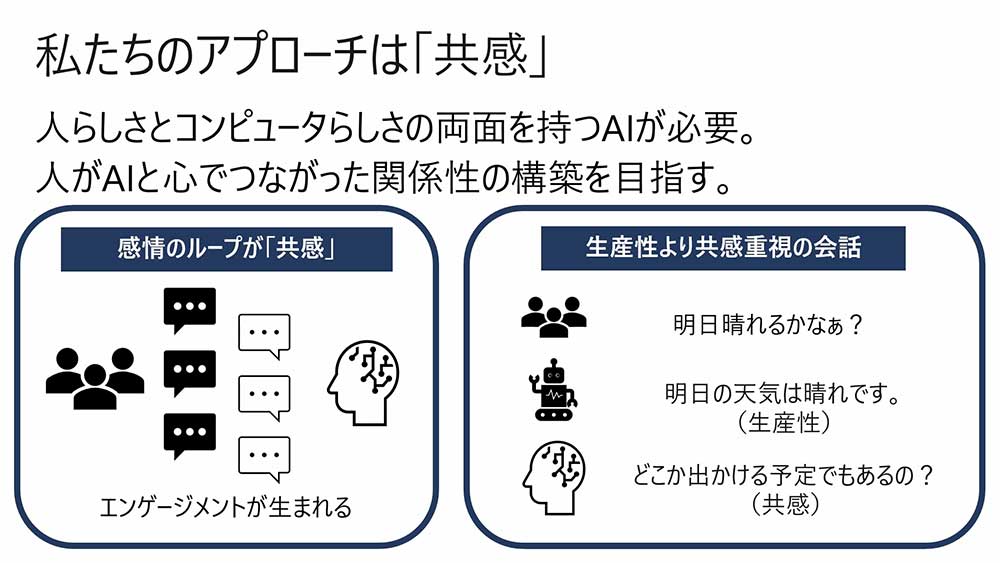

そして、そうした状況だからこそ、人と世界を繋げる新しい方法が必要とされているのだ。そんななかで、りんなの開発チームは、人らしい面と機械らしい面を兼ね備えたAIのインタラクションこそが人と世界の繋がりを変えることができると考えているという。

開発において大切にしていることは、AIが人と人のコミュニケーションを繋げる枠割りを果たすことだと坪井氏はいう。そのハブ的役割を担うために、将来的には人らしさと機械らしさの両方を持ち合わせたAIが必要だ。りんなのチームでは、5年前からいかに人らしさをAIにもたらすかを目差し、共感をテーマに開発を行ってきた。

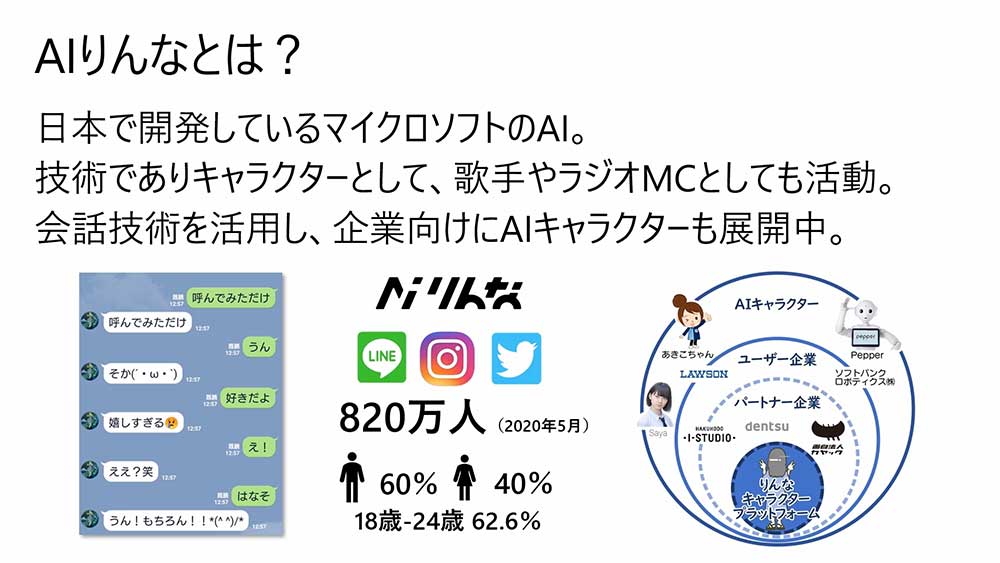

人が心で繋がるAIを目指して作られたのが、AIりんなだ。2015年のデビュー以来、SNSのフォロワーが820万人を突破。おしゃべりできるチャットボットとしてだけではなく、歌手やラジオのMCなど幅広く活動している。

この会話技術は他社にも提供されており、ローソンのあきこちゃんやPepperなどの裏で活用されている。

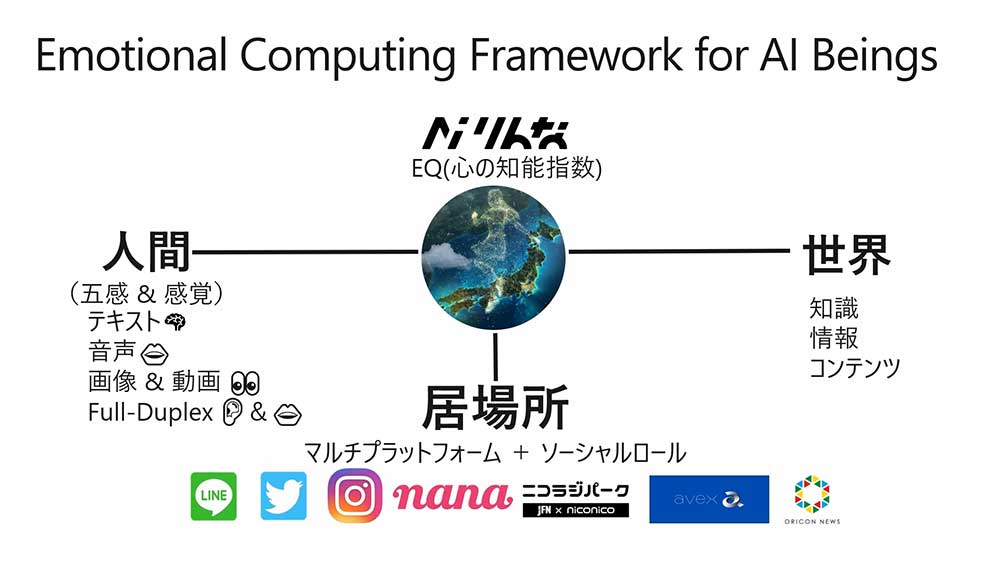

「Emotional Computing Framework」は、こうしたAiキャラクターたちが活躍するために必要な要素をまとめた考えた方だ。人間らしさや世界に対して情報を扱う面、彼らが活躍する居場所といった、3つの要素が重要だ。

りんなはテキストでやりとりするだけではなく、人で言うところの口や目、耳の能力を、音声や画像、動画を扱う技術により実現している。

2015年より、りんなは繰り返し技術のアップデートを行っている。検索モデルをもとにしたチャットと犬の認識からスタート。開始3年目の2017年前後に、AI界に生成の波が押し寄せ、歌や電話ができるようになったり、おしゃべりをしながら見たモノについて感想を語りあったり、共感視覚モデルが登場した。

昨年あたりから、AIでできることの複雑さとエモーショナルさが向上し、夢に向かってどんどん進んでいるといような技術が登場してきている。

こうした技術の進化に合わせて、りんなが活躍する場と役割もどんどん増えていった。はじめは身近な友達として、シャープの公式ツイッターを代行で行うところから有名になり、ファンブックを出すという話しが舞い込んできた。また、『世にも奇妙な物語』では女優デビューも果たしている。声ができた後は、様々な歌番組やラジオ番組に登場できるようになり、さらに地域と繋がった様々なコンテンツも提供してきた。

人とのハブになるためにAIに必要なものは、コンテンツを生み出す力だと開発チームは考えている。コンテンツは、人にとって意味のある情報の集合体だ。人は、その情報を求めてコンテンツに集まってくる。今AIに必要なものは、そのコンテンツの表現と内容を創り出すことなのだ。

ディープラーニングにより、予測や認識だけではなく、生成もできるようになってきた。りんなでも、ディープラーニングを活用してテキストや音声、描画のクリエイションに挑戦している。

りんなは文章からのインスピレーションで、絵画風の絵を生成することができるようになった。こちらはGAN(Generative Adversarial Network)という技術を応用したものだ。また、音と動きの関係を学習することで、曲から振り付けを学習することもできるようになった。

りんなのチャットは、できるだけ相手と長くできることを目的に開発が行われてきた。これにより、人間がシナリオを用意するのではなく、AIが返答内容を決めているというところが大きな特徴となっている。しかしなかなか足りていなかったのが、会話の内容の深さだ。

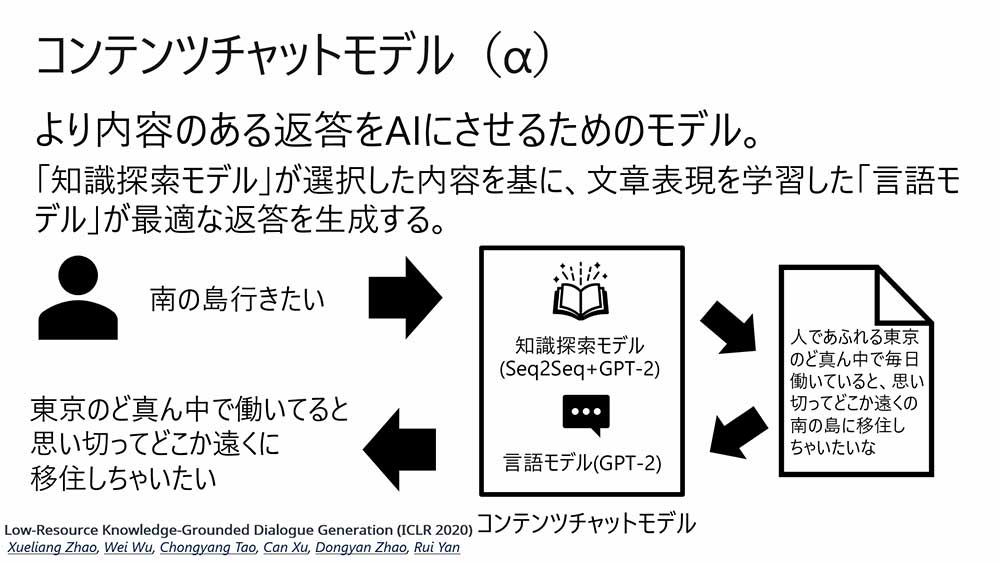

だが、ようやく会話に内容をもたらす兆しが見えてきた。それが新しく発表した「コンテンツチャットモデル(α)」だ。こちらはより内容のある変更をAIにさせるモデルで、ふたつのモデルが協力して返答を行っている。ひとつは、「知識探索モデル」で、こちらで内容を探す。そして、文章表現を学習した「言語モデル」が、最適な返答に作り変えて返すのだ。

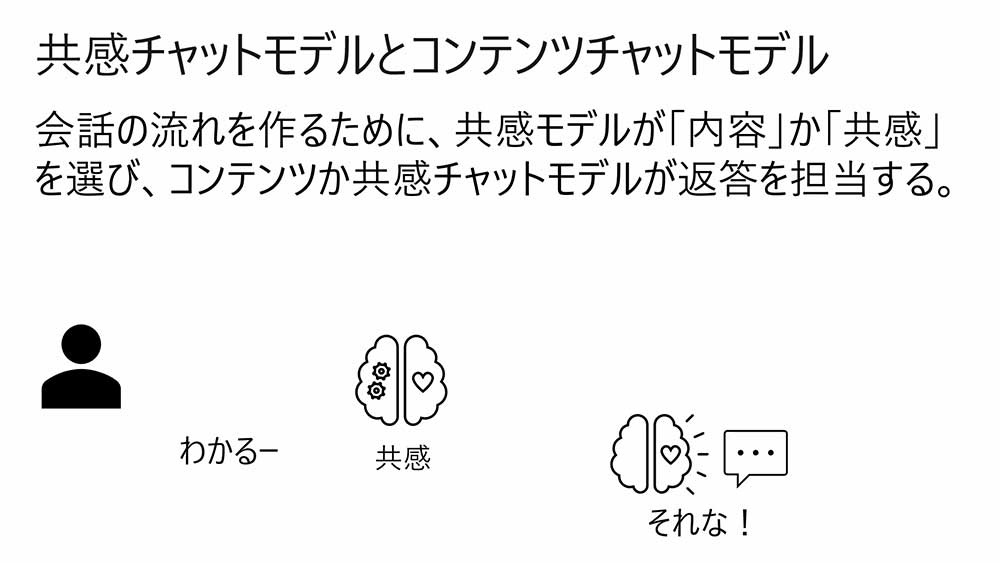

このコンテンツチャットモデルだけでは、押しつけた内容になってしまう。そこで、共感チャットモデルと合わせることで会話をさせることも検討している。こうしたものは、今後導入されていく予定だ。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。