02.04

【World MR News】『AniCast Maker』でVAWアニメ制作というビジネスが生まれる――「VRMコンソーシアム セミナー」その②

一般社団法人VRMコンソーシアムは、11月29日に東京・銀座のドワンゴ セミナールームで「VRMコンソーシアム セミナー 第1回『ビジネスにおけるアバター活用術』」を開催した。本稿ではその中から、エクシヴィ 近藤義仁氏とGREE VR Studio Lab 白井暁彦氏、NTTドコモ 副島義貴氏によるセッションの模様をお届けする。

■「VRアニメ制作のミライ」by エクシヴィ 近藤義仁氏

GOROmanことエクシヴィの近藤義仁氏と室橋雅人氏からは、「VRアニメ制作のミライ」というタイトルでセッションが行われた。

▲写真左から、代表取締役社長の近藤義仁氏とビジュアルディレクターの室橋雅人氏。

エクシヴィが掲げるミッションは、「VRを普及させたい!」だ。そのためのキーワードは“便利”になるとこと“クリエイティブ”になることだとGOROman氏はいう。VR自体は、体験したときはすごいと感じるが飽きてくる。しかし、そのすごいという部分が便利になると飽きない。

1980年代に、「MIDI」と呼ばれる規格が誕生している。これは当時のシンセサイザーなどと音の情報のやりとりをするための規格で、異なるメーカー同士でも様々な機器やPCを繋げて作曲が行うことができた。ここで生まれた概念が「DTM(DeskTop Music)」という、和製英語の略語だ。

MIDIの登場で、楽器が弾けない個人でも作曲ができるようになってきた。最近はDTMも更に進化し、MIDIデータ以外に生の音も同時に扱える「DAW(Digital Audio Workstation)」と呼ばれるものも登場してきている。ここで生まれたのが、音楽制作というビジネスだ。

このMIDIは、日本のメーカーが母体となってグローバルな規格にまで浸透し、現在ではデファクトスタンダード(事実上の標準)な規格として扱われるようになっている。それでは、バーチャル時代における新規格は何かとというと、VRMのようなアバターのフォーマットということになる。

MIDIでは、楽器が弾けない人でも曲が作ることができるようになった。ではVRMで何ができるようになるのだろうか。VRMが目指す未来は、「VRMで真に自由な仮想世界を実現する」である。これはまさにMIDIが実現してきたものだ。

そこで、アニメをストレスなく便利にVRで作ることができるツールとして開発されたのが、『AniCast Maker』だ。MIDIではDAWが普及したが、『AniCast Maker』では「VAW(Virtual Anime Workstation)」になることを目指して作られている。これができたことで、VAWアニメ制作というビジネスが生まれてくるのではないかと考えているのだ。

『AniCast Maker』の特徴は、PCとOculus RiftまたはOculus Questがあれば、ひとりでも直感的な操作でアニメを作ることができるところである。Oculusが2020年にハンドトラッキングに対応することを発表しており、『AniCast Maker』でも同様に対応していく予定である。

ここで目指しているのは、テレビアニメ放送のような高いクォリティだ。

【ご報告】 pic.twitter.com/n4BVzlWf6I

— 東雲めぐ/ Megu shinonome (@megu_shinonome) October 3, 2019

▲VTuberの東雲めぐさんが、10分ほどで作った作品。

『AniCast Maker』では、東雲めぐさんが10分ほどで作ったようなショートアニメが沢山作れるのではないか期待しているとGOROman氏はいう。ユーザーの視聴時間は短くなってきている傾向にあり、2時間の映画に耐えられない人が増えており、ショートアニメなどの需要が増えてくると考えているのだ。

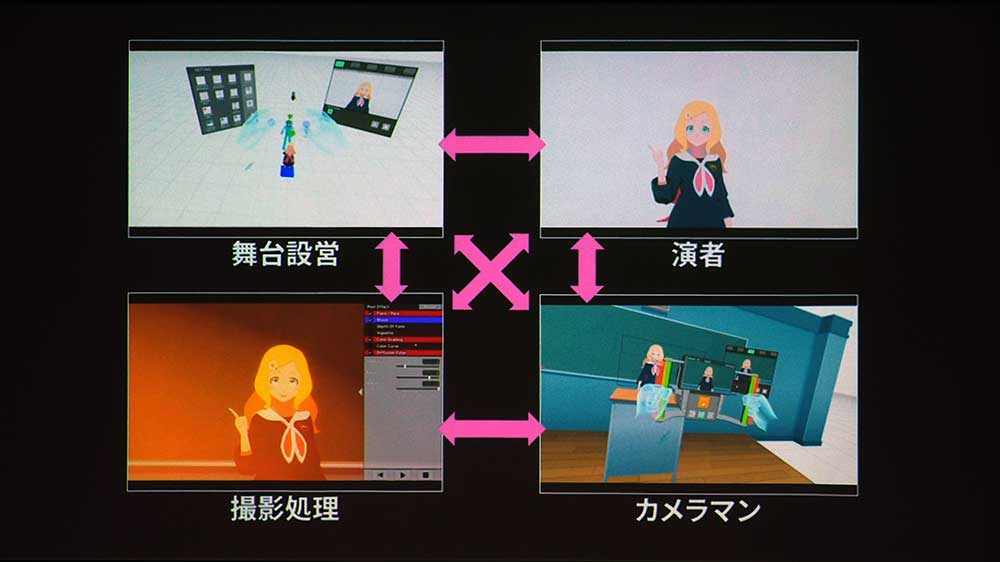

『AniCast Maker』のキモとなるのは、ロールチェンジだ。これは、役割(ロール)を切り替えながら作っていくというもので、舞台設営から演者になり、カメラマンに切り替えて、最後は撮影処理を行っていくというものである。そして、これを順番に行っていくというわけではなく、どこから始めてもいいというところも特徴のひとつだ。

舞台設営では神の視点で、キャラクターやカメラの位置などを決めていく。背景となる舞台も簡単に呼び出して設営していくことが可能だ。カメラマンの視点では、実機では高価なレンズなども自在に変更することができる。撮影時にはドリー機能を使うことで、レールを敷く必要も無く撮影が行える。

もちろんバーチャルなので、カメラの数はいくつでも増やしていくことができる。

さらなる詳しい情報に関しては、下記の記事でも紹介しているのでそちらも合わせてチェックして見て欲しい。

VRでアニメをストレスフリーで作れる新プロダクト『AniCastMaker』が発表!「Unite Tokyo 2019」レポートその②

【World MR News】VRでアニメをストレスフリーで作れる新プロダクト『AniCastMaker』が発表!「Unite Tokyo 2019」レポートその②

『AniCast Maker』は、エイベックス・テクノロジーズと共同で、現在製品化に向けて開発中である。最後にGOROman氏は、「自分に合った役割をVRの中で見つけていけるのは、バーチャル時代の生き方だ」と語り、セッションを締めくくった。

■「GREE VR Studio Lab × 株式会社NTTドコモ スペシャルセッション」by GREE VR Studio Lab 白井暁彦氏&NTTドコモ 副島義貴氏

「GREE VR Studio Lab × 株式会社NTTドコモ スペシャルセッション」と題されたセッションでは、GREE VR Studio Lab 白井暁彦氏&NTTドコモ 副島義貴氏が登壇した。まずはNTTドコモによる、「5G+VRライブエンターテイメントに向けた取り組み」の紹介だ。

▲NTTドコモ 副島義貴氏。

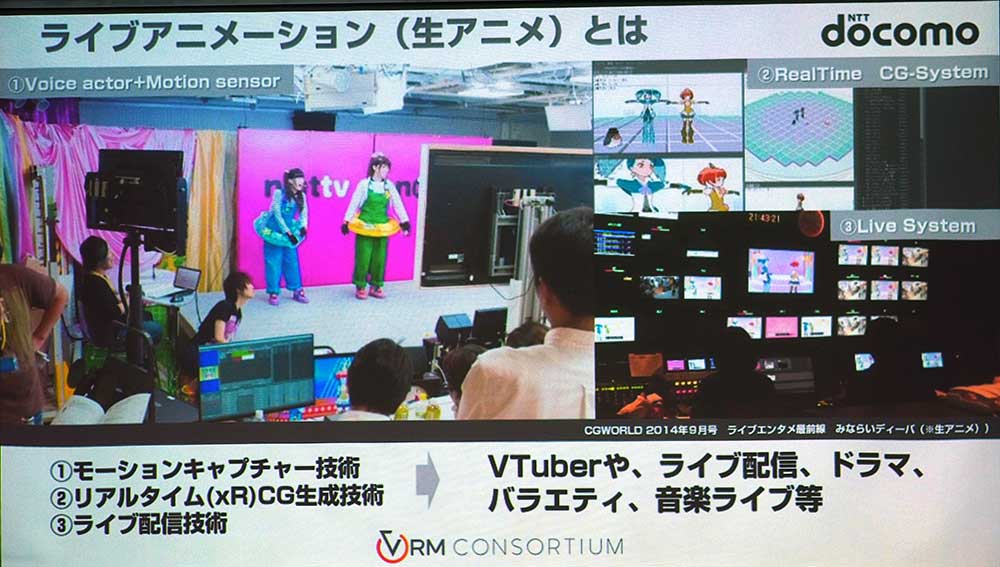

NTTドコモでは、2019年9月20日より5Gのプレサービスを開始している。中でも副島氏のチームでは、Magic Leapに投資するなどITの利点から様々な取り組みを行っている。副島氏は、5年程までにNOTTVで「生アニメ」と呼んでいたVTuberの先駆けのようなことを行っていた。

そこで使われていた技術は、モーションキャプチャーやリアルタイムCG生成、ライブ配信などだ。その当時はセガのゲームエンジンを使用し、ニコニコ生放送や東京MXなどとコラボを行っている。ちなみに生でアニメをやっていたのは、ちゃんとした予算が取れなかったというのが理由だ。

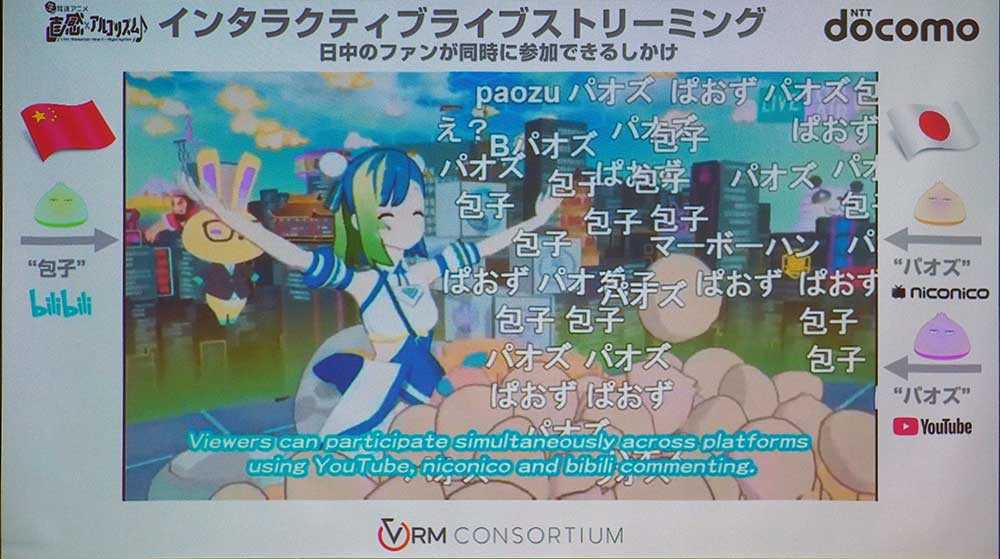

その後NOTTVが無くなり、2016年頃より世界1位のキャリアである中国移動通信と共同で「直感×アルゴリズム♪」というIPを作ることになった。2017年と2018年の2シーズン取り組み、日本と中国で同時生配信を行っている。

NTTドコモでは、その当時どうやって中国に生配信が行えるかよくわかっていなかった。そこで香港経由でこの作品のために専用線を引き、上海まで流している。こうした取り組みを行ってきた中で、5Gが始まるということで様々な協業パートナーと取り組みを行っている。

こうしたものを日本と中国で同時配信する場合、YouTubeのような共通のプラットフォームが利用出来れば楽だが、残念ながら中国ではYouTubeを利用することができない。そこで、中国と日本のコメントをCGで反映させるようにしている。キャラクターがバオズ(肉まん)を食べるシーンが出てくるため、それに合わせてニコニコのコメントなら白、YouTubeは赤、ビリビリは緑のバオズが上から振ってくるという演出にしている。

今後5Gが普及していくタイミングで、日本と中国で同じ物が見えているようにしたいと考えている。コンテンツを運営していく中で、難しいのがコラボレーションだ。VRMが登場したことで、こうしたものも手軽に実現できるようになったそうだ。

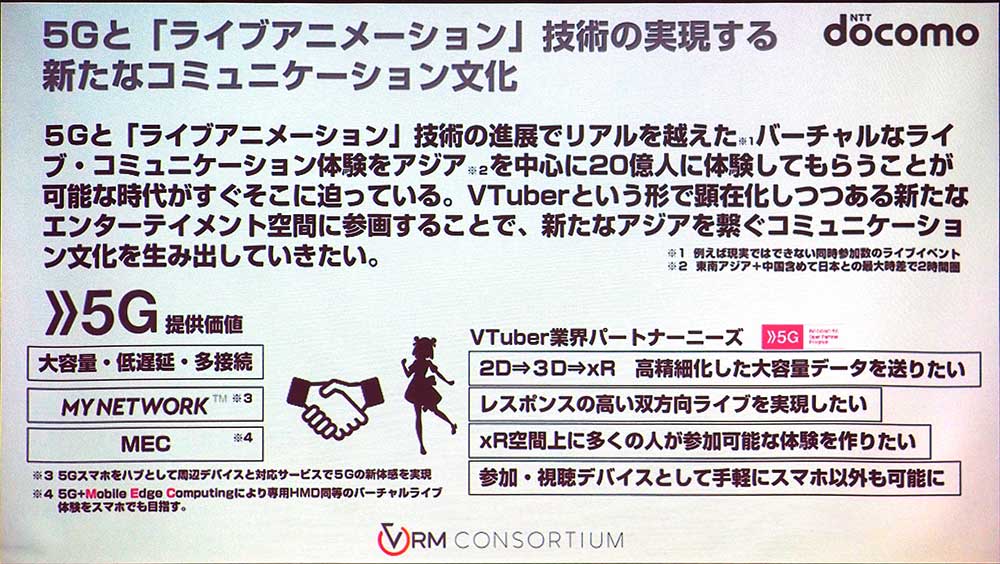

副島氏のチームが目指している物は、5Gとライブアニメーション技術を実現する新しいコミュニケーション空間を、グローバルで作っていくということだ。バーチャルなライブ・コミュニケーション体験がリアルを超える時代がくると考えており、それをアジアの20億人のユーザーに体験してもらいたいという。

GREE VR Studio Labの白井暁彦氏からは、「SIGGRAPH ASIA 2019 Real-Time Live! 5G時代のR&Dと7,154kmへの挑戦」というテーマで、同氏の取り組みが紹介された。

▲GREE VR Studio Labの白井暁彦氏。

「SIGGRAPH」は、毎年開催されているCGとインタラクティブテクノロジーに関する国際会議だ。2019年は夏に「Virtual Beings」というカンファレンスを実施し、世界から20社が集まっている。その中でコンテストが行われ、「直感×アルゴリズム♪」が受賞している。

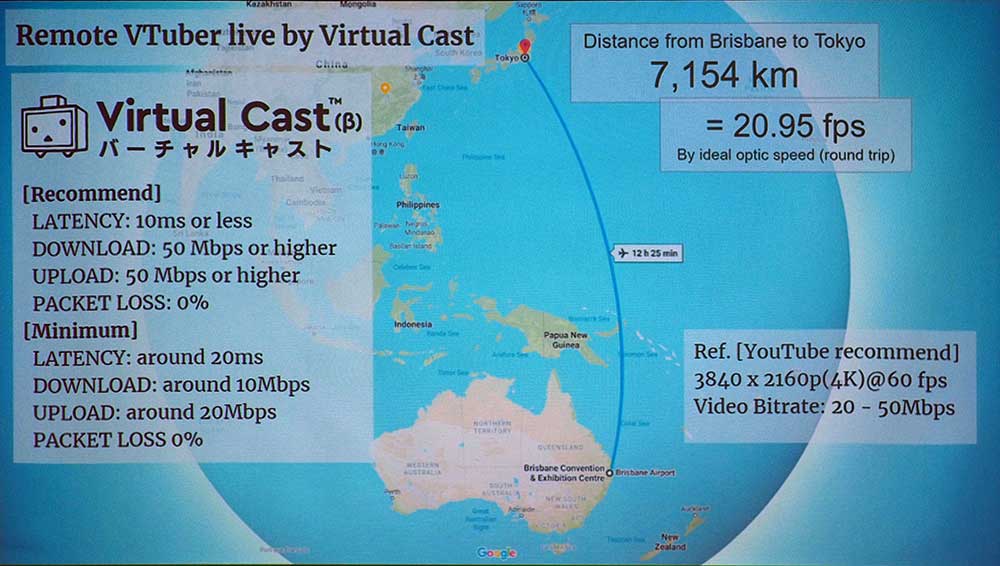

今回白井氏は、オーストラリア・ブリスベンから7154キロメートル離れた東京に向けて、『Virtual Cast』でライブ配信を行っている。これは光の速度で往復20.95fpsぐらいになるため、上手くいくのかわからなかったという。

新しい技術にも取り組んでおり、リアルタイムで配信画面の演出も行っている。7000キロも離れたところで、光の速度よりは約リンゴの矢が突き刺さるということを行っていたのだ。

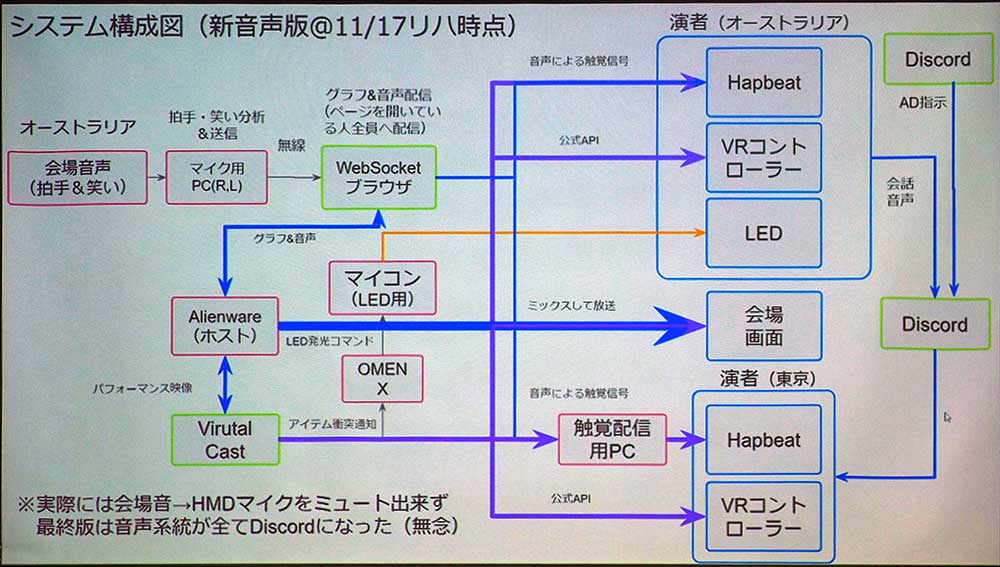

「リモプレ」というコードネームで呼ばれている技術では、拍手や笑い声があると演者に装着されたLEDが光り、『Hapbeat』というネックレス型ウェアラブルデバイスで体に振動を伝えるということを行っている。

▲演者側も振動で体感できるようになっていた。これで視覚以外の情報からもライブ感が増すのだ。

システム設計は、構想段階からはシンプルになったが、それでもかなり大がかりなものとなっている。音声に関しては、『Virtual Cast』のエンタープライズ版に最新の音声技術が採用されており、高品質で同時性を保つことができるものだった。

しかし、いざ現場に訪れてみると会場の音響スタッフからNGが出されてしまったという。話している声が反響して戻ってくるエコーや、英語の発音時に「S」と「TH」の音が聞こえないなど、様々な問題があったのだ。そこで、様々なバージョンの『Virtual Cast』とチャットアプリの『Discord』などを併用して乗りきっている。

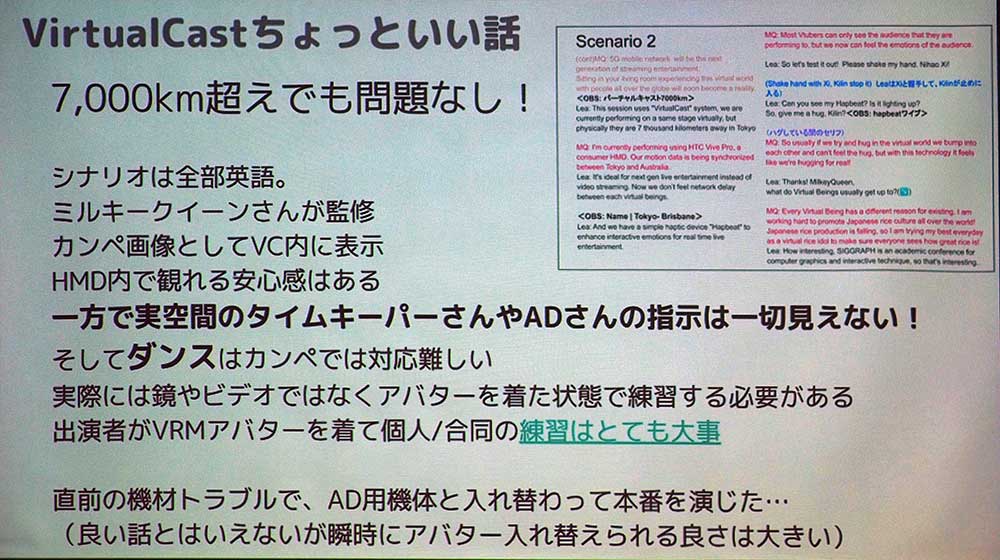

『Virtual Cast』を使った配信では、7000キロメートルという離れた距離であっても問題はなかった。ゲーム的な技術でモーション変換を行っており、そのため光の速度を超えることが可能だったという。シナリオは英語だったが、カンペ機能があったため楽だったそうだ。

その一方で、VRゴーグルを被ってしまうと現実空間でADからの指示があっても一切見えないため、そうしたことも含めてライブエンタメになっていた。そのため、公式配信ではMIRO氏の「時間時間」という声も思いっきり入ってしまっているという。

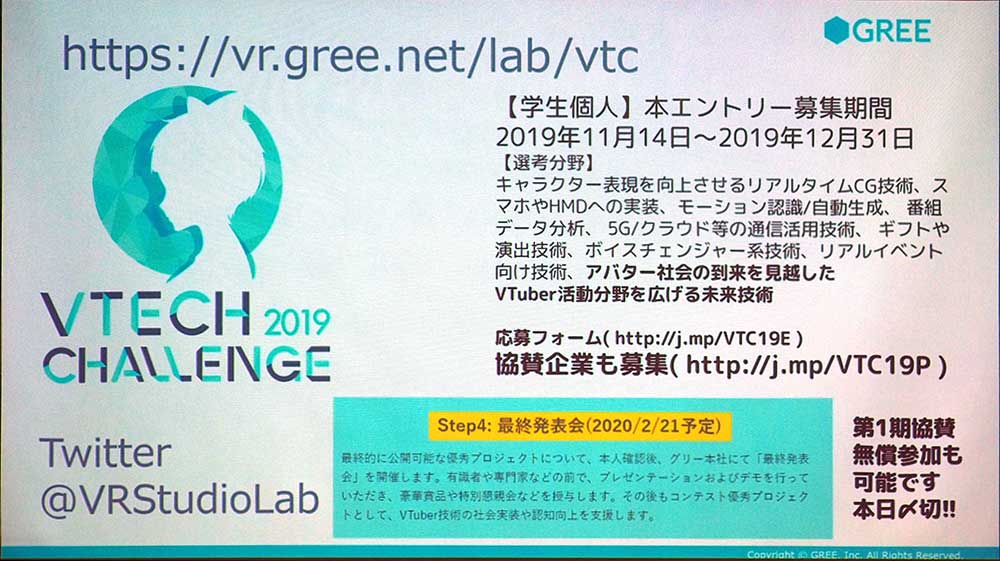

GREE VR Studio Labでは、「学生対抗VTube技術コンテスト」を実施することが重要だと考えている。これはグループではなく、垂直統合できる才能をひとりでも発掘していく必要があるからだ。そこで「VTech Challenge」という研究チャレンジコンテストを実施し、2020年2月21日に最終発表会を開催する予定だ。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。