07.17

【World MR News】『REALITY』アプリ統合と『バーチャルキャスト』のモーションキャプチャ&配信用ARシステム運用事例を紹介――「WFLE VTuber Hackers Meetup Vol.02」レポート①

Wright Flyer Live Entertainment(以下WFLE)は、7月2日にVTuberやライブエンタメに特化した勉強会「WFLE VTuber Hackers Meetup Vol.02」を、グリー セミナールームで開催した。このイベントは、元々WFLEの社内勉強だったものを、好評を受けて社外向けに開催したものだ。

当日はWFLEとバーチャルキャストの社員が登壇し、それぞれの知見について紹介が行われた。こちらではその中から、WFLE 清貴幸氏、バーチャルキャストのさんたーP氏とisana氏のセッションの模様をレポートする。

■「ネイティブアプリとUnityアプリ統合への道」WFLE 清貴幸氏

WFLEの清貴幸氏が今回発表したのは、同社が運営しているVTuber専用ライブ視聴・配信アプリ『REALITY』のアプリ統合に関する話題だ。元ネイティブ開発環境で作られた『REALITY』と、Unityで開発された『REALITY Avatar』というふたつのアプリがあり、それらを統合してひとつのアプリにしている。

▲清貴幸氏。

この統合をすることになった背景には、ふたつのアプリに分かれていることでアプリをまたいだ試作や機能開発が難しくなったのがきっかけだ。統合した結果、ネイティブで作られた部分からUnityで開発した部分がシームレスで遷移するようになった。

開発は3名で行われ、2019年1月より技術調査を開始し、3月28日には『REALITY』v2.0.0としてリリースされている。

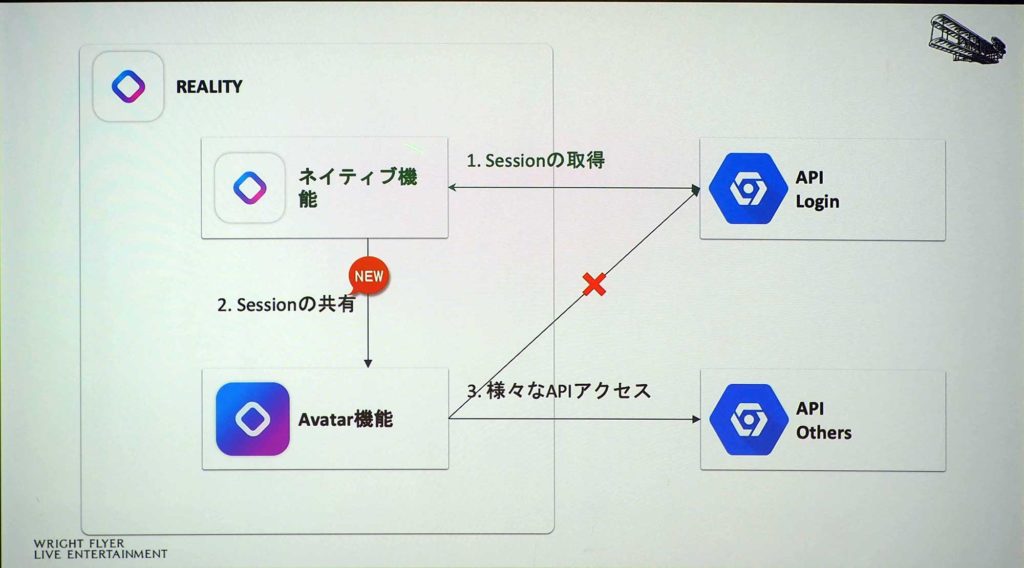

Unityをライブラリ化し、ネイティブ機能とAvatar機能の間をつなぐインターフェイスを実装している。また、後からダウンロードする仕組みのアセットバンドルを導入。Unityのライブラリ化は、Unityから出力されたソースコードを、ネイティブ環境からライブラリとして呼び出している。

アプリを統合したことにより発生した課題もあった。たとえば、画面遷移の変更でAvatar昨日内にあったログイン機能は削除されている。そのため、単純にAvatar機能を呼び出すだけでして表示するだけではダメで、セッションを共有するように繋ぐ必要があった。

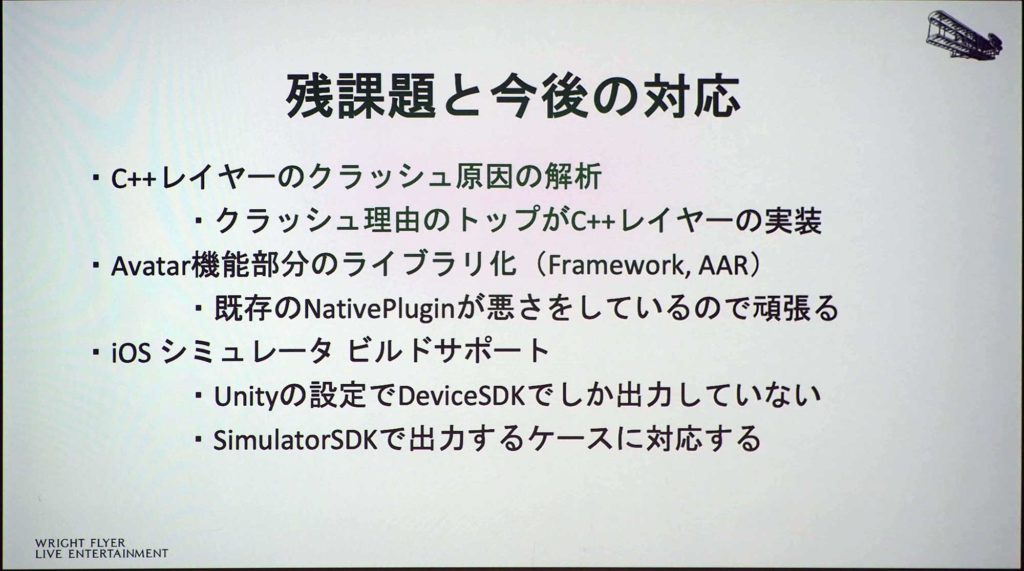

作成したインターフェイスでは、重要な要素である状態とイベントの共有を行えるようにしている。出来上がったファイルは294メガバイトとかなりのサイズであったため、アセットバンドルを実装している。現在残っている課題としては、統合した結果C++レイヤーがクラッシュするようになったため、その解決で悩んでいるという。また、Avatar機能のライブラリ化や、iOSシミュレータ ビルドのサポートなども考えているそうだ。

■「イベントにおけるモーションキャプチャの運用について」バーチャルキャスト さんたーP氏

バーチャルキャストのさんたーP氏からは、「イベントにおけるモーションキャプチャの運用について」をテーマにセッションが行われた。VR空間内のスタジオで、リアルタイムにコミュニケーションができるVRライブコミュニケーションサービス『バーチャルキャスト』では、イベントごとに様々な要件がある。その要件にはやりたいことや、やれないことがある。

▲さんたーP氏。

モーション入力機材では、タイムスケジュールの問題スーツを着せるだけでもセットアップに時間が掛かってしまう。また、空間では伝播干渉や赤外線干渉、スピーカーによる振動などの問題がある。そのため、制約に応じて最適な機材を取捨選択していく必要があるのだ。

出力システムについても、自社開発のARシステム『Polaris』につなぎ込んだり、イベント用レンダリングシステムに繋いだりすることもある。

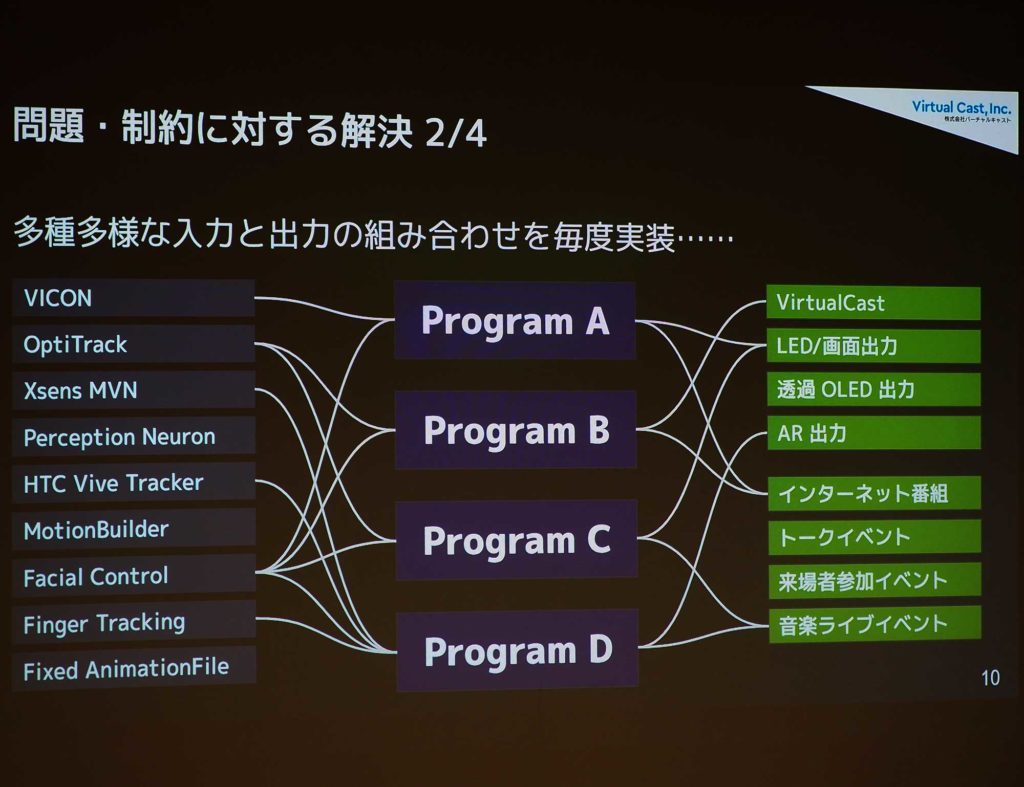

多種多様な入力と出力の組み合わせがあり、それを毎回実装していると保守性も低く新開発のハードルが高くなってしまう。そこで、同社では保守性と拡張性を高める『MotionHub』という仕組みを作っている。

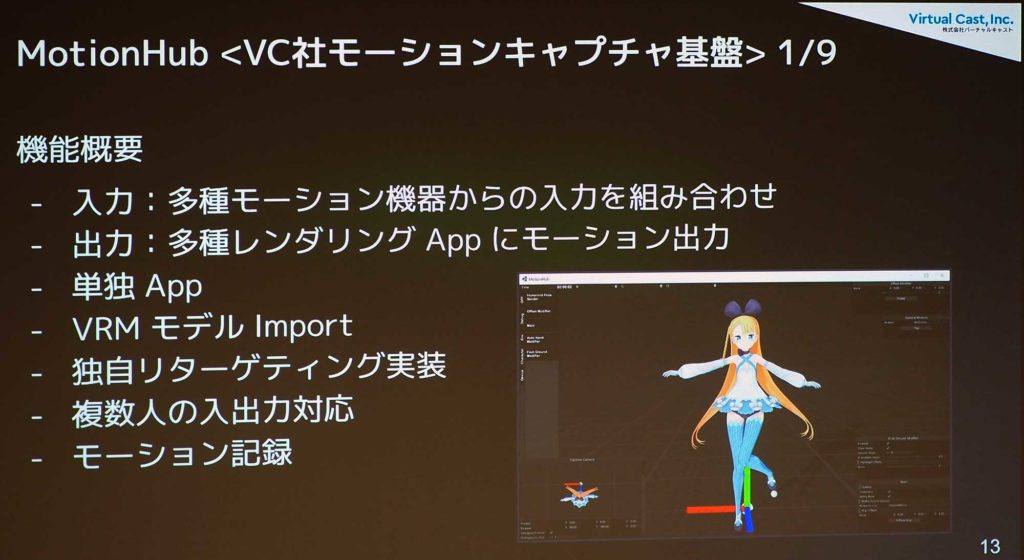

この『MotionHub』は、モーションキャプチャ機器からレンダリングアプリまでの経路を繋ぐためのアプリだ。単独で動作してVRMモデルをインポートし、モーションキャプチャ機器からキャラクターのモデルに対するリターゲティングの実装も独自に行っている。

主な機能としては、独自ドライバを書き起こしたことにより、純正プラグインよりもXens MVNの精度が向上している。イベント中に『MotionHub』自体が落ちてしまうと大変なため複数のPCで起動して冗長構成が取れるようになっている。また、案件に合わせて新しいデバイスの組み合わせが必要であるため、拡張性の高い形で開発が行われている。

■「配信用ARシステムの運用例紹介」バーチャルキャスト isana氏

バーチャルキャストのisana氏からは、「配信用ARシステムの運用例紹介」というテーマでセッションが行われた。先端演出技術開発セクションに所属しているisana氏。同部署では、「ニコニコ超会議」や「超歌舞伎VR」などXR系技術を活用し、様々な演出向けの技術開発と運用を請け負っている。その中のひとつに、生放送のARシステムの開発と運用をisana氏が担当している。

▲isana氏。

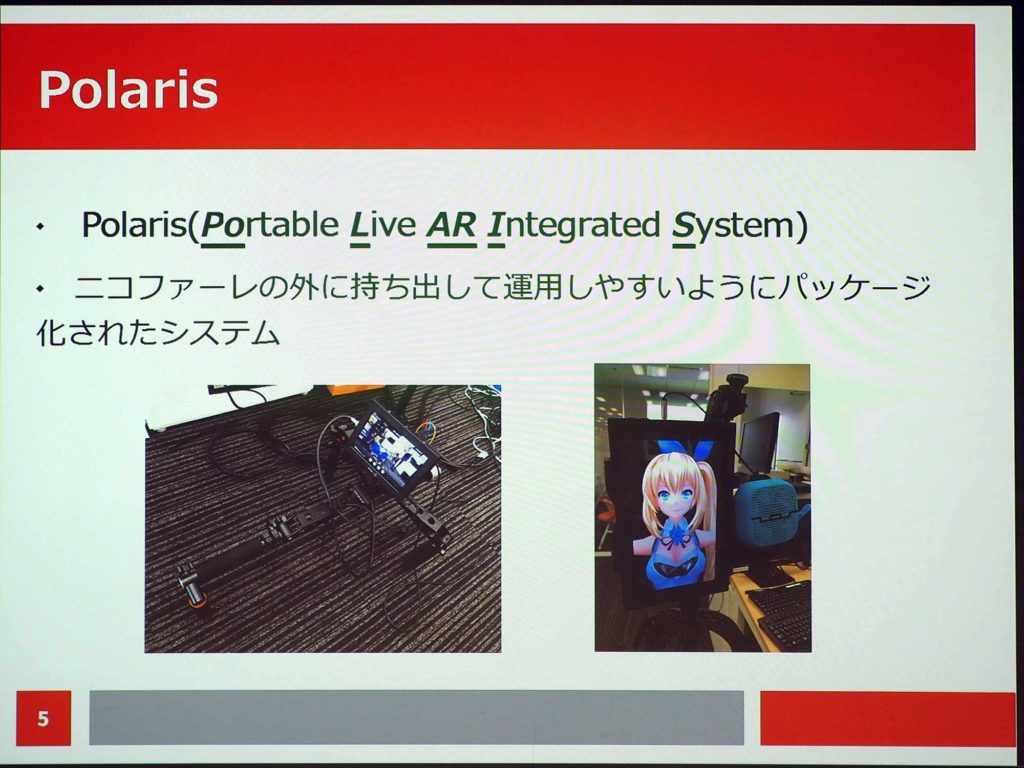

ニコニコ生放送のARは、主にニコファーレが中心だがサイタマスーパーアリーナや幕張メッセ、海外ロケなどでも稼働している。そこで使われているシステムが、『Polaris(Portable Live AR Integrated System)』だ。こちらは、ニコファーレの外に持ち出して運用しやすいように、パッケージ化されたシステムである。

ニコファーレでは、天井にセンサーをぶら下げてカメラにマーカーを付けてARを実現していた。それではニコファーレの外では対応しにくいということもあり、この『Polaris』をメインに使っているそうだ。

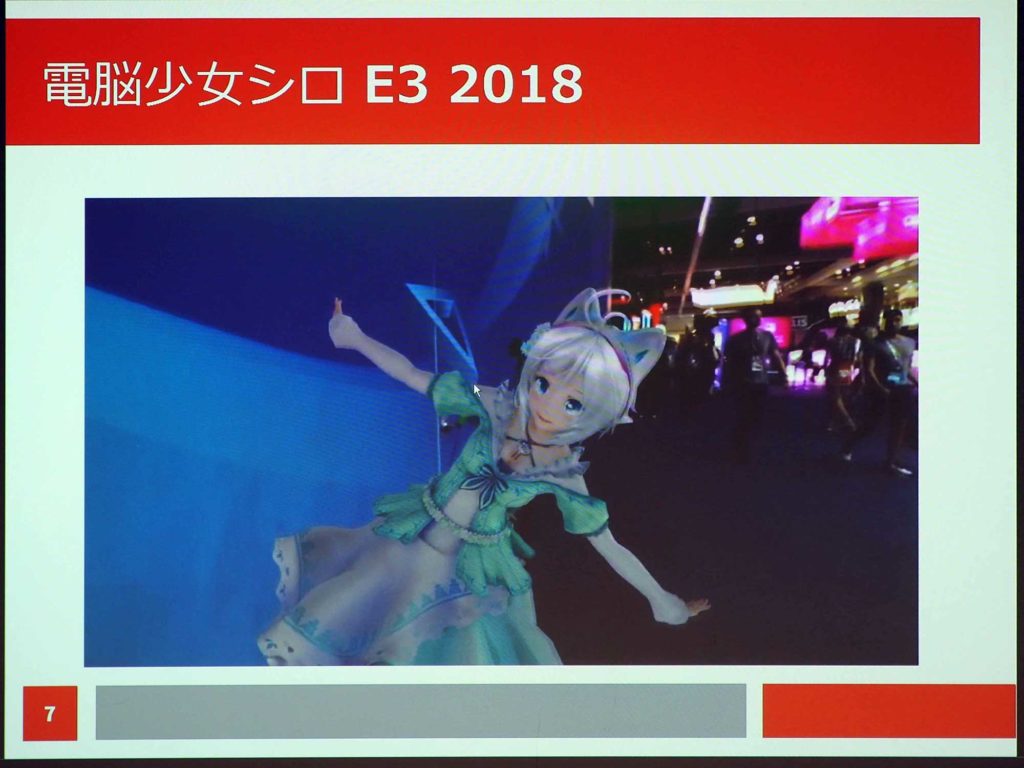

事例としては電脳少女シロさんが、「E3 2018」の会場で、英語でインタビューを行う様子を生中継している。こちらはチーム初の海外ロケで、『Polaris』を初めて使用したケースである。会場内にはモニターが設置されており、シロさんの姿が見られるようになっていた。

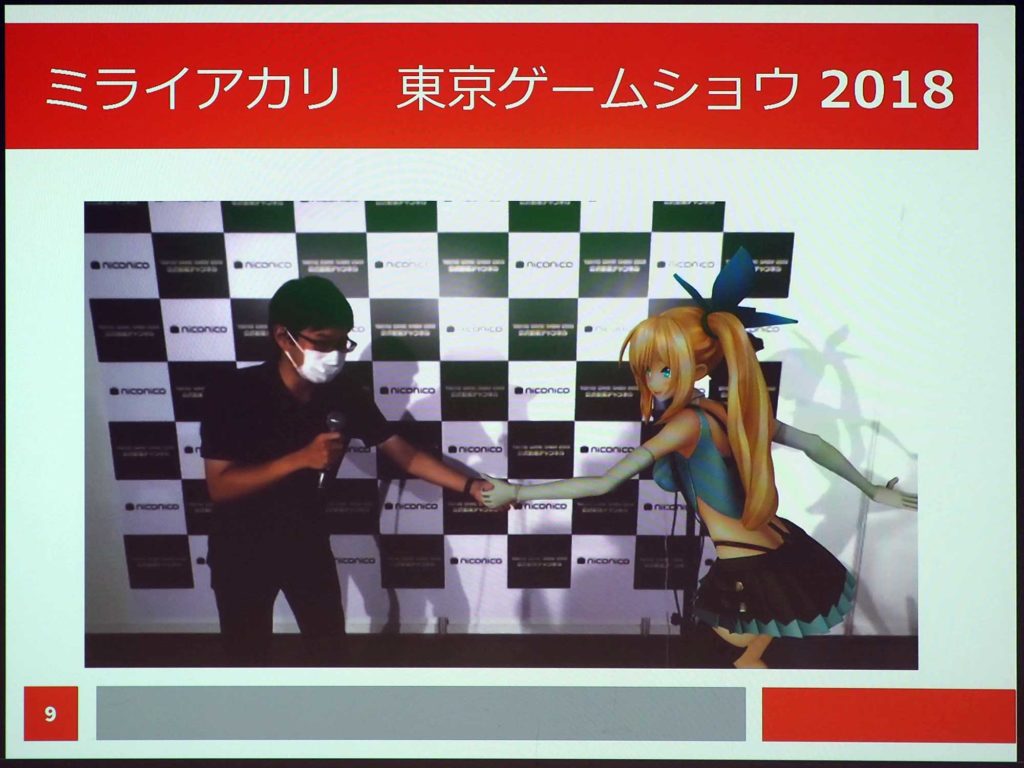

「東京ゲームショウ2018」では、会場の一角に専用ブースを設けて訪れた人にミライアカリさんがインタビューをするという企画を実施している。こちらも『Polaris』を使用したケースだが、それに加えて定点カメラを1台追加している。その理由は、本番中にトラッキングがブレてしまうことがあり、キャリブレーションをやり直さなければならなくなってしまう。しかし、生放送中であるためできないため、スイッチングで逃げられるように調整不要な定点カメラを設置していた。

ニコファーレで開催された「電脳少女シロ 生誕祭」では、ファンのアバターである「シロ組パネル」をかたどったベニアのパネルに、来場者にラインストーンを貼ってもらい、それをシロさんにプレゼントするという演出を行っている。

バーチャル空間ではCGとして表示されるのだが、こちらは撮影中に現物の写真を撮影してあらかじめ組んでおいたモデルにテクスチャーを流し込んで実現している。

「モンスターストライク4周年記念イベント」では、同ゲームのマスコットキャラクターであるオラゴンが、リアルなオーケストラを指揮するという演出が行われている。こちらは、照明センサーで現実世界のスポットライトに合わせてキャラクターが明転・暗転し、会場内に炊かれたスモークに合わせてCG内にもスモークを出している。キャラクターのモーションは、ボーンアニメーションの代わりにAlembicを使用している。

演奏者からは、指揮者のオラゴンの姿は見えないのだが、各自がイヤモニを付けて同期を取っていたそうだ。

直近の事例では、『カメラ連動DOF(被写界深度)』を開発している。こちらは、現実のカメラのフォーカスに合わせてCGモデルにピントが合ったり外れたりするというものだ。F値や画角、フォーカスといった、現実のカメラのパラメータデータをリアルタイムに取得して、CG側に反映している。

▲手前のキャラクターから背景のポスターにフォーカスのポイントが変わっていく。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。