06.18

【World MR News】『Beat Saber』風のコンテンツ作りに挑戦などXRに関連したゆるめのLT会――「第5回勉強会」レポート

地域おこしXR研究会は、6月2日にコミュニケーションツールの『Discord』を使用したオンラインイベント「第5回勉強会」を開催した。本稿ではその中から、トルクス代表の山田宏道氏、xrdnk氏、KotaNagashima氏のセッションの模様をお届けする。

「Unityで作るオリジナルウェブカメラ」by 山田宏道氏

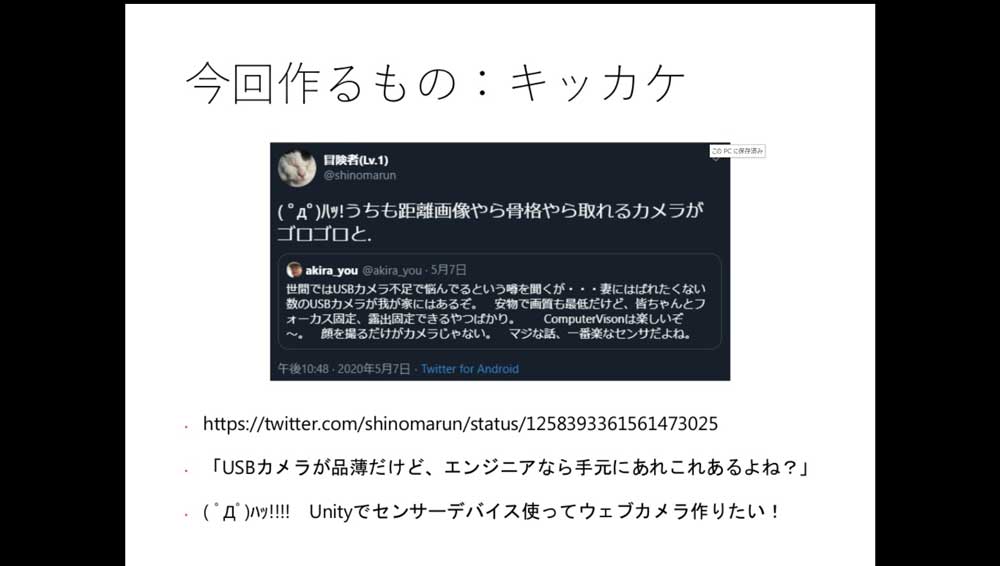

山田宏道氏からは、「Unityで作るオリジナルウェブカメラ」をテーマにセッションが行われた。今回山田氏がこのテーマに取り組んだのは、テレワークの急増からウェブカメラが品薄状態という状況にあるなか、実は家の中に様々なセンサーを持ったデバイスがあり、それを応用することでウェブカメラが作れるのではないかというツイッターの投稿を見たのがきっかけだった。

そこで使用したのが、『Intel RealSense T265』というデバイスである。1年ほど前に勉強会を行ったときに購入したものだったが、すっかりその存在を忘れていたそうだ。こちらには、魚眼のモノクロカメラがふたつ搭載されているほか、姿勢情報などを取得できるセンサーも搭載されている。また、自分の位置情報を構築できるSLAMにも対応している。価格的にも、2万円台とそこそこ安価なものとなっている。

Unityで『Intel RealSense T265』を使うにあたり参考にしたサイトが、凹み氏が運営する「凹みTips」だ。こちらでは、わかりにくいUnity SDKの使い方がわかりやすく解説されている。

- 凹みTips

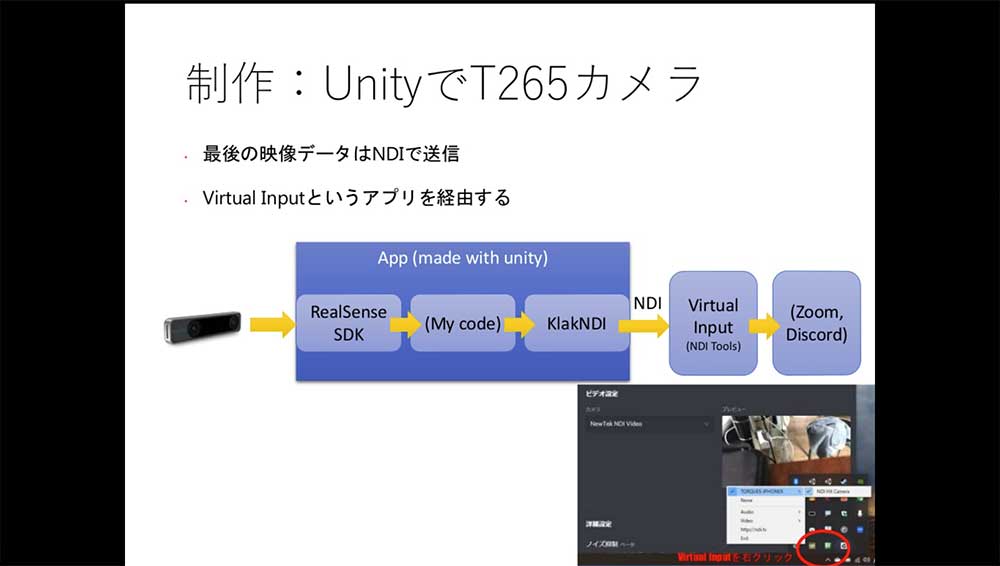

今回作る物は、最終的にはZoomなどでも使用できるウェブカメラだが、その間のアプリ部分になる。アプリ間で映像データを受け渡すことになるのだが、Windowsの場合は「Spout」か「NDI」のどちらかの2択となる。

それぞれの違いだが、「Spout」はWindowsのみで使用するもので「NDI」はWindowsとMac、iOSなどで使用できる。Unityの組み込みやすさに関してはいずれも変わらないが、今回は「NDI」を採用している。その理由は、iOS用アプリが5月中まで無料だったからだ。

流れとしては、『Intel RealSense T265』から「RealSenseSDK」で映像を取り込み、いろいろ加工した後で「KlakNDI」を使って、外部に出力。そのNDIの映像を、無料で公開されている「Virtual Input」で受け取り、ZoomやDiscordといったサービスで、カメラの選択で選べるようになるといった感じだ。

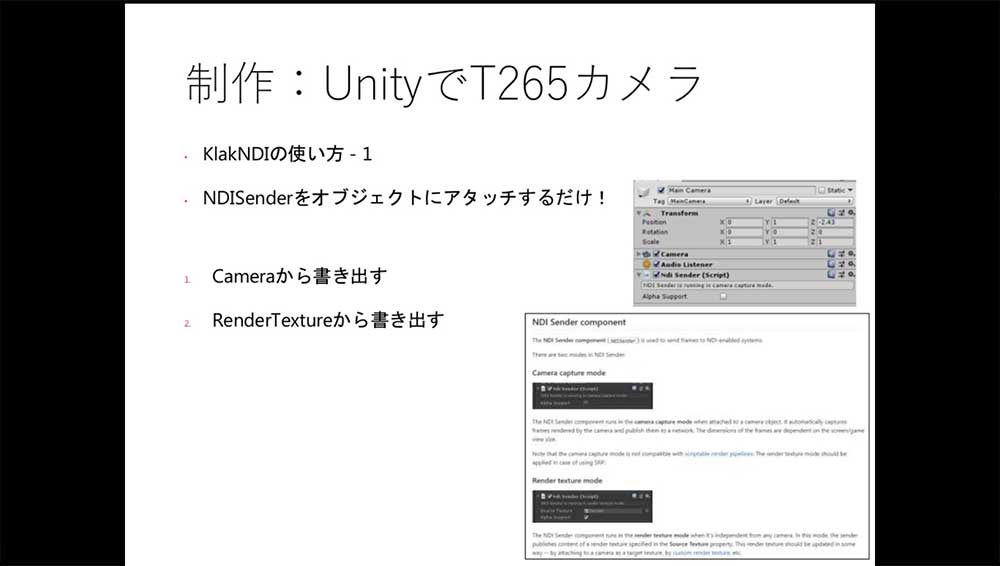

「KlakNDI」自体の使い方は簡単で、出したい映像のカメラまたは出したい映像のRenderTextureに、「NDISender」というコンポーネントをくっつけてあげるだけである。

そのまま映像を出して終わりではつまらないので、元々ふたつカメラがあるので、立体視できるのでは無いかと考えた。そこで購入したのが赤青の3Dメガネだ。赤と青の映像だと、光の三原色で重なっている部分は紫になる。しかし、赤とシアンの場合は白くなりより綺麗な映像になる。

しかし、購入した赤青3Dメガネは青に近く、もうひとつ用意したほうもシアンに近いものの、100パーセントシアンにするとその色が見えてしまう。そのため、レンズと出力する映像を調整する必要があるという。

「Beat Saberっぽいのを作ってみた」by xrdnk氏

続いてxrdnk氏からは、「Beat Saberっぽいのを作ってみた」というテーマでセッションが行われた。作ったゲームは、左手に銃、右手に剣を持ってボックスを壊していくといった内容の作品だ。

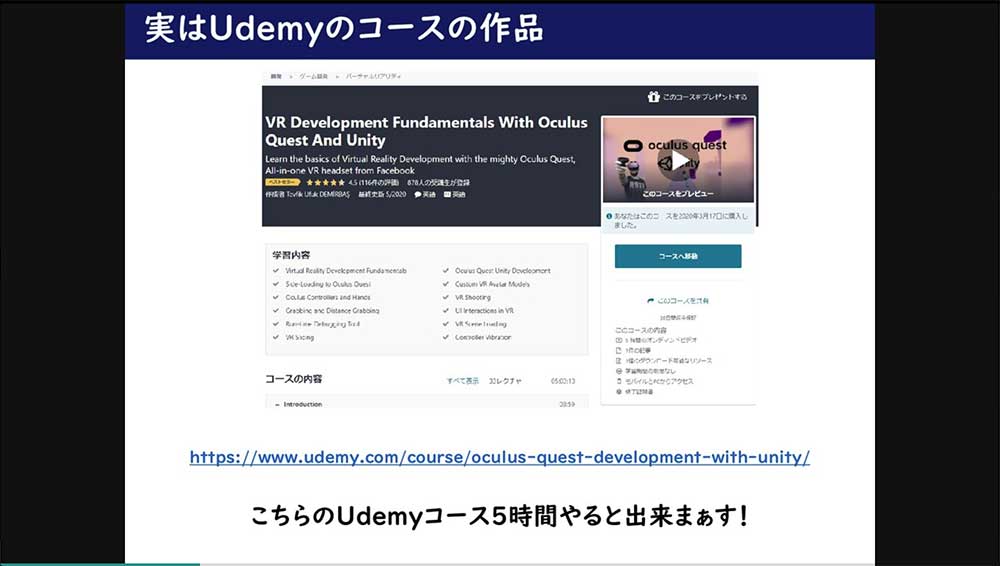

実はこちらはゼロから作ったモノというわけではない。Udemyというオンライン学習のコースで、5時間ほど学んだ後で作れるものだという。Udemyのコースは、VRやOculus Questなどに関連したものがあまりない。日本語ではウェブ系が多くなるため、英語版のほうを利用することになるという。

Udemyのコースはすべて英語だが、字幕が用意されているため、映像と字幕である程度内容を理解することができる。コース内容は、前半はOculusが提供している開発用の「Oculus Integration」の基礎を学んでいき、後半で『Beat Saber』風のゲームを作るといったものとなっている。

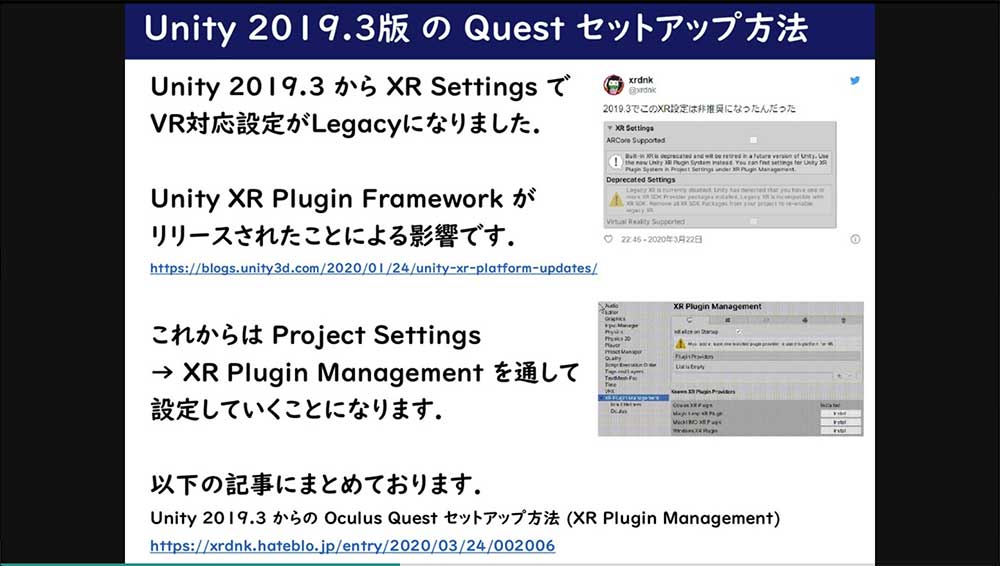

こちらをオススメする理由は、Unity 2019.3からのVR設定方法の解説が含まれているところと、これからOculus Questを開発したいと思っている人にとってエッセンスが詰まっているところだという。

「Unity XR Plugin Framework」がリリースされた影響で、Unity 2019.3から、XR SettingsでVR対応設定がLegacyになる。そのため、今後はProject Settings からXR Plugin Managementを通して設定していくことになる。

「Oculus Integration」でテレポートを実装する場合、OVRスクリプトコンポーネントは10種類ほどあるが、そちらもしっかり説明が行われている。VRではモノを掴むという行為は一般的だが、そちらを実現するのに近くにあるものを掴む「OVR Grabber / Grabbable」と、遠隔にあるものを掴む「Distance Grabber / Grabbable」も説明されている。

先ほども触れたように、コースの後半ではゲームを作っていくことになる。そのときに必要となってくるのが、ボックスを切断する方法だ。こちらは、オープンソフトウェアの『Ezy-Slice』を利用することで、すぐにVRオブジェクトの切断を実現することが可能だ。

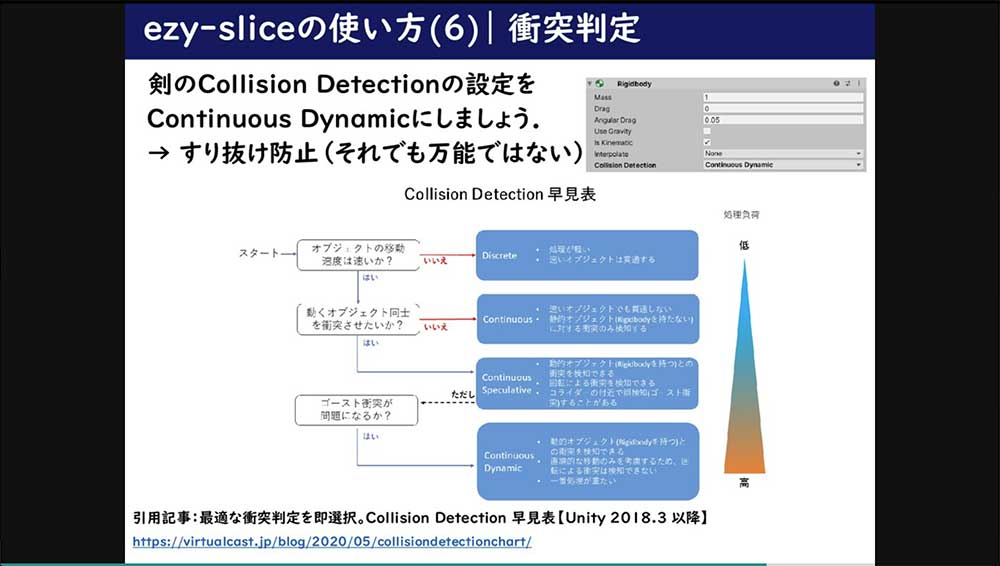

『Ezy-Slice』を使用する際の注意点としては、「MeshColider」の「Convex」をfalseにしておかないと、すり抜けてしまうところだ。剣の衝突判定がデフォルトでは「Dscrete」になっているが、これでは速く移動するオブジェクトはすり抜けてしまう。そのため、「Continuous Dynamic」などにしておくことがオススメだそうだ。

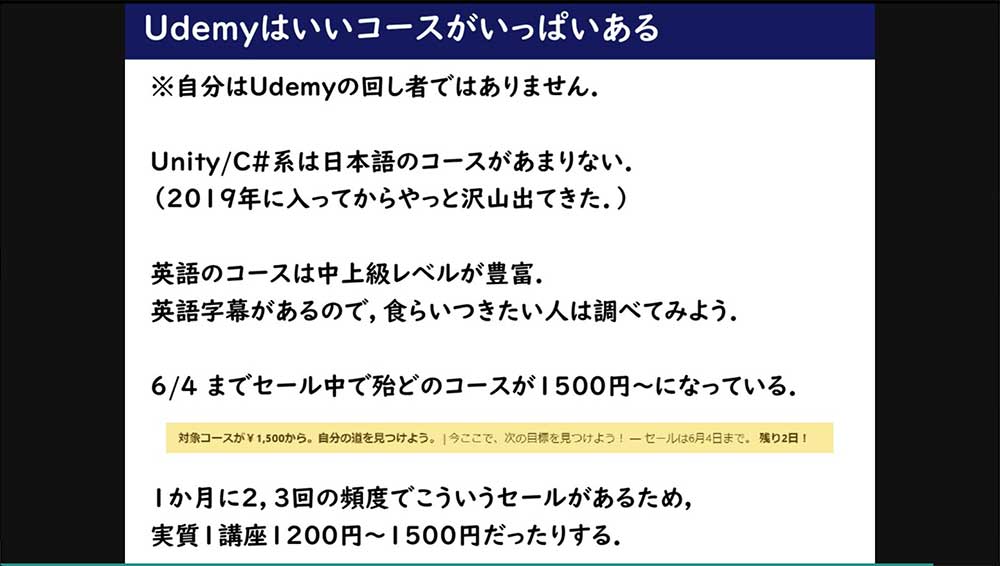

そのほか、OVR Hapticsにテクニックなどもこちらのコースで紹介されている。Unity/C#系のコースは、Udemyではあまりなかったが、2019年に入り増えてきた。一方、英語のコースは中上級レベルが豊富に取りそろえられている。

月に2~3回の頻度でセールが行われているため、そのタイミングで利用するというのもいいだろう。

「なろう系VRMMOの技術と現在の技術比較」by KotaNagashima氏

KotaNagashima氏からは、「なろう系VRMMOの技術と現在の技術比較」というテーマでセッションが行われた。なろう系小説を読むのが趣味だという同氏だが、そこに出てくるものが現在のテクノロジーでできそうなことが書いてあることから、比較してみようと考えたという。

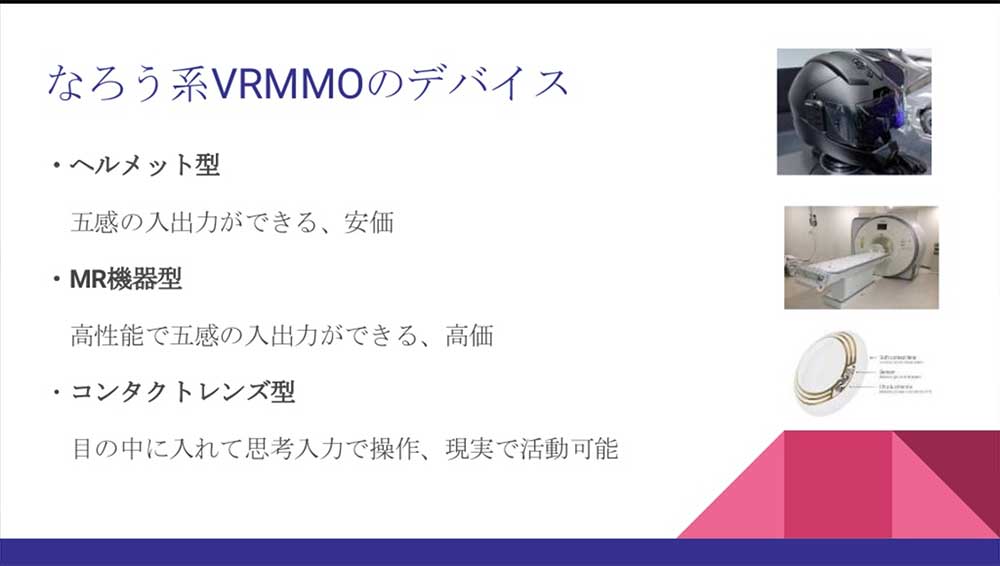

まずはなろう系VRMMOのデバイスだ。こちらは主に、ヘルメット型とMR機器型、コンタクトレンズ型の3タイプがある。

機能としては、電気信号を入出力して五感を再現しているものと、ヘルメットタイプなどでは自分の生体情報をスキャンすることができる。また、病院の身体情報をデバイスに登録して、特定の人物しか使えないようにするというものもあった。防犯や安全のために、精神的高揚や身体的振動を検知して強制ログアウトしたり、思考入力や音声入力が付いていたりする。

なろう系の五感へのアプローチは、電極などを刺さない非浸食型の電信号のやりとりで再現が行われている。視覚や聴覚、触覚については特に触れられていないが、味覚と嗅覚は再現できないことがある。

また、人間には無い部位の操作については、思考入力や感覚の拡張が行われている。

それに対して、現実で五感をだます方法には、まず視覚へのアプローチがある。こちらは、ディスプレイ(HMD)、網膜投射、網膜電気刺激の3つの方法がある。特にディスプレイに関しては、各社から様々なタイプのものがリリースされている。

変わり種は、コンタクトレンズ型のARデバイスである『Mojo Lens』だ。こちらはまだテスト段階だそうだが、今後の進展に期待したいところである。

網膜投射には、メガネ型のARで『RETISSA Display』というものがある。こちらは直接網膜に映像を投射するため、視力に依存しないところが特徴だ。網膜電気刺激には、電極を目のまわり貼り付けて電流を制御することで、視界に映像を見せる技術がある。現状は、モノクロの十字架の映像が見える感じだという。

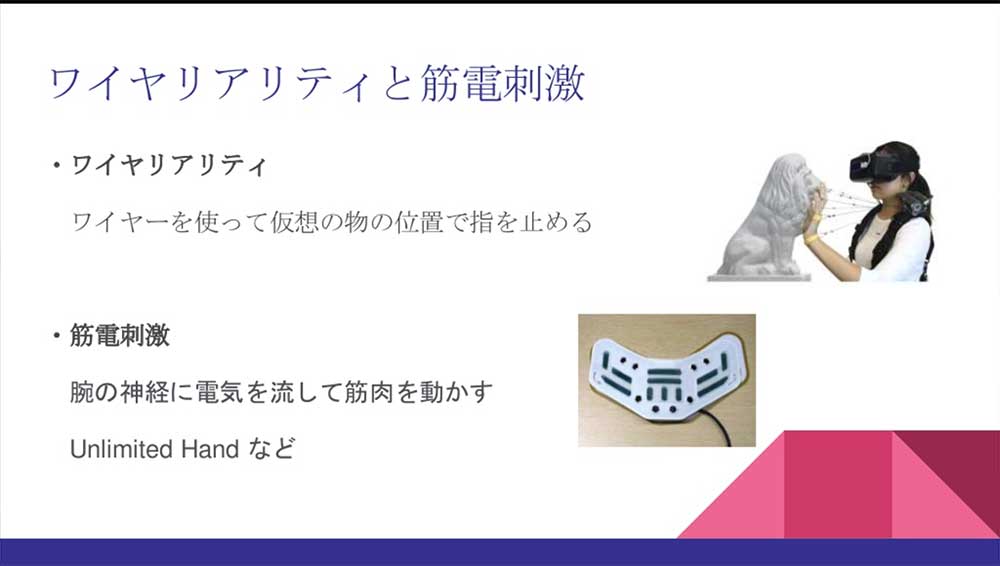

触覚へのアプローチには、ワイヤリアリティ、筋電刺激、ハプティクスの3種類がある。ワイヤリアリティは、ワイヤーを引っぱることで仮想のモノの位置を、指で止めるというものだ。『Nintendo Labo』のロボットが、それに近いものだ。

筋電刺激は、腕の神経に電気を流して筋肉の収縮を制御するものだ。

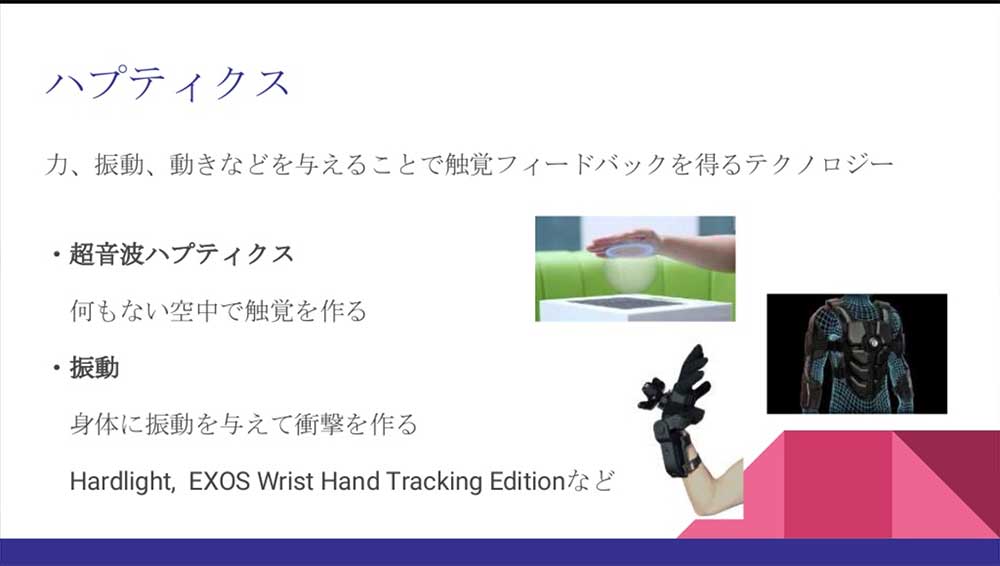

ハプティクスは、力や振動、動きなどを与えることで触覚フィードバックを得るテクノロジー全般のことを指している。超音波ハプティクスは、音波で抵抗感を作る物で、振動で身体に衝撃を作る物がある。

聴覚へのアプローチには、3D立体音響とHRTF、バーチャルサラウンドなどがあるが、これらは日常的に使われており、VR専用というわけではない。

味覚と嗅覚へのアプローチとしては、味ディスプレイとVAQSO VRがある。味ディスプレイは、基本5味の電解質を溶かして固めて、電流をかけることで味を制御し、甘味、酸味、塩味、苦味、うま味の基本味を再現するというものだ。

VASO VRは、カートリッジの中の匂いを、ファンで送り嗅覚を再現するというものである。

思考入力は、なろう系では頻繁に登場する技術のひとつだ。こちらは、強く思ったときや考えていることの入力技を発動するときや、掲示板への書き込みなどで描かれている。こちらを現実でやろうとするときは、デルタ波δ、シータ波θ、アルファ波α、ベータ波βの検出自体は可能で、こちらの情報を元に機械学習させることで、車いすなどを制御することはできる。

また、なろう系では体感時間の加速という技術も登城する。こちらは、走馬灯のように時間を加速するというものだ。VRゲームでは、『Superhot』など動いている間時間が進むシステムが採用されているものがあり、擬似的に体験することができる。

こうしていると、空想の世界のテクノロジーもいくつかは現実世界でも登場し始めていることがわかる。今後は、こうしたものがより当たり前に使われる時代がやってくるのかもしれない。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。