04.08

【World MR News】「xRLT vol.03 ~オンラインでやってみようスペシャル~」レポートその③

3月6日に開催された、TMCN / HoloMagicianが主催するXR関連のライトニングトーク大会「xRLT vol.03」。オンラインでの開催となった今回、全18名の登壇者が発表を行ったが、こちらではその中から後半に登壇した6名の発表をピックアップしてご紹介していく。

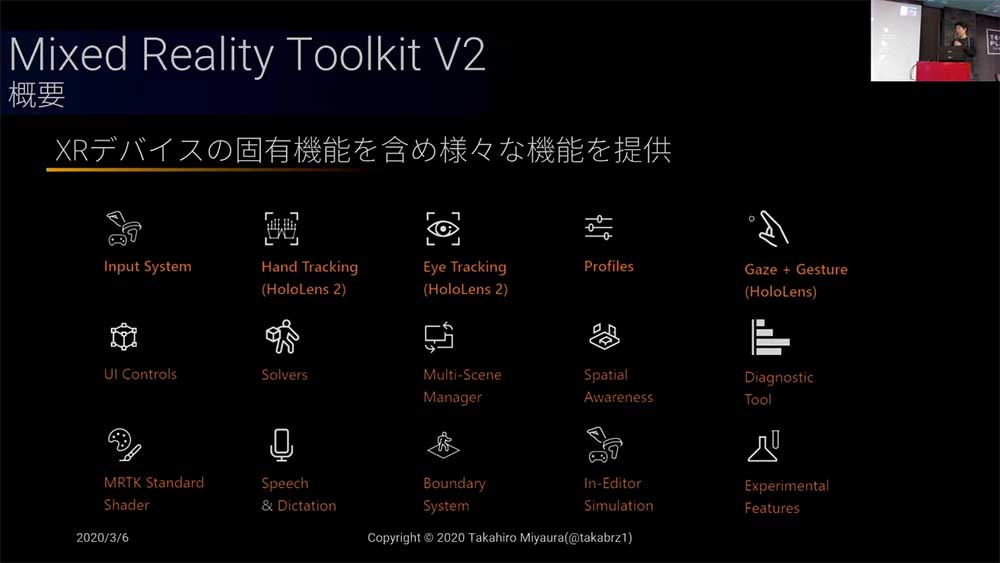

「Mixed Reality Toolkitと戯れ続けると面白いことが多かった話」by 宮浦恭弘氏

宮浦恭弘氏からは、「Mixed Reality Toolkitと戯れ続けると面白いことが多かった話」というタイトルでLTが行われた。

Mixed Reality Toolkit(以下MRTK)V2は、Unity向けOSSライブラリとして最近開発できるようになった。V2.2.0以降は、試験的にARFoundationも使えるようになっている。MRTKは、もともと『HoloLens』用のものであるため、『HoloLens2』の機能系も追加されているが、XRデバイス固有の機能を含めて、様々な機能が提供されるようになった。

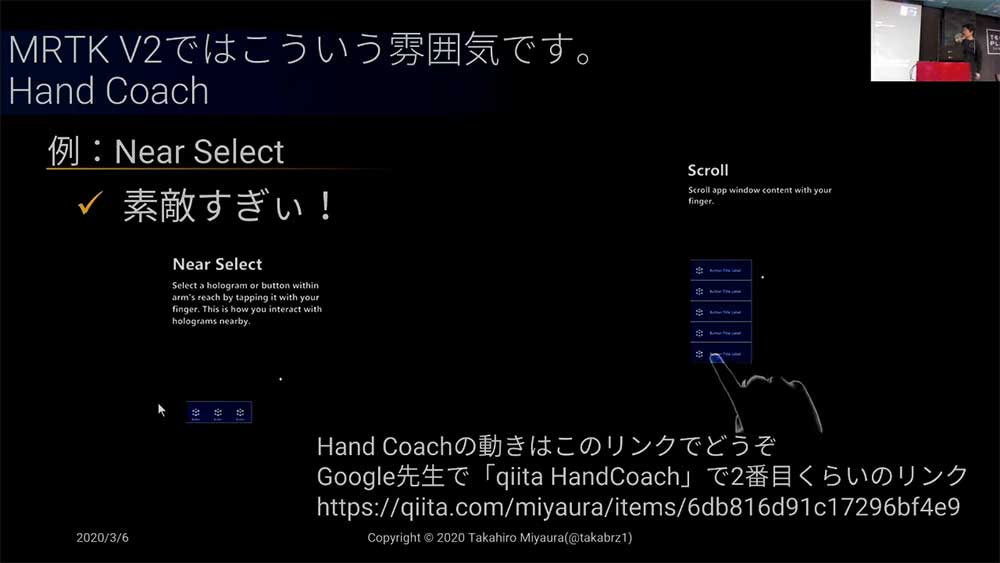

宮浦氏は、MRTKをAR Foundationで動かすことを興味本位でやっていたが、それが採用されることとなった。そうこうしているうちに、MRTK V2.3.0がリリースされる。こちらでは、宮浦氏がお気に入りの「Hnad Coach」が追加されている。

「Hnad Coach」といえば、Mixed Reality Desigh Labsの『Lunar Module』という月面着率ゲームをMRで再現したものが有名だ。その中に、使い方を紹介するためにハンドジェスチャーを模倣する形で説明してくれる機能が含まれている。

こちらがお気に入りで、時々抽出して遊んでいたという。

こちらが、MRTK V2では、半透明な手が出てくる渋いスタイルになった。

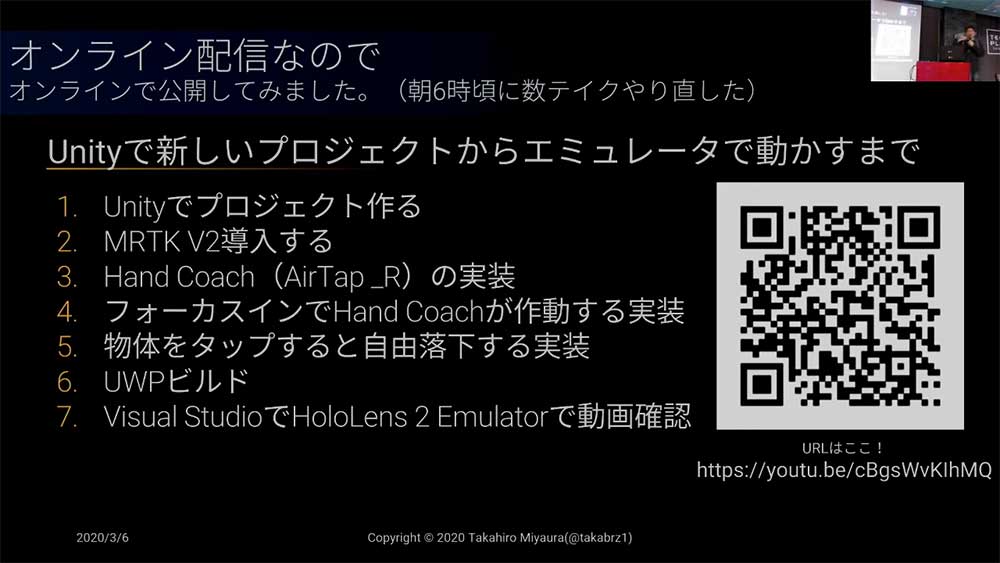

これを利用したサンプルを作ったのだが、今回はオンライン登壇ということで作り方もYouTubeで公開している。MRTKは設定が多いため、文字や静止画を見るよりも動画の方がわかりやすいそうだ。

「こまかすぎて伝わらないHoloLens 2の小ネタ101」by 中村薫氏

ホロラボの中村薫氏からは、「こまかすぎて伝わらないHoloLens 2の小ネタ101」というタイトルでLTが行われた。ちなみに最初のタイトルは101と付けられていたが、そんなになかったということで、時間が許す限りピックアップして小ネタが紹介されている。

まず操作編として、勝手にブルームができないことが紹介された。ただし、勝手に作ること自体は可能となっている。

作った!(公開こそ今になったものの作ったのはアメリカで Holo2 を触ってた5月3日)#HoloLens pic.twitter.com/LRy3EcplxS

— 広務(Hiromu) (@hi_rom_) December 30, 2019

その代わりに、新しいスタートジェスチャーが出来るようになった。手首のところのウィンドウズマークが出現し、そこを押すとスタートメニューを表示させることができる。しかしこれでは両手でやる必要がある。そこで、親指と人差し指をくっつけって離すことで、片手でスタートジェスチャーも行えるようになっている。

従来までのAirTapもできるが、『HoloLens1』のときは認識出来なかったが、手を開いた状態のAirTapや中途半端に手を閉じたときのAirTapもできるようになっている。こちらは手からRayが飛ぶ形になるが、なかなか操作が難しいそうだ。

特徴編としては、『HoloLens2』では重量バランスの改善でかなり被りやすくなっている。軽くなったと言われることもあるが、重さ自体は4グラム程度の差しかない。しかし、被ったまま1日過ごしても苦にならないため、かなり楽になったそうだ。

視野角(表示エリア)も広がっている。2メートルほど先にキューブを敷き詰めたときに、概ね縦横1.5倍ずつ増えている感じになる。

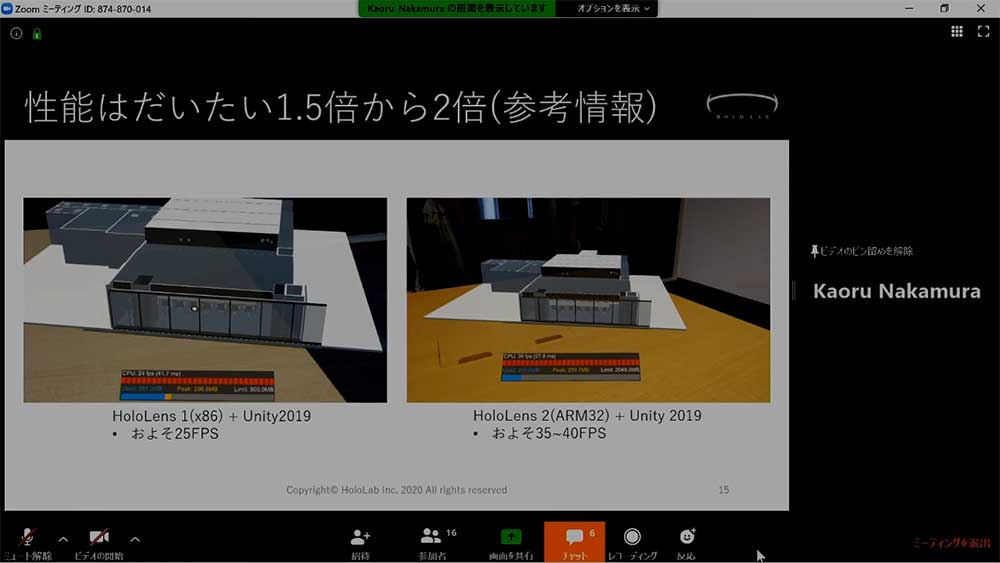

Eye Trackingは、通常は目に見えないがカメラをかざすと赤外線が見える。こちらは、レンズ部分に取り付けられたセンサーから取り込む。『HoloLens1』に取り込んだデータが25FPSだったのが、『HoloLens2』では35~40FPS程出るようになり、性能は約1.5倍から2倍ほどに向上している。

ヘルメット統合の『HoloLens2』も登場した。ちなみに「Oder Tody」のボンタンを押すと404エラー(ページが見つからない)になるそうだ。

ACアダプターは18WのUSB-PDになっており、急速充電が可能になっている。当然のことながら、PD対応のモバイルバッテリーでも充電が行える。

設定編としては、Windows Helloの虹彩認証が使えるようになった。また、セキュリティキーという物理的なキーを使用してサインインすることもできる。ログイン時のPIN入力は切ることができる。毎回起動する度にPIN入力が必要になるが、面倒なときはオフにすることができる。

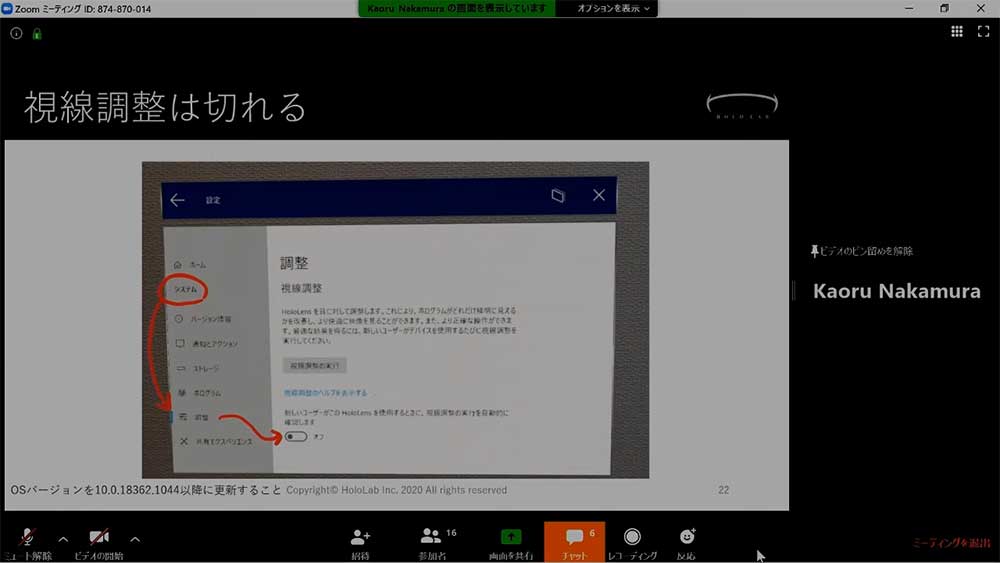

別の人が被り直すと、アイトラッキングの調整が入るが、こちらもオフにすることができる。

デバイス接続編では、USBメモリの読み書きが行えるようになった。直接USBメモリを挿せるほか、キーボードとマウスで操作が行える。また、展示会などで便利なUSB有線LANでの接続も行える。さらに、USBハブで増設することも可能だ。しかし、これをやってしまうとPCからデプロイできずにリモートからやらなければいけなくなる。

現在、『HoloLens2』の本を執筆中だという中村氏。こちらは開発情報なしのユーザー向けになっており、5月末頃に発売される予定だ。

「Azure KinectとMagic Leapでデモ作りました。」by HirokiKoike氏

HirokiKoike氏からは、「Azure KinectとMagic Leapでデモ作りました。」というタイトルでLTが行われた。同氏が先月公開したのが、Azure Kinect1台から取得した3Dデータを、点群のまま『Magic Leap』とiPhoneに配信し、相互に送りあってコミュニケーションを取るというものだ。

開発したのは、外国人のエンジニアふたりだ。今年の2月10日に、ドコモよりレンタルした2台の『Magic Leap』が届いた。それを見たエンジニア陣のテンションが上がり、2週間貸してくれと言ってきた。その理由が、ホロポーテーションをやりたかったからだという。

このホロポーテーションとは、2016年にマイクロソフトが発表した、『HoloLens』とホログラムを使うことで、動画やスマートフォンではできないようなコミュニケーションが実現できるというデモだ。

ちなみにエンジニアのふたりはXRデバイスの経験がなく、Azure Kinectも1.5ヵ月しか触っていないような状態で、本当にできるか疑心暗鬼だった。しかし、2週間でプロトタイプを作り上げている。

内訳は、スマホアプリに5日、『Magic Leap』の開発環境効率に1日、『Magic Leap』のアプリ開発に3日で作っている。結論からいうと、『Magic Leap One』と『Azure Kinect』はいいということだという。

「製造業系xRの歩むべき道とは」by Crispy!氏

Crispy!氏からは、「製造業系xRの歩むべき道とは」というテーマでLTが行われた。今回は、新分野のアプリケーション開発は難しいというしくじり先生的な話題と、既存のアプリケーションにMRの機能を追加するときはどうすればいいのかという話題。そして、おすすめの技術としてOPC UAは使えるかもしれないという話題が紹介された。

新分野のアプリケーション開発だが、こちらがこける理由は「基礎研究」「応用研究」「開発研究」という流れがあり、MR技術で失敗しやすいのが「応用研究」でとどまってしまうことだ。まだ早いからもう少し待とうということになり、いつまで経っても先に進んでいかない。

なんとか「開発研究」まで進めても、営業と商品開発の打ち合わせで「新製品なのに、売り上げの見込みが立たない」「サポートはどうするのか」といような話になり、消極的になってしまうという問題がある。

Crispy!氏は、既存のアプリケーションにMRの機能を追加しようと、いろいろと試している。やることは明確で、データを取ってUnityアプリケーションに送り込むということだ。

ソースが手に入らない場合でも、プロセスメモリ上から直接値を読んだりDLLをフックしたりと、手段はいろいろとある。とにかく見つけたらやってみることで、知見が貯まっていくという。

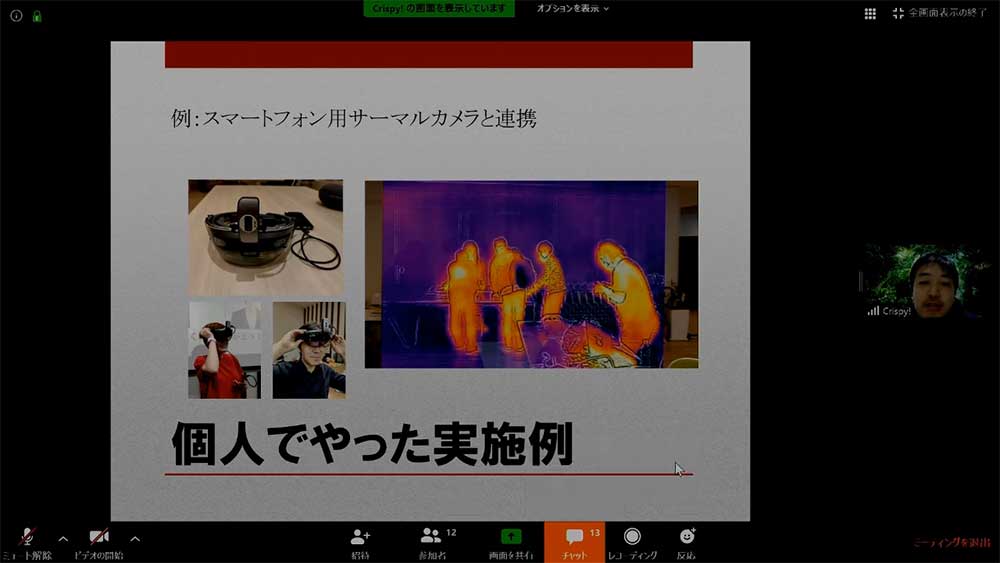

Crispy!氏個人でやった実例として、Android用のサーマルカメラを引っぱってきて『HoloLens』に送るという連携を行っている。

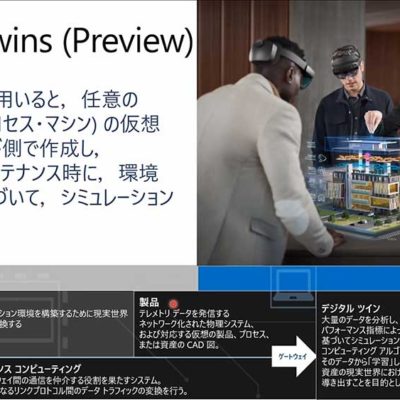

現在Crispy!氏が注目しているのが、OPC UAという技術だ。一般的にIoTというと、スマートスピーカーなどを連想する。しかし、製造業のIoTでは、自動化された工場からCloudにいろいろと送るというようなイメージのものになる。

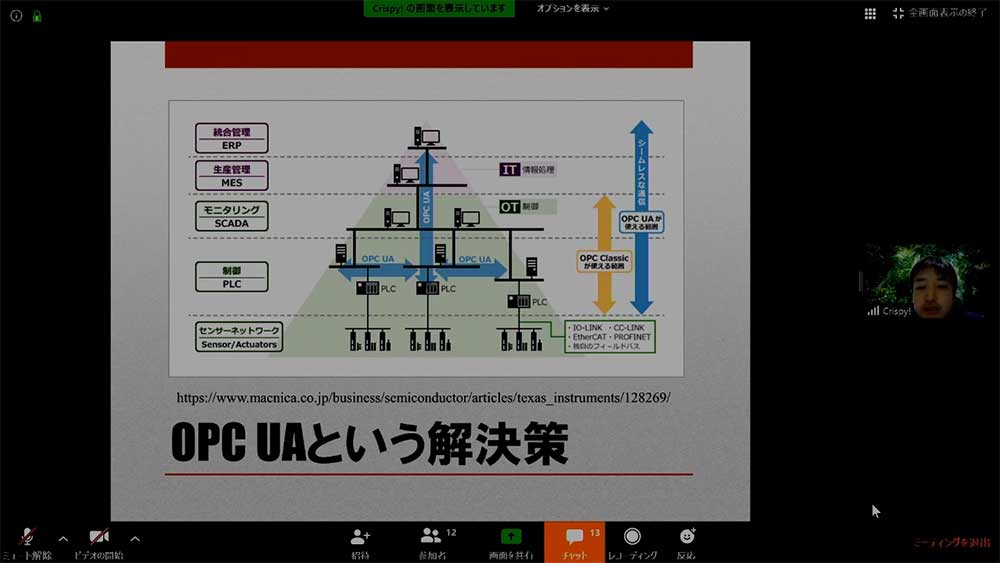

こうしたものは、これまで『HoloLens』とは通信がやりにくかった。その理由は、様々な思惑が絡み合い通信規格が乱立していたからだ。しかし、OPC UAという新しい統合規格が登場し、かなりやりやすくなった。

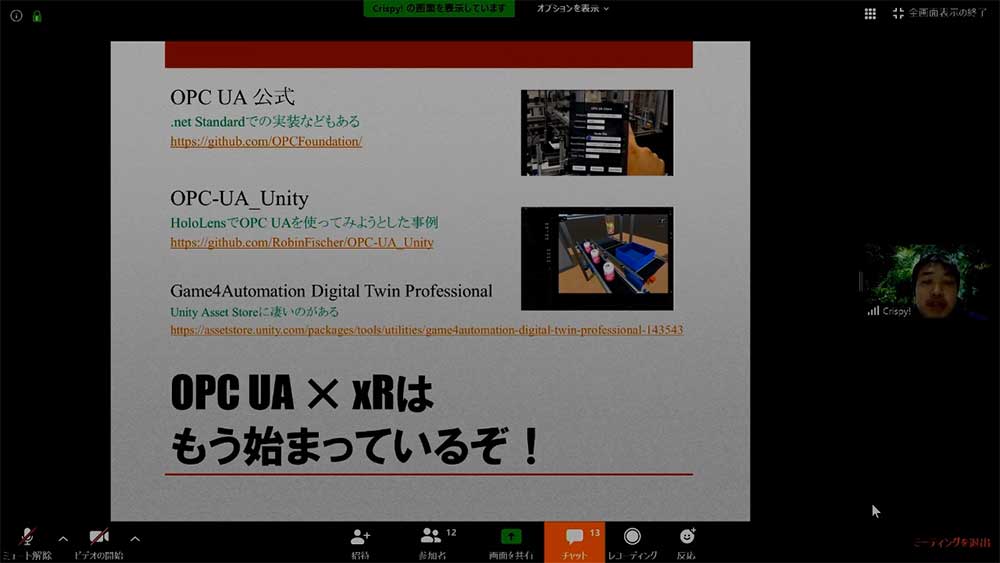

OPC UAの公式では、.net Standardなどオープンになっている。すでにOPC UAを『HoloLens』でやろうとしている学生が作った例もGit hubで公開されている。Unity Asset Studioに『Game4Automation Digital Twin Professional』というのがあり、有料版では実際にOPC UAクライアントも使用でき、こちらでパン工場などのシミュレーションも行えるようになっている。

「Oculus Questで点群を見る」by hiro6391氏。

hiro6391氏からは、「Oculus Questで点群を見る」というタイトルでLTが行われた。今回は、「Unity道場 建築スペシャル2」で、ホロラボの龍 lilea氏がやった点群ビジュアライゼーションにインスパイアされたものだ。

最近様々な点群データが公開されているが、たとえばUnity Japan Officeの点群データは1億点以上ある。そのままでは『Oculus Quest』で見ることはできないため、LODによる軽量化が不可欠だ。

検索してみると、Unityプロジェクトがあることがわかった。結論としては、下記のURLの物を使うとできるという。

GitHub – SFraissTU/BA_PointCloud: PointCloud-BachelorThesis

https://github.com/SFraissTU/BA_PointCloud

下記が実際に作った物の動画だ。カメラの真ん中に来ると濃くなり、遠くや画面の端は薄く表示される。これにより、LODが効いていることがわかる。

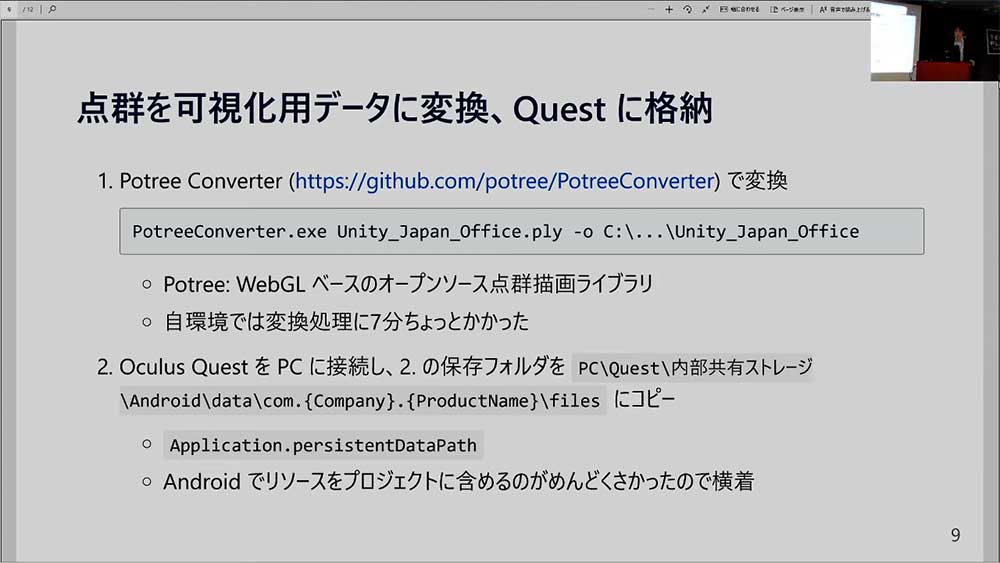

こちらのやり方は、まず点群を可視化用データに変換してから『Oculus Quest』に格納している。『Protree Converter』というコンバーターが存在しており、そちらで変換を行う。

Protreeとは、WebGLベースのオープンソース点群描画ライブラリのことを指す。そちらをUnityベースで使えるようにしたのが『Protree Converter』である。hiro6391氏の環境では、点群処理に7分ほどかかった。

可視化用データを『Oculus Quest』に格納するときは、『Oculus Quest』をPCに接続し、出力したフォルダを内部共有ストレージにコピーする。これでパスがすぐに見られるようになる。

Androidでビルドするときは、パッケージのひとつのファイルになってしまい展開するのがめんどうだったため、今回はこの手法を採用している。

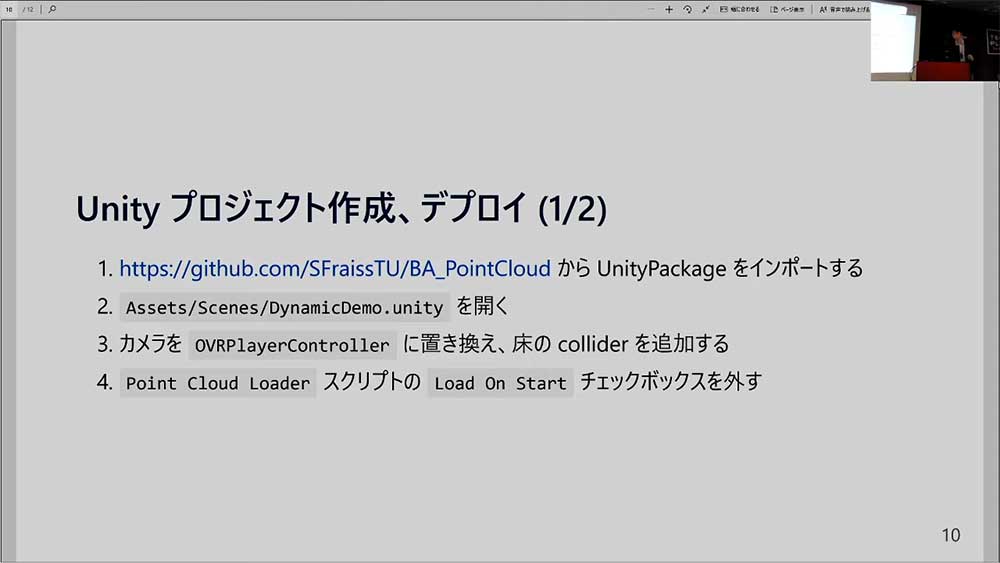

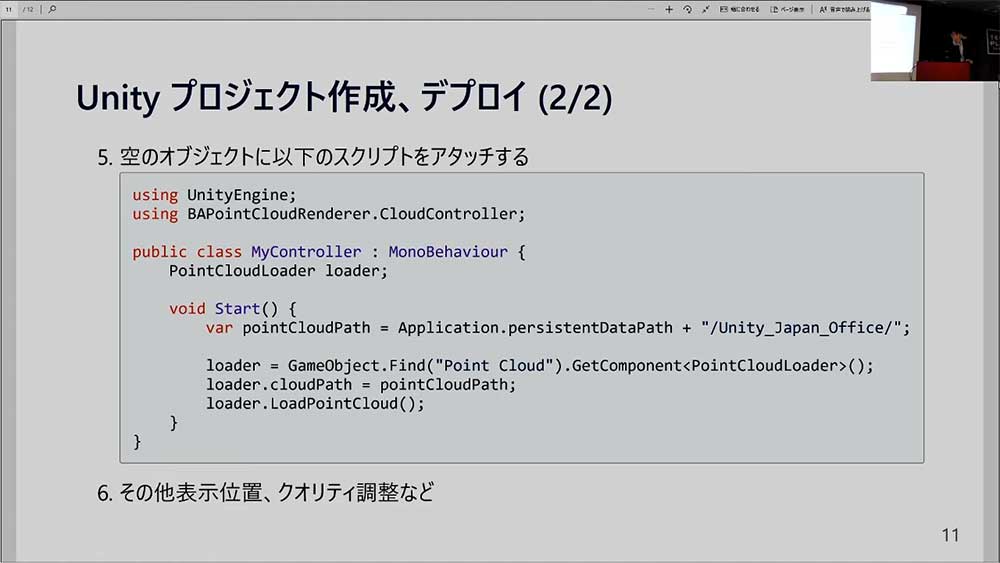

GithubからUnityPackageをインポートし、サンプルのシーンを開く。続いて、『Oculus Quest』で動くようにOVRPlayerControllerに置き換え、床のcoliderを追加する。最初にPoint Cloud LoderスクリプトにLoad On Startのチェックボックにチェックが入っているので、そちらを外しておく。

空のオブジェクトにスクリプトをアタッチして、表示位置やクォリティの調整を行う。基本的にはこれだけで、先ほどの動画のような物が作ることができる。

「HoloLens 2 裏話(仮)」by 上田欣典氏

今回のイベントのトリを務めたのは、日本マイクロソフトMixed Reality Marketing プロダクトマネージャーの上田欣典氏だ。今回は個人としての見解で、オフィシャルのものではないと強調。そのため、技術的な話題もなしとなっていた。

いまから約1年前、夜中に日本マイクロソフトのオフィスに集まりMWCで行われた『HoloLens2』の発表をリアルタイムに見るというイベントが開催され、大いに盛り上がった。ちなみに1年前は、上田氏もスペインのバルセロナに行き生で見る予定だったが、来るなと言われ、この夜中のイベントが開催されることになったそうだ。

しかし、今年は違った意味でMWCに泣かされた。新型コロナウィルスの影響で、イベントその物がなくなってしまったのだ。そのため、今回話す裏話もなくなってしまったという。

今回のイベントも含めて、新型コロナで様々な影響が出ているが、「僕らは元気です」と語る上田氏。みなさん貯金は貯めていますか(50万あれば十分)? といい、もうすぐ約束の春が訪れるとコメント。

あの話題のグラスがいよいよ春に入手できるようになる前に、3月には『Azure Kinect DK』が発売になる。

コロナの影響はあるが、「順調です!」力説する上田氏。早く手に入れたく仕方がないという人は多いと思うが、早く春が訪れることを願おう。

▲最新の情報は、こちらのQRコードで見られる!?

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。