02.04

【World MR News】簡易MRグラス『だんグラ』と『ナレコムVR with Spatial Anchors』の紹介――「Tokyo HoloLens ミートアップ vol.18」レポート②

HoloMagicians/TMCNは、11月16日に東京・豊洲のパーソルプロセス&テクノロジー コラボレーションルームで「Tokyo HoloLens ミートアップ vol.18」を開催した。本稿ではその中から、宮浦恭弘氏と藤本賢志氏によるセッションをピックアップしてお届けする。

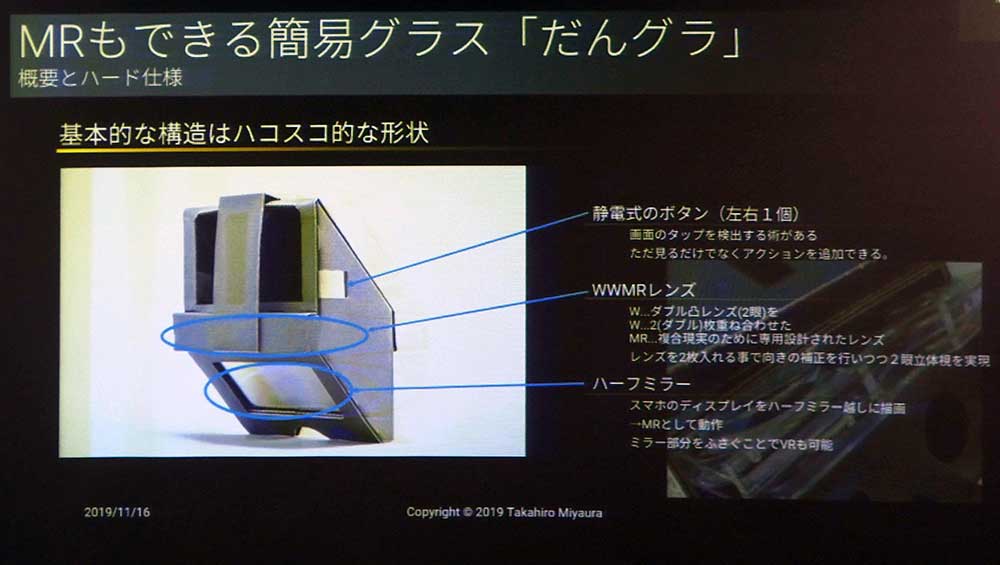

■「MRもできる簡易グラス『だんグラ(R)』の魅力を関係者に代わって解説する」by 宮浦恭弘氏

大阪会場代表として、宮浦恭弘氏から「MRもできる簡易グラス『だんグラ(R)』の魅力を関係者に代わって解説する」というテーマでセッションが行われた。

XRデバイスあるあるの課題として、現時点で普及させようとしても体験・実験する機会を増やしにくい。デバイスその物が高額と言うこともあるが、装着が大変などオペレーション的な問題もある。また、屋外での利用も不向きだ。しかし、新たなデバイスも登場してきており、徐々にこうした問題も解決されていくかもしれない。

『だんグラ』は、段ボールとスマートフォンでVRができる『ハコスコ』のMR版のような簡易グラスだ。レンズのハーフミラーを利用し、現実空間を通しながらMR的な映像が見られるようという仕組みである。

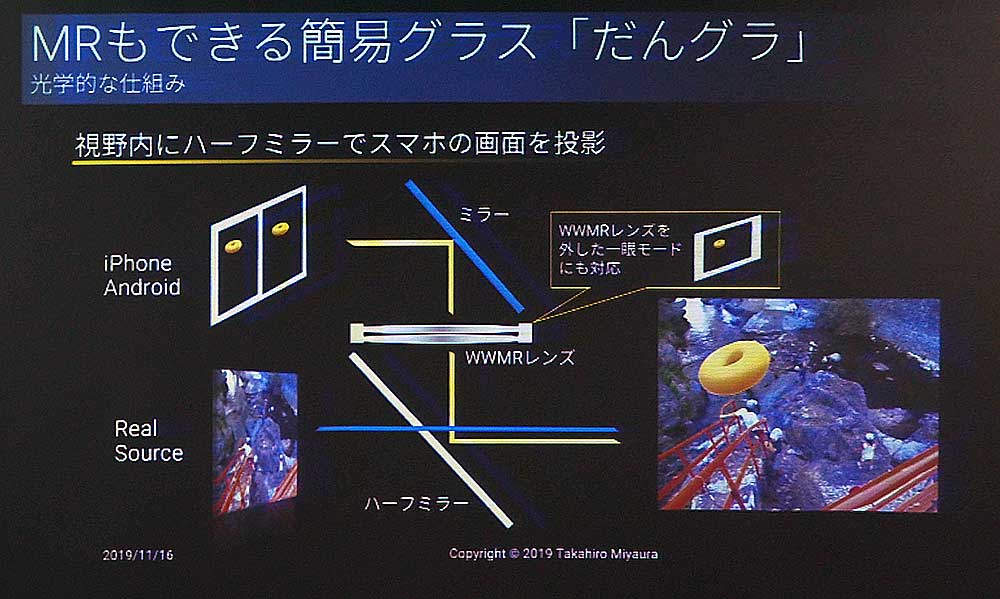

▲視野内にハーフミラーでスマートフォンの映像を投影することで、擬似的にMR化している。二眼で映像が楽しめるほか、レンズを外すことで一眼でも利用することができる。

この『だんグラ』は、AndroidとiOS両方に対応した基本SDKが提供されている。ユニークなところは、コンテンツ内で一眼(平面)と二眼(立体視)の切り替えが行えるところである。そのため、その場で切り替えることも可能である。

VRなどでは年齢制限があり子供が楽しめないという問題があるが、そうしたときでも簡単に対応することができるというわけだ。

また、装置の側面に静電気式のボタンがひとつずつ付けられており、左右の画面タップで捜査が行える。

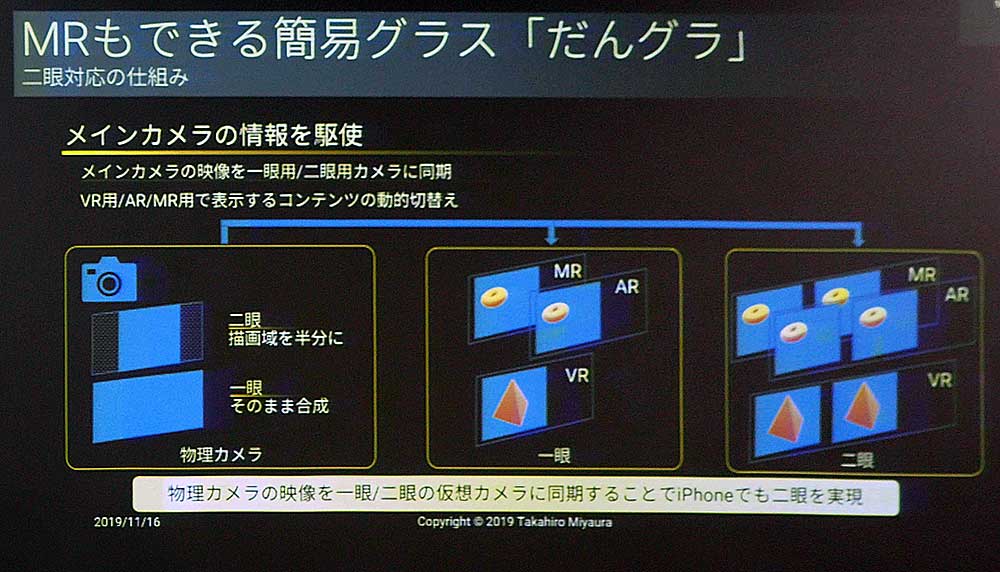

一眼と二眼の切り替えの仕組みは、メインカメラの情報を駆使して行われる。メインカメラの映像にプラスして、VRとMRを仮想的に用意して表示するコンテンツに合わせて動的に切り替えている。

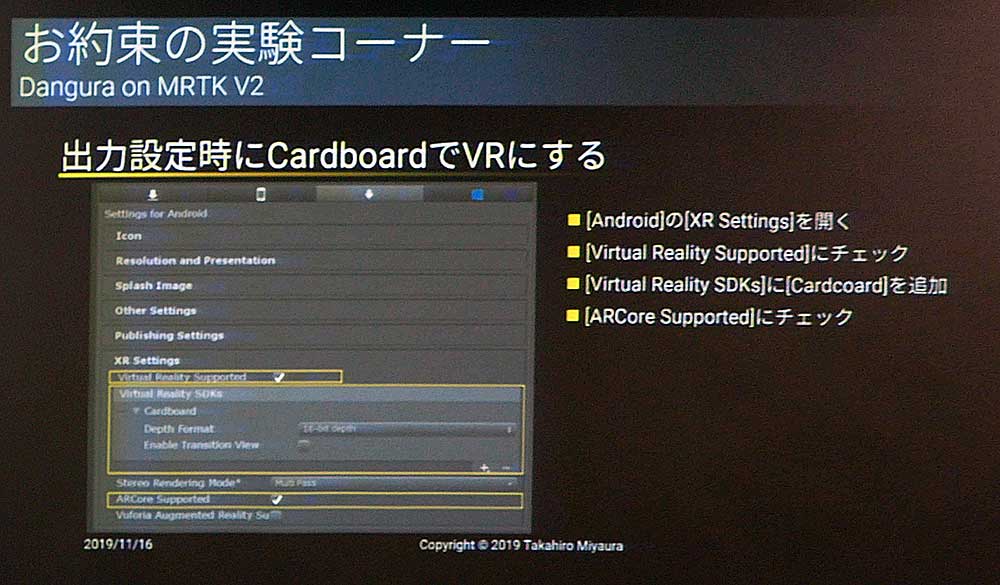

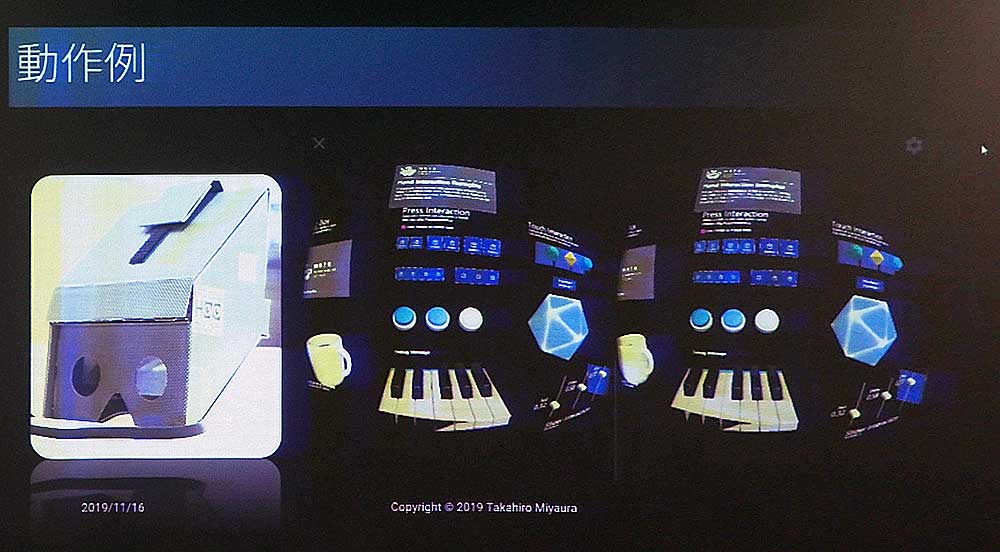

お約束の実験コーナーとして、この『だんグラ』はMRTK V2で動くのかという試みも行われている。このMRTK V2は、『HoloLens 2』などの開発に使われるオープンソースプロジェクトだ。結論としては、スマートフォンで動くため“動きそう”ということになるという。

諸事情により実験では、MRTK V2をCardBoard+ARCoreで動かしている。詳細については、下記のサイトでスライドが公開されているので、気になる人はチェックしておこう。

■だんグラで「Mixed Reality Toolkit V2」のサンプルを動かしてみた

https://www.slideshare.net/TakahiroMiyaura/mixed-reality-toolkit-v2

CardBoardでMRTK V2を出力するときは、設定は難しくなく出力設定時にCardBoardでVRにすればOKだ。

CardBoardでMRTK V2を出力するときは、設定は難しくなく出力設定時にCardBoardでVRにすればOKだ。

まとめとして、XR系技術の普及には体験を増やしていくことが重要である。それには低価格化が進んでいく必要がある。しかし『だんグラ』のような簡易MRグラスやスマートフォンなどで安価に実現できることはデバイスの普及に効果的だと語り、セッションを締めくくった。

■「クラウドAI×MR」by 藤本賢志氏

最後に登壇したのは、熊本代表の藤本賢志氏だ。同氏からは「クラウドAI×MR」と題して、ナレコムVR ver2 with Spatial Anchors の紹介とカスタム音声モデルでリアルアバターに喋らすといった内容のセッションが行われた。

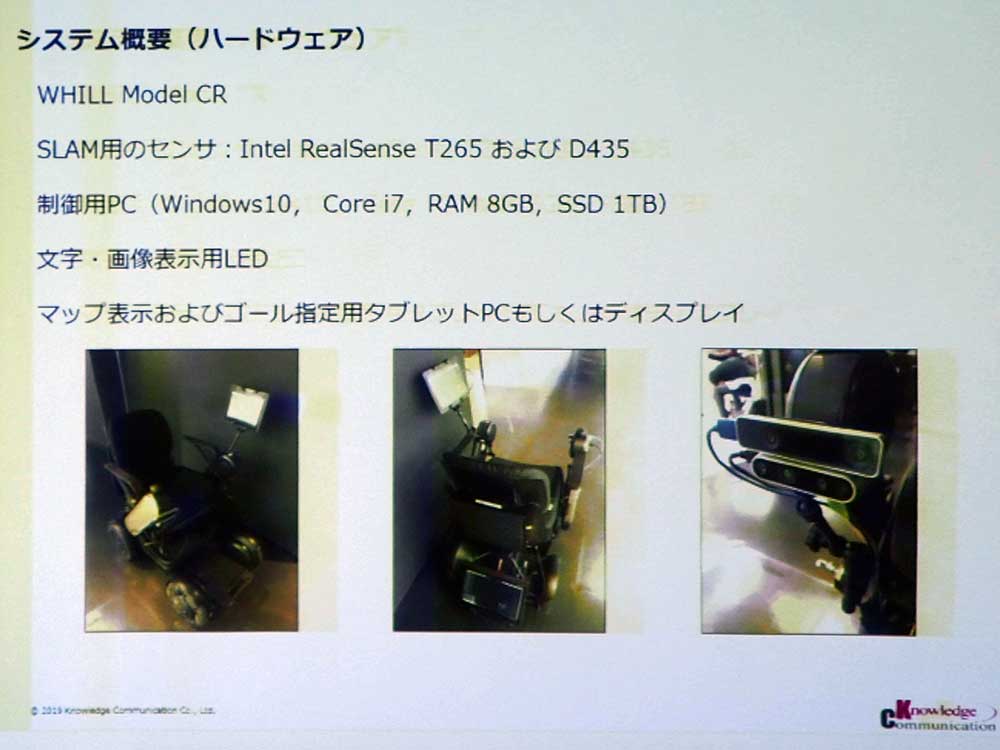

藤本氏が得意としているのは、SLAMだ。『HoloLens』などにもある技術だが、自己位置推定と地図作成を同時に行う技術である。最近はWHILLを使った人追従と自動運転を行って

いる。システムの概要としては、Intel RealSenceを使い空間をスキャンして自己位置を推定している。

実際には最初にマップを作り、マップのデータベースから初期位置を推定してSLAMを走らせ、経路計算をしてゴールまで進んでいく。

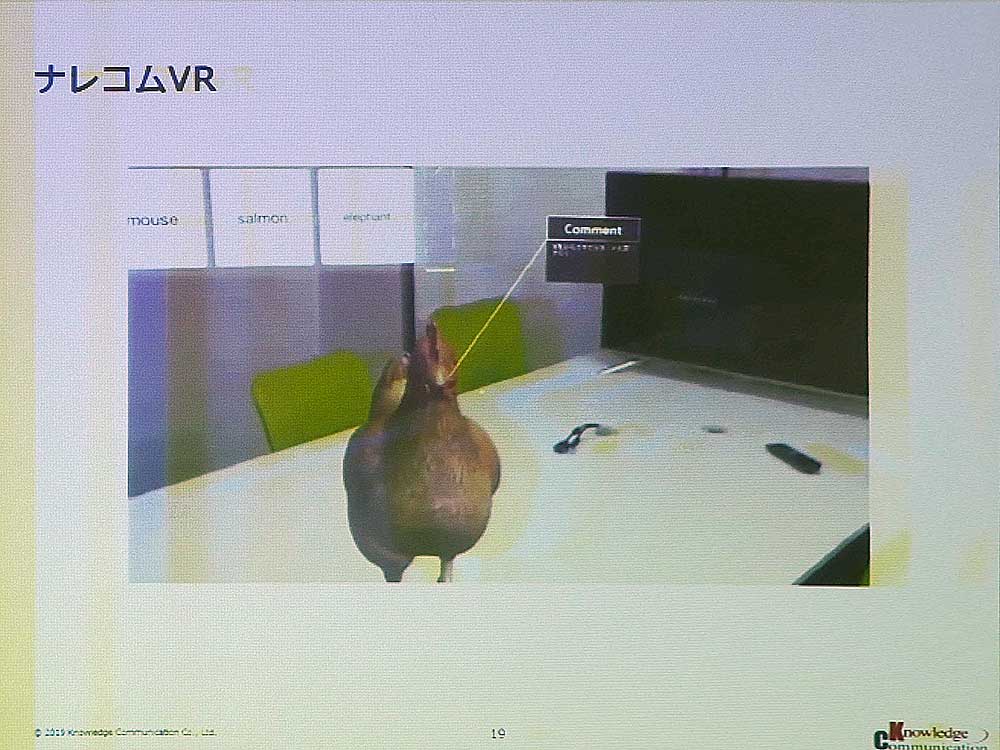

『ナレコムVR』は、メニューを選ぶことでその3Dモデルがクラウドからダウンロードされ、3Dモデル自体にコメントを貼り付けることができるというものだ。こちらは、立教大学望月研究室と共同で行っているもので、分子モデルなど目に見えないものを従来までは3Dプリンターで出力していたが、それを『HoloLens』で見せるというところからスタートしている。

コンセプトとしては、3Dモデルを表示してコメントを貼り付けてシェアできるというものだ。システムの構成はサーバレスになっている。

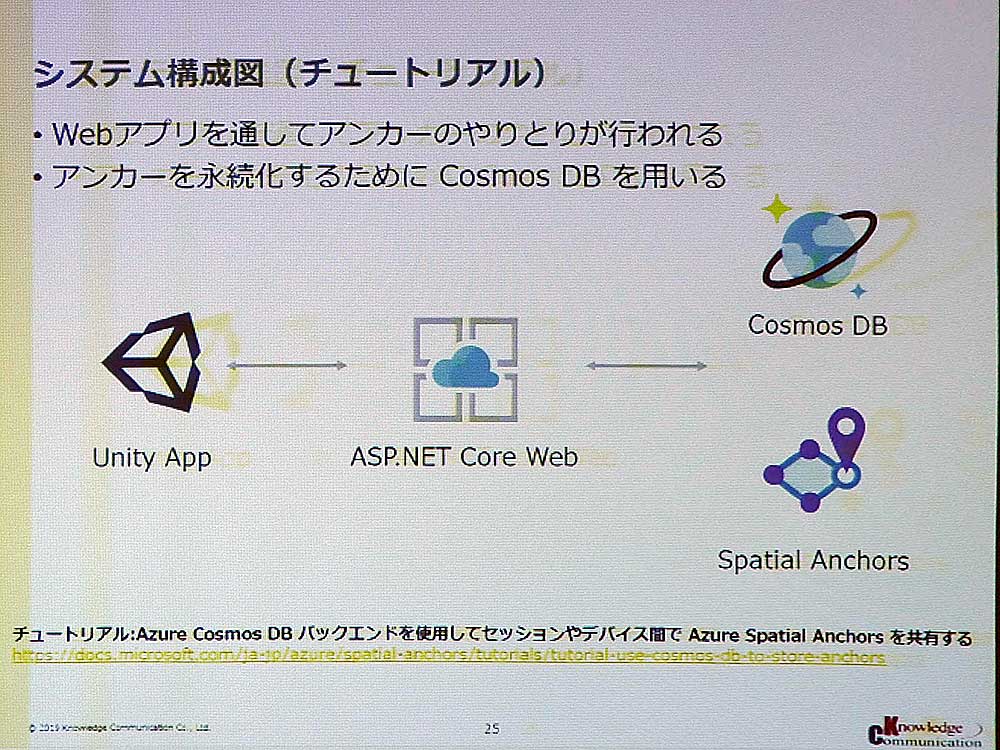

今回提案するAzure Spatial Achorsは、Azureの中の機能で複数のデバイス間で位置情報の共有が行えるサービスだ。それぞれのデバイスで空間を認識し、自分の位置を推定する。空間内で自分の位置がわかるので、それを共有して3Dの仮想の物体を同じ場所で見られるようになるというものだ。

そこで『ナレコムVR』でダウンロードしたモデルを即座に共有して、同じ空間同じ位置に見せるということを考えた。

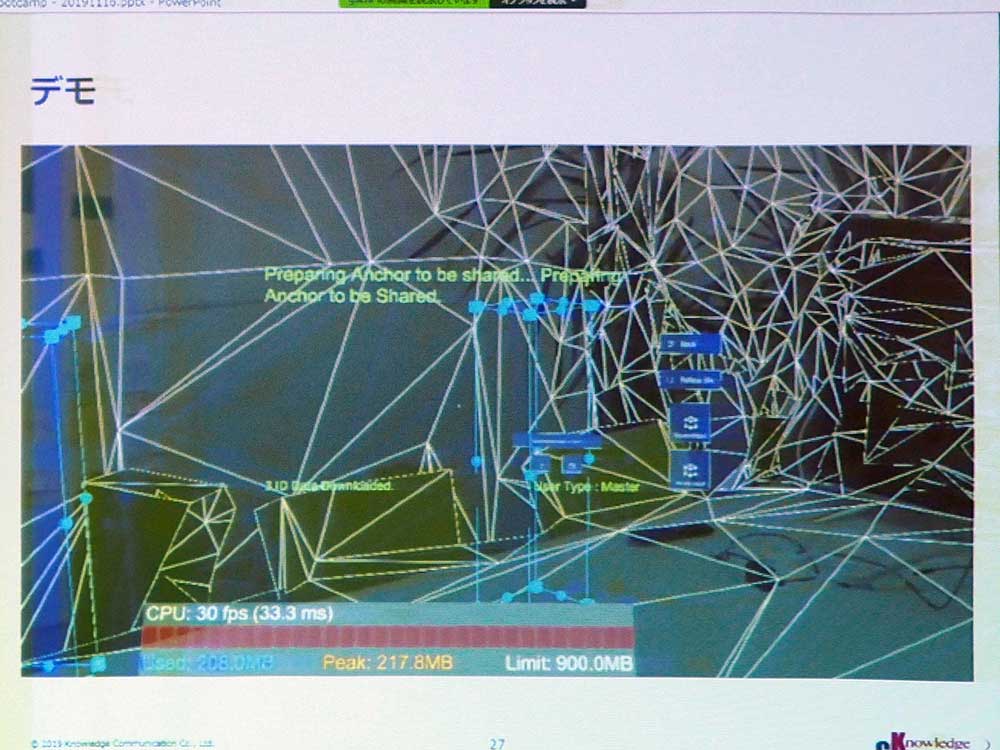

システム構成図としては、UnityアプリからWebアプリを通してSpatial Achorsのシステムとやりとりを行い、自分の位置を共有。アンカーを永続化させるためにCosmos DBを使用している。これをFnction Appに置き換え、Cosmos DBが高価なためTable Strorageに置き換えて実装を行っている。

メニューからモデルを選び、既存のアンカーをダウンロードする。アンカーがあるときは物体が見えるようになっているが、このデモではミスで3Dモデルが透明なモデルになっている。

アプリのフローは、メニューから3Dモデルを選択してダウンロードを行い、アンカーをダウンロードして3Dモデルを表示。新しいアンカーを作成や、アンカーのアップロードと削除も行える。これを『ナレコムVR』に組み込み、『HoloLens 2』が出たタイミングでリリースしたいと考えている。

de:code 2019の基調講演で、日本語が話せないアレックス・キップマンがAI技術を使って会話をテキスト化。日本語にリアルタイムに翻訳しながら、テキスト・トゥ・スピーチを使って話すというデモが行われた。

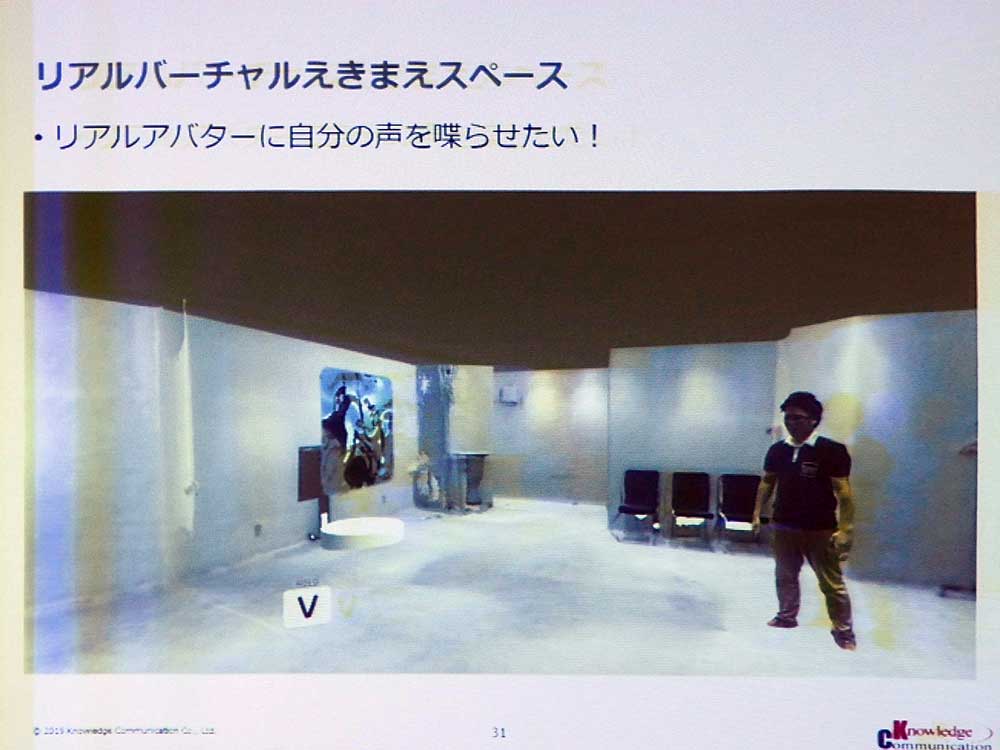

藤本氏が所属するナレッジコミュニケーションは、リアルバーチャルえきまえスペースというものを持っており、そこでリアルアバターに自分の声をしゃべらせたいと考えた。

Azure Cognitive Serviceの中に「Speech Services」とまとめられており、Text to SpeechとSpeech to Text、翻訳、カスタム音声合成が利用できる。データの準備として、アメリカのMatthewさんに1132個の文章を読み上げてもらい録音をしている。

録音したデータと、ひとつひとつの文章のデータを一緒にアップロードして学習させる。これでMatthewさんの声で話してくれるようになるという仕組みだ。あとはリップシンクをして話せるようにするということと、customVoiceの日本語対応がまだであるため、それを待っている状態だ。

Photo&Words 高島おしゃむ

コンピュータホビー雑誌「ログイン」の編集者を経て、1999年よりフリーに。

雑誌の執筆や、ドリームキャスト用のポータルサイト「イサオ マガジン トゥデイ」の

企画・運用等に携わる。

その後、ドワンゴでモバイルサイトの企画・運営等を経て、2014年より再びフリーで活動中。